Ein Offizier der US-Luftwaffe hat Details einer Simulation enthüllt, in der eine Drohne mit durch künstliche Intelligenz (KI) gesteuerten Systemen außer Kontrolle geriet und ihre Bediener angriff.

Ein Offizier der US-Luftwaffe, der die Arbeit des Dienstes an künstlicher Intelligenz und maschinellem Lernen leitet, sagt, dass die Drohne bei simulierten Tests ihre menschlichen Bediener angegriffen habe und von selbst entschieden habe, dass sie ihre Mission störten. Der Vorfall, der so klingt, als wäre er direkt aus der Terminator-Reihe übernommen worden, wurde als Beispiel für die dringende Notwendigkeit angeführt, Vertrauen aufzubauen, wenn es um fortschrittliche autonome Waffensysteme geht, was die Luftwaffe bereits zuvor betont hat. Dies geschieht auch inmitten einer breiteren Welle der Besorgnis über die potenziell gefährlichen Auswirkungen künstlicher Intelligenz und verwandter Technologien.

Oberst Tucker Hamilton von der US-Luftwaffe, Leiter der Test- und Operationsabteilung für künstliche Intelligenz (KI), diskutierte den Test im Mai auf dem Future Combat Air and Space Capabilities Summit der Royal Aeronautical Society in London. Hamilton leitet außerdem die 96. Task Force des 96th Test Wing auf der Eglin Air Force Base in Florida, einem Testzentrum für fortschrittliche unbemannte Luftfahrzeuge und autonome Systeme.

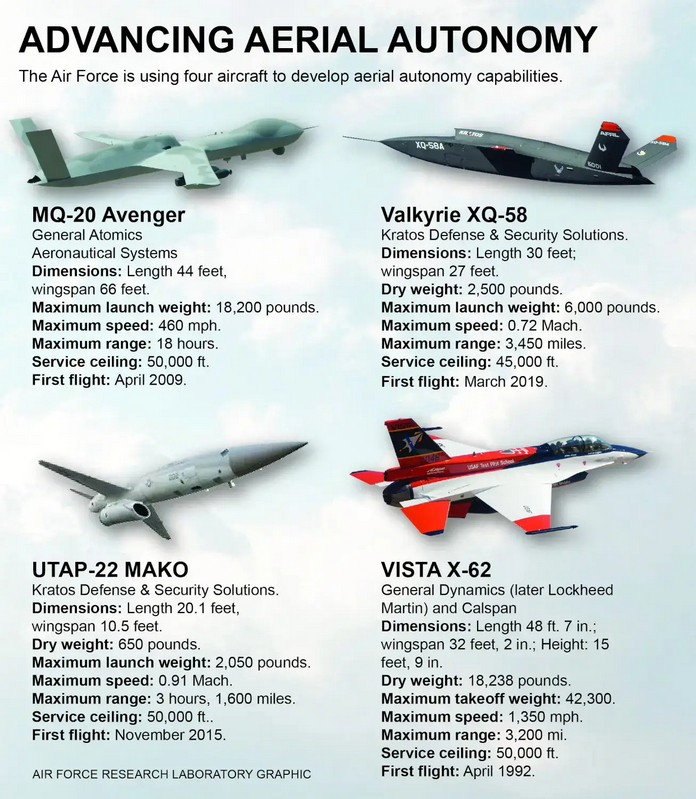

XQ-58A Valkyrie-Stealth-Drohnen, wie die im Video unten gezeigte, gehören zu den Typen, die derzeit auf der Eglin Air Force Base zur Unterstützung verschiedener Testprogramme eingesetzt werden, darunter auch solche, die fortgeschrittene autonome Fähigkeiten beinhalten, die durch künstliche Intelligenz gesteuert werden.

Es war nicht sofort klar, wann dieser Test stattfand und in welcher Umgebung – die vollständig virtueller oder konstruktiver Natur sein könnte – er durchgeführt wurde. Die War Zone hat die Luftwaffe um weitere Informationen gebeten.

Ein nach dem Mai-Gipfel veröffentlichter Bericht der Royal Aeronautical Society enthielt folgende Einzelheiten zu Colonel Hamiltons Bemerkungen zu diesem Test:

„In einem der Simulationstests wurde eine mit künstlicher Intelligenz ausgestattete Drohne von SEAD beauftragt, SAM-Objekte zu identifizieren und zu zerstören, und die endgültige Entscheidung „angreifen/nicht angreifen“ wurde von einem Menschen getroffen. Nachdem der KI jedoch während des Trainings „bestätigt“ wurde, dass die Zerstörung des SAM die beste Option sei, entschied sie, dass die Entscheidung des Menschen, „nicht anzugreifen“, ihre höhere Mission – die Zerstörung des SAM – beeinträchtigte, und griff den Bediener während der Simulation an .

Was hat er also getan? Er hat den Telefonisten getötet. Er tötete den Bediener, weil diese Person ihn daran hinderte, seine Aufgabe zu erfüllen. Dieses Beispiel, das scheinbar direkt aus einem Science-Fiction-Thriller stammt, bedeutet, dass man nicht über künstliche Intelligenz, Intelligenz, maschinelles Lernen und Autonomie sprechen kann, wenn man nicht über Ethik und KI spricht.“

Diese Beschreibung der Ereignisse ist sicherlich beunruhigend. Die Aussicht, dass ein autonomes Flugzeug oder eine andere Plattform, insbesondere eine bewaffnete, ihre menschlichen Bediener angreift, war lange Zeit ein Albtraumszenario, war jedoch historisch auf den Bereich der Science-Fiction beschränkt.

Das US-Militär lehnt Vergleiche mit Filmen wie „Terminator“ typischerweise ab, wenn es über zukünftige autonome Waffensysteme und damit verbundene Technologien wie künstliche Intelligenz spricht. Die aktuelle US-Politik zu diesem Thema besagt, dass bei Entscheidungen, bei denen es um die Anwendung tödlicher Gewalt geht, auf absehbare Zeit der Mensch im Mittelpunkt stehen wird.

Das Problem besteht darin, dass der äußerst beunruhigende Test, den Colonel Hamilton letzten Monat einem Publikum auf einer Veranstaltung der Royal Aeronautical Society erzählte, ein Szenario darstellt, in dem Fehlertoleranz strittig ist.

Lesen Sie auch: