Σήμερα θα μιλήσουμε για το deepfake, το οποίο έχει πλέον γίνει ευρέως διαδεδομένο και αρκετά συχνό φαινόμενο. Χάρη σε αυτή την τεχνολογία, η χειραγώγηση πληροφοριών έχει φτάσει σε ένα νέο επίπεδο.

Είδατε τη βασίλισσα Ελισάβετ να χορεύει στο τραπέζι κατά τη διάρκεια της μετάδοσης του μηνύματος της Πρωτοχρονιάς; Ή άκουσε την ομιλία του Κιμ Γιονγκ Ουν για τη δημοκρατία ή θαύμασε τον Σαλβαδόρ Νταλί, που μίλησε για τον θάνατό του (γιατί δεν πιστεύει σε αυτόν);

Όλα αυτά τα καταπληκτικά βίντεο έχουν ένα κοινό χαρακτηριστικό - είναι ψεύτικα. Το Deepfake είναι μια τεχνική δημιουργίας και δημοσίευσης ψευδών πληροφοριών με τη μορφή βίντεο, ήχου και φωτογραφιών. Γίνεται πιο εύκολο να συναντήσετε τέτοιου είδους υλικά, γι' αυτό ετοιμάσαμε για εσάς μια οδηγία για τη δημιουργία, την αναγνώριση και την αναζήτηση deepfake βίντεο στο Διαδίκτυο.

Διαβάστε επίσης: Blockchains του αύριο: Το μέλλον της βιομηχανίας κρυπτονομισμάτων με απλά λόγια

Deepfake - τι είναι;

Το Deepfake (Deepfake) είναι στην πραγματικότητα ένα φωτογραφικό, βίντεο ή ηχητικό υλικό που δεν είναι αληθινό, ψεύτικο, δηλαδή ψεύτικο. Το Deepfake (συνδυασμός δύο λέξεων - deep learning "deep learning" και fake "fake") χρησιμοποιεί τεχνητή νοημοσύνη (AI) για βαθιά μάθηση για να δημιουργήσει την ομοιότητα ενός ατόμου με ένα άλλο σε βίντεο και άλλα υλικά ψηφιακών μέσων. Δημιουργείται από αλγόριθμους που βασίζονται σε δείγματα πραγματικής φωνής, ήχου, βίντεο ή φωτογραφίας που είναι ραμμένα μεταξύ τους. Ο αλγόριθμος παίρνει επιλεγμένες πληροφορίες από πολλά διαφορετικά μέρη και στη συνέχεια τις συνδυάζει σε ένα υλικό. Ως αποτέλεσμα, δημιουργείται κάτι νέο (ψευδές), το οποίο βασίζεται σε συνδυασμό διαφορετικών πραγματικών δεδομένων.

Αλλά δεν είναι μόνο αυτό. Το Deepfake μπορεί επίσης να «ζωγραφίσει» μια φωτογραφία από την αρχή, για παράδειγμα δημιουργώντας τα πρόσωπα χαρακτήρων που δεν υπήρξαν ποτέ.

Ποιος είναι ο σκοπός τέτοιων ενεργειών; Μεταξύ άλλων, το Deepfake χρησιμοποιείται για τη διάδοση εσφαλμένων πληροφοριών στο Διαδίκτυο (για παράδειγμα, για πολιτικά πρόσωπα ή γεγονότα), για κλοπές (για παράδειγμα, πλαστογραφίες φωνητικών εντολών) και για δημιουργία πορνογραφίας (ταινίες με διασημότητες - deepfake πορνό). Μπορεί επίσης να χρησιμοποιηθεί για εκπαιδευτικούς και ψυχαγωγικούς σκοπούς.

Διαβάστε επίσης: Σχετικά με τους κβαντικούς υπολογιστές με απλά λόγια

Deepfake - Πώς λειτουργεί;

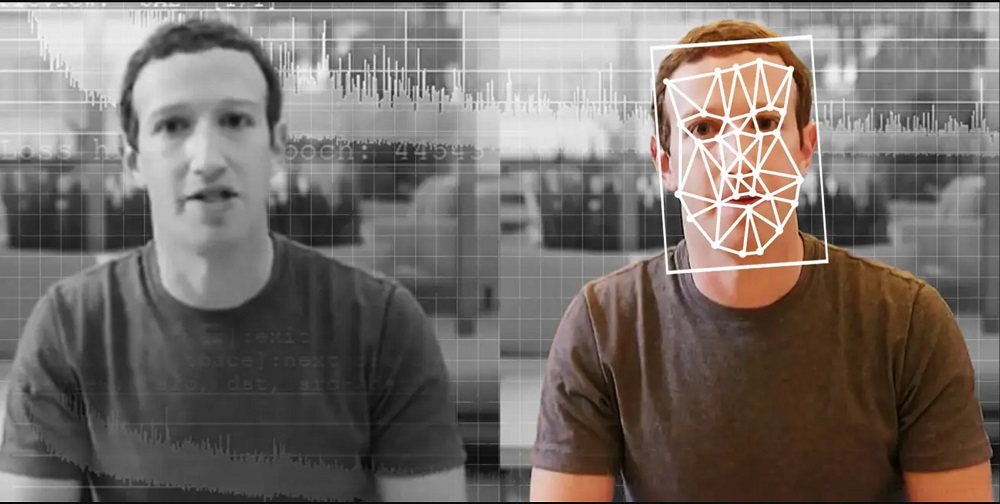

Γενικά, υπάρχουν δύο τρόποι για να δημιουργήσετε deepfake υλικό. Η πρώτη μέθοδος χρησιμοποιεί δύο αλγόριθμους. Πρώτον, ο πρώτος (κωδικοποιητής) αναζητά κοινά χαρακτηριστικά δύο εικόνων (αυτές που πρόκειται να συνδυαστούν σε μία), μετά ο δεύτερος (αποκωδικοποιητής) μπορεί να τα μεταφέρει στη νέα εικόνα. Για παράδειγμα, αν θέλουμε να δημιουργήσουμε ένα βίντεο στο οποίο ένας ηθοποιός θα κινείται όπως εμείς, ο κωδικοποιητής παίρνει την κίνηση από το βίντεο όπου χορεύουμε και ο αποκωδικοποιητής θα αντικαταστήσει ήδη το πρόσωπό μας με το πρόσωπο του ηθοποιού και θα τον κάνει να αναπαράγει τις κινήσεις μας . Το κλειδί εδώ είναι οι επιλεγμένες ενέργειες που αντιγράφονται στη νέα εικόνα (για παράδειγμα, κινήσεις, χειρονομίες, εκφράσεις προσώπου).

Ο δεύτερος τρόπος είναι μέσω των παραγωγικών δικτύων αντιπάλων (GANs), όπου δύο αλγόριθμοι συνεργάζονται. Το πρώτο ονομάζεται γεννήτρια επειδή, χρησιμοποιώντας γενικές πληροφορίες, δημιουργεί εικόνες (για παράδειγμα, την εικόνα ενός ατόμου) που συνδυάζουν τα διακριτικά του χαρακτηριστικά (ένα άτομο έχει σώμα, πρόσωπο, μάτια). Ο δεύτερος αλγόριθμος είναι ένας διαχωριστής που αξιολογεί εάν οι εικόνες που του δίνονται από τη γεννήτρια είναι αληθείς ή όχι.

Με την πάροδο του χρόνου, και οι δύο αλγόριθμοι γίνονται πιο προηγμένοι, έτσι μαθαίνουν και βελτιώνονται. Εάν η γεννήτρια έχει εκπαιδευτεί με τέτοιο τρόπο ώστε ο υπεύθυνος διάκρισης να μην αναγνωρίζει μια ψεύτικη φωτογραφία (τη θεωρεί πραγματική), η διαδικασία έχει ολοκληρωθεί.

Μια μεγάλη ποσότητα πλαστού λογισμικού μπορεί να βρεθεί στο GitHub, μια κοινότητα ανοιχτού κώδικα για σενάρια, προγράμματα και κώδικα. Ορισμένα από αυτά τα προγράμματα χρησιμοποιούνται καθαρά για ψυχαγωγικούς σκοπούς, επομένως η δημιουργία ενός deepfake δεν απαγορεύεται, ωστόσο, πολλά από αυτά μπορούν να χρησιμοποιηθούν και για εγκληματικούς σκοπούς.

Πολλοί ειδικοί πιστεύουν ότι στο μέλλον, με την ανάπτυξη των τεχνολογιών, τα deepfakes θα γίνουν πολύ πιο σύνθετα και ενδέχεται να δημιουργήσουν πιο σοβαρές απειλές για την κοινωνία, που σχετίζονται με παρεμβάσεις στις εκλογές, δημιουργία πολιτικής έντασης και εγκληματικές δραστηριότητες.

Διαβάστε επίσης:

- Παρατηρώντας τον Κόκκινο Πλανήτη: Ιστορία των Αρειανών Ψευδαισθήσεων

- Η τηλεμεταφορά από επιστημονική άποψη και το μέλλον της

Η απειλή του Deepfake - από πότε υπάρχει;

Για πρώτη φορά, τέτοιες πλαστές πληροφορίες εμφανίστηκαν το 2017. Τότε ο χρήστης είναι ψευδώνυμο deepfake δημοσίευσε στο Reddit αρκετές πορνογραφικές ταινίες στις οποίες συμμετείχαν διασημότητες, μεταξύ των οποίων Scarlett Johansson, Gal Gadot και Taylor Swift. Από τότε, αυτή η βιομηχανία αναπτύσσεται ραγδαία, επειδή σχεδόν ο καθένας μπορεί να γυρίσει ταινίες deepfake.

https://youtu.be/IvY-Abd2FfM

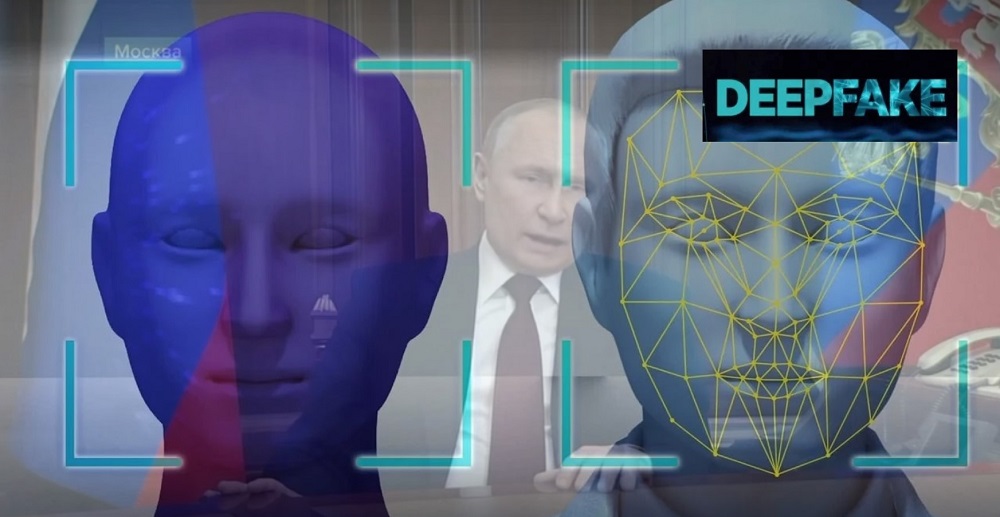

Τα τελευταία χρόνια, η τεχνολογία του deepfaking έχει αναπτυχθεί τόσο πολύ που είναι πλέον όλο και πιο δύσκολο να προσδιοριστεί αν πρόκειται για κατασκευασμένο βίντεο ή για γνήσια εγγραφή πραγματικών ανθρώπων. Ένα παράδειγμα μπορεί να είναι ένα βίντεο με ένα μήνυμα από την Ελισάβετ Β ή μια ομιλία του Μπαράκ Ομπάμα, που δημοσιεύτηκε γρήγορα σε πολλούς διαφορετικούς ιστότοπους. Το βίντεο με τη δήλωση του πρώην προέδρου των ΗΠΑ αφορούσε τις παγκόσμιες απειλές που μπορεί να προκληθούν από παραπληροφόρηση και ψευδείς ειδήσεις που δημοσιεύονται στο Διαδίκτυο. Στο υλικό που δημοσίευσε το κανάλι BuzzFeedVideos, ο Αμερικανός σκηνοθέτης και ηθοποιός Τζόρνταν Πιλ έγινε η φωνή του 44ου προέδρου των Ηνωμένων Πολιτειών. Ωστόσο, αυτή τη στιγμή η τεχνητή νοημοσύνη είναι ήδη ικανή να παράγει μια φωνή βασισμένη σε αρχειακές ηχογραφήσεις ενός ατόμου που υποτίθεται ότι εμφανίζεται σε μια ψεύτικη ταινία.

Τέτοιες προηγμένες τεχνολογίες μπορούν να γίνουν επικίνδυνο εργαλείο στα χέρια των κυβερνοεγκληματιών και των απατεώνων του Διαδικτύου στο μέλλον. Η δημοσίευση πλαστών βίντεο ομιλιών σημαντικών πολιτικών μπορεί να προκαλέσει πραγματική ζημιά σε διεθνές επίπεδο. Τέτοιες ταινίες, βασισμένες στην τεχνολογία deepfake, μπορούν να προκαλέσουν διπλωματικές συγκρούσεις και σκάνδαλα, και ως εκ τούτου να επηρεάσουν την κοινή γνώμη και τη συμπεριφορά των ανθρώπων.

Μια άλλη πιθανή απειλή είναι το περιεχόμενο για ενηλίκους, το οποίο ανέκαθεν δημιουργούσε τη μεγαλύτερη επισκεψιμότητα στον εικονικό χώρο. Δεν είναι περίεργο που η τεχνολογία deepfake χτύπησε το Διαδίκτυο τόσο γρήγορα. Σύμφωνα με μια έκθεση της ολλανδικής εταιρείας κυβερνοασφάλειας Deeptrace, το 96% των κατασκευασμένων βίντεο που δημιουργήθηκαν με τεχνολογία deepfake είναι περιεχόμενο σε τέτοια θέματα. Τις περισσότερες φορές, οι εικόνες των αστέρων του κινηματογράφου, των αθλητών, ακόμη και πολιτικών και εκπροσώπων της κυβέρνησης χρησιμοποιούνται για την παραγωγή τέτοιων υλικών.

Διαβάστε επίσης: Γιατί μια διαστημική αποστολή δεν μπορεί να πετάξει ανά πάσα στιγμή: Τι είναι ένα παράθυρο εκτόξευσης;

Πώς να φτιάξετε ένα deepfake;

Αν κάποιος μπορεί να κάνει βαθιά ψεύτικα βίντεο, μπορεί να γίνει και στο σπίτι; Σίγουρα ναι, αλλά η ποιότητά τους, φυσικά, δεν θα είναι τέλεια. Η δημιουργία τέτοιων βίντεο απαιτεί μεγάλους υπολογιστικούς πόρους και ισχυρές κάρτες βίντεο. Αυτά που έχουμε συνήθως στους οικιακούς υπολογιστές δεν είναι αρκετά και η ίδια η διαδικασία ανάπτυξης μπορεί να διαρκέσει για εβδομάδες. Η ποιότητα των ταινιών θα αφήσει επίσης πολύ επιθυμητό - θα υπάρχουν ορατά σφάλματα, οι κινήσεις του στόματος μπορεί να μην αντιστοιχούν στον ήχο, θα υπάρχουν ορατά σημεία όπου το "παλιό" περιεχόμενο επικαλύπτεται με το "νέο".

Ωστόσο, αν θέλουμε να «αγγίξουμε» ελαφρώς μια φωτογραφία ή να κάνουμε ένα σύντομο deepfake βίντεο, το πρόγραμμα για αυτό μπορεί να κατέβει απευθείας στο smartphone. Το πολύ εύχρηστο πρόγραμμα θα εξαλείψει μέσα σε λίγα λεπτά τα ελαττώματα της εμφάνισης, θα σας μετατρέψει στην επιλεγμένη διασημότητα ή θα επιτρέψει στον σκύλο σας να μιλήσει με ανθρώπινη φωνή.

Διαβάστε επίσης:

- Παρατηρώντας τον Κόκκινο Πλανήτη: Ιστορία των Αρειανών Ψευδαισθήσεων

- Η τηλεμεταφορά από επιστημονική άποψη και το μέλλον της

Πώς να αναγνωρίσετε ένα deepfake;

Τα επαγγελματικά deepfake βίντεο γίνονται όλο και πιο δύσκολο να εντοπιστούν. Στην αρχή, οι αλγόριθμοι είχαν προβλήματα με τη βασική συμπεριφορά (όπως το ανοιγοκλείσιμο των ματιών) και ήταν αμέσως σαφές ότι η ταινία ήταν ψεύτικη. Αυτό το σφάλμα έχει πλέον διορθωθεί. Οι ψεύτικοι χαρακτήρες αναβοσβήνουν, κινούνται φυσικά και μιλούν άπταιστα. Ωστόσο, μερικές φορές εξακολουθούν να έχουν προβλήματα με τη φυσική κίνηση των ματιών.

Λοιπόν, πώς να εντοπίσετε ένα deepfake; Να τι πρέπει να προσέξεις όταν παρακολουθείς το βίντεο:

- Ο ήχος συμβαδίζει με τις κινήσεις του στόματος; Μερικές φορές δεν ταιριάζουν αρκετά και το άτομο στο βίντεο κινεί τα χείλη του με καθυστέρηση σε σχέση με τον ήχο ή αρθρώνει λέξεις λανθασμένα.

- Κάθε είδους φαινόμενα που φαίνονται αφύσικα. Εδώ μιλάμε, μεταξύ άλλων, για τη θέση όλου του σώματος ή του κεφαλιού σε σχέση με τον κορμό, λανθασμένη ανάκλαση φωτός σε αντικείμενα, λανθασμένη ανάκλαση φωτός σε κοσμήματα κ.λπ. Ένα αφύσικο χρώμα δέρματος μπορεί επίσης να είναι σημάδι ότι η ταινία είναι ψεύτικη.

- Ποιότητα ήχου και βίντεο. Η διαφορά μεταξύ τους θα βοηθήσει στον εντοπισμό ενός deepfake. Συνήθως το soundtrack είναι πιο κακής ποιότητας.

- Ανωμαλίες εικόνας. Τις περισσότερες φορές, εμφανίζονται στη συμβολή του σώματος και του κεφαλιού. Όταν το κεφάλι μιας διασημότητας «κολληθεί» σε άλλο σώμα, μπορεί να εμφανιστεί μια θολούρα στην περιοχή του λαιμού. Μερικές φορές υπάρχουν παραλείψεις καρέ (διαλείπουσα διακοπή) και σφάλματα καρέ (διαφορετική γωνία φωτός, τύπος ή κατεύθυνση).

- Η αλλαγή του hashtag κατά τη διάρκεια του βίντεο μπορεί επίσης να σημαίνει ότι έχουμε ένα deepfake βίντεο.

Κατά την προβολή υλικού από την άποψη του deepfake, αξίζει επίσης να βασιστείτε στα δικά σας συναισθήματα. Μερικές φορές έχουμε την εντύπωση ότι κάτι δεν πάει καλά. Αυτό συμβαίνει, μεταξύ άλλων, όταν τα συναισθήματα του ατόμου που απεικονίζεται στην οθόνη δεν ταιριάζουν με αυτό που μας δείχνει η έκφραση του προσώπου ή ο τόνος της φωνής. Αυτό υποδηλώνει επίσης ότι το βίντεο μπορεί να είναι πλαστό.

Επίσης ενδιαφέρον:

- 10 πιο περίεργα πράγματα που μάθαμε για τις μαύρες τρύπες το 2021

- Terraforming Mars: Θα μπορούσε ο Κόκκινος Πλανήτης να μετατραπεί σε μια νέα Γη;

Πώς να προστατευτείτε από το deepfake;

Για να αποφύγετε μια βαθιά ψεύτικη απάτη, οι ειδικοί συμβουλεύουν να ακολουθήσετε αυτά τα βήματα:

- Δημιουργήστε μια μυστική λέξη ή σύνθημα με αγαπημένα πρόσωπα, όπως μέλη της οικογένειας ή συναδέλφους, που θα αποδείξουν την πραγματικότητα της κατάστασης με ένα βίντεο ή ηχογράφηση. Αυτό θα σας επιτρέψει να επαληθεύσετε γρήγορα την ανακρίβεια της κατάστασης και να αποφύγετε, για παράδειγμα, τον εκβιασμό χρημάτων.

- Συμφωνήστε με συγγενείς ή συναδέλφους σε μια λίστα πληροφοριών για τις οποίες δεν θα ρωτηθούν ποτέ μέσω μηνυμάτων, για παράδειγμα, σε κοινωνικά δίκτυα ή SMS. Είναι επιτακτική ανάγκη να ενημερωθούν όλα τα ενδιαφερόμενα μέρη για την πραγματική έκταση του κινδύνου.

- Υλοποίηση καναλιών ελέγχου ταυτότητας πολλαπλών παραγόντων για την επαλήθευση κάθε αιτήματος. Εάν η επικοινωνία ξεκινά με ένα μήνυμα κειμένου, τότε ο ασφαλέστερος τρόπος για να επιβεβαιώσετε τις πληροφορίες είναι να επικοινωνήσετε με τον αποστολέα του μηνύματος με τη μορφή συνομιλίας μέσω ενός προσυμφωνημένου και ασφαλούς καναλιού επικοινωνίας.

- Συνεχής βελτίωση των ικανοτήτων ασφάλειας, για παράδειγμα με τη μορφή εκπαίδευσης προσωπικού σε θέματα ασφάλειας και εγκλήματος στον κυβερνοχώρο. Ευαισθητοποίηση σχετικά με το τι είναι το deepfake και πώς να αντιμετωπιστεί αυτή η απειλή.

- Υποστήριξη και ανάπτυξη συστημάτων ασφαλείας σε περιβάλλοντα τεχνολογίας πληροφοριών και επικοινωνιών (ΤΠΕ).

Πού μπορείτε να συναντήσετε ένα deepfake;

Το ψεύτικο υλικό μπορεί να βρεθεί οπουδήποτε μπορεί να προσεγγίσει ένα μεγάλο κοινό, δηλαδή το πιθανό deepfake κοινό. Facebook, Instagram, το TikTok και άλλοι ιστότοποι μέσων κοινωνικής δικτύωσης είναι γεμάτοι με τέτοιου είδους πράγματα.

Δεν πρόκειται μόνο για εκπληκτικά βίντεο, αλλά και για «εξευγενισμένες» φωτογραφίες και ηχογραφήσεις. Μερικά από τα αυθεντικά προφίλ διασημοτήτων έχουν μερικές φορές γεμίσει εντελώς με βαθιά ψεύτικα πράγματα!

Αυτό δεν είναι το μόνο μέρος όπου μπορείτε να βρείτε ένα deepfake. Σε αυτήν την τεχνολογία βασίζεται επίσης μια εφαρμογή για smartphone, η οποία σας επιτρέπει να προσθέσετε μουστάκι και γένια ή άλλα ειδικά εφέ σε μια φωτογραφία (για παράδειγμα, γήρανση κατά αρκετές δεκαετίες). Μπορεί λοιπόν να αποδειχτεί ότι η τελευταία φωτογραφία που λάβατε από τους φίλους σας είναι λίγο «υποτραβηγμένη».

Επίσης ενδιαφέρον:

Οι Deepfake ταινίες δεν είναι μόνο πορνογραφικές

Η χρήση του deepfake μπορεί να είναι θετική και αρνητική. Οι ταινίες Deepfake μπορεί να είναι παιχνιδιάρικες ή διασκεδαστικές. Εδώ θα πρέπει να αναφέρουμε το βίντεο της βασίλισσας Ελισάβετ να χορεύει στο τραπέζι κατά τη διάρκεια του μηνύματος της Πρωτοχρονιάς. Αυτός είναι και ο σκοπός των περισσότερων από τις τροποποιήσεις φωτογραφιών που κάνουμε με την εφαρμογή deepfake στα smartphone μας. Θα πρέπει να είναι αστείο και διασκεδαστικό.

Τα Deepfake υλικά μπορούν επίσης να παίξουν εκπαιδευτικό ρόλο, για παράδειγμα, να «αναστήσουν» ήδη νεκρούς καλλιτέχνες, τραγουδιστές ή μουσικούς. Μερικά μουσεία, και συγκεκριμένα το Μουσείο Σαλβαδόρ Νταλί στη Φλόριντα, χρησιμοποιούν αυτήν την τεχνολογία, όπου οι επισκέπτες «παρουσιάζονται» με τα έργα τους από τον ίδιο τον καλλιτέχνη, με τον οποίο μπορείς να μιλήσεις, ακόμη και να τραβήξεις φωτογραφίες.

Η τεχνολογία Deepfake χρησιμοποιείται σε γεννήτριες φωνής - συσκευές σχεδιασμένες για άτομα που έχουν χάσει την ικανότητα ομιλίας. Χάρη σε αυτούς, τέτοιοι άνθρωποι μπορούν ακόμα να μας μιλήσουν με τη δική τους φωνή. Η φωνή του Val Kilmer, την οποία έχασε από καρκίνο του λάρυγγα, διαμορφώθηκε στο Top Gun: Maverick.

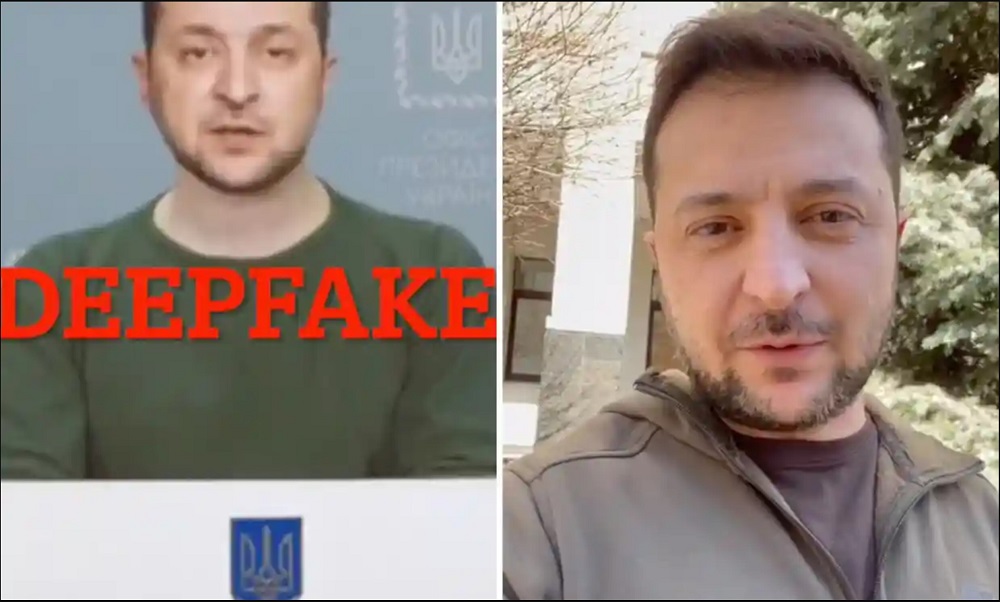

Δυστυχώς, έχουμε επίσης πολλά παραδείγματα αρνητικών χρήσεων του deepfaking. Η πολιτική είναι ένα παράδειγμα όπου αυτού του είδους οι ψευδείς πληροφορίες μπορεί να έχουν εκτεταμένες, παγκόσμιες συνέπειες, όπως δυσφήμιση δημοσίων προσώπων, επιρροή στο χρηματιστήριο, την οικονομία ή τα αποτελέσματα των εκλογών ή ακόμα και τη διεξαγωγή πολέμου σε έναν πόλεμο. Ένα καλά προετοιμασμένο αρχείο διευκολύνει τη χειραγώγηση της κοινής γνώμης. Η προοδευτική ανάπτυξη των τεχνολογιών θα καταστήσει ακόμη πιο δύσκολη τη διάκριση των πραγματικών υλικών από τα πλαστά. Άρα, αυτό είναι ένα βήμα προς την πτώση της κοινωνικής εμπιστοσύνης και του πληροφοριακού χάους.

Τα Deepfake βίντεο, όπως ήδη αναφέραμε, είναι ευρέως διαδεδομένα στη βιομηχανία του πορνό. Τις περισσότερες φορές, οι αλλαγές συνίστανται στην αντικατάσταση του προσώπου της ηθοποιού/ηθοποιού πορνό με το πρόσωπο διασημοτήτων ή σταρ του κινηματογράφου, φυσικά, χωρίς τη συγκατάθεσή τους.

Διαβάστε επίσης: Επανδρωμένες διαστημικές αποστολές: Γιατί η επιστροφή στη Γη εξακολουθεί να αποτελεί πρόβλημα;

Το Deepfake είναι μια πραγματική απειλή για όλους μας

Το Deepfake δεν είναι πρόβλημα μόνο για ηθοποιούς και πολιτικούς. Οποιοσδήποτε μπορεί να επηρεαστεί από ψεύτικο περιεχόμενο. Ένα στοιχείο εκβιασμού και εκβιασμού μπορεί να είναι ένα κατασκευασμένο βίντεο στο οποίο διαπράττουμε ένα έγκλημα ή μπαίνουμε σε μια διφορούμενη κατάσταση - είτε πληρώνετε είτε εμείς αποκαλύπτουμε. Εάν εργάζεστε σε επιχειρήσεις, πρέπει να καταλάβετε ότι υπάρχει κίνδυνος να χρησιμοποιήσετε το deepfake για να δυσφημίσετε την εταιρεία μεταξύ των αντισυμβαλλομένων της.

Η αύξηση της ποσότητας του υλικού χειραγώγησης μπορεί επίσης να επηρεάσει την κοινωνική εμπιστοσύνη και την εμπιστοσύνη στις παρεχόμενες πληροφορίες. Πώς μπορείς να πιστέψεις οτιδήποτε όταν μια ταινία που αποτελεί απόδειξη σε ένα δικαστήριο μπορεί να είναι ψευδής και οι ειδήσεις αναφέρουν ανύπαρκτα γεγονότα;

Η τεχνολογία που σας επιτρέπει να δημιουργήσετε μια κακόβουλη εικόνα, ηχογράφηση ή ταινία των οποίων οι χαρακτήρες μοιάζουν πολύ με άλλους ανθρώπους είναι ένα νέο επίπεδο απειλής από τους εγκληματίες του κυβερνοχώρου. Ειδικά δεδομένου του γεγονότος ότι στα κοινωνικά δίκτυα μπορούν να αντλήσουν σχεδόν απεριόριστους πόρους πηγαίο υλικό για τη δημιουργία deepfakes.

Το λογισμικό μηχανικής εκμάθησης μπορεί να αναζητήσει το Facebook abo Instagram, για παράδειγμα, και τραβήξτε ενδιαφέρουσες φωτογραφίες ή βίντεο πιθανών «ηθοποιών». Σε αυτή τη βάση, μπορεί να δημιουργηθεί μια πολύ καθαρή φωνή, εικόνα και βίντεο του ατόμου, αλλά με μια ειδικά δημιουργημένη ψεύτικη έκκληση που προσομοιώνει, για παράδειγμα, ότι βρίσκεται σε σοβαρό πρόβλημα - ως θύμα απαγωγής ή ατυχήματος. Στο επόμενο στάδιο, δημιουργείται ένα ψεύτικο αίτημα για βοήθεια, για παράδειγμα οικονομική, που απευθύνεται στους συγγενείς του «θύματος».

Διαβάστε επίσης: Διαστημικό τηλεσκόπιο James Webb: 10 στόχοι που πρέπει να παρατηρήσετε

Η καταπολέμηση του deepfake

Η ροή ψευδών πληροφοριών είναι τόσο μεγάλη που πολλά κοινωνικά δίκτυα αποφάσισαν να καταπολεμήσουν τα deepfakes. Facebook і Twitter προσπαθήστε να εντοπίσετε ψεύτικα βίντεο και να τα διαγράψετε αυτόματα. Μεγάλες εταιρείες (συμπεριλαμβανομένων Microsoft ή Amazon) επενδύουν σε λογισμικό που θα ανιχνεύει ψεύτικο περιεχόμενο. Οι επιστήμονες εργάζονται επίσης για μια λύση σε αυτό το πρόβλημα.

Ωστόσο, σε μια κατάσταση όπου μια εφαρμογή smartphone είναι αρκετή για να δημιουργήσει μια ψεύτικη ταινία, η καταπολέμηση ενός deepfake είναι σαν να παλεύεις ενάντια σε ανεμόμυλους. Επίσης, δεν υπάρχουν νομικοί κανόνες που να καθορίζουν τις συνέπειες της χειραγώγησης πληροφοριών ή της χρήσης της εικόνας κάποιου άλλου με αυτόν τον τρόπο.

Το Deepfake γίνεται όλο και πιο δημοφιλές και είναι όλο και πιο δύσκολο να το ξεχωρίσεις από την αλήθεια. Αυτό οφείλεται στη βελτίωση των τεχνολογιών που μπορούν να μιμηθούν καλύτερα τις ανθρώπινες κινήσεις και χειρονομίες. Τα Deepfakes μπορούν να χρησιμοποιηθούν για καλούς σκοπούς, όπως η δημιουργία εκπαιδευτικού υλικού ή η βοήθεια ατόμων που έχουν χάσει τη φωνή τους μετά από χειρουργική επέμβαση λάρυγγα, αλλά είναι επίσης ένα εργαλείο για χάκερ, εκβιαστές και τρολ του Διαδικτύου.

Έτσι, αν συναντήσετε ξανά ένα καταπληκτικό βίντεο στο Διαδίκτυο, ελέγξτε πρώτα αν μερικές φορές είναι τροποποιημένο ή ψεύτικο. Ίσως αυτό που κοιτάτε να μην ήταν ποτέ πραγματικότητα!

Διαβάστε επίσης:

- 100 χρόνια κβαντικής φυσικής: Από τις θεωρίες της δεκαετίας του 1920 στους υπολογιστές

- 5 μελλοντικές διαστημικές αποστολές που πρέπει να σκεφτείτε

Ωστόσο, μην ξεχνάτε ότι υπάρχει πόλεμος σε εξέλιξη στην Ουκρανία. Εάν θέλετε να βοηθήσετε την Ουκρανία να πολεμήσει τους Ρώσους κατακτητές, ο καλύτερος τρόπος για να το κάνετε είναι να κάνετε δωρεά στις Ένοπλες Δυνάμεις της Ουκρανίας μέσω Savelife ή μέσω της επίσημης σελίδας NBU.