El Parlamento Europeo ha aprobado el proyecto de ley, que se convertirá en la base de la futura ley sobre normas de regulación de la IA. Tratemos de entender qué es la Ley de IA de la UE .

En primer lugar, la Ley de IA de la UE debería convertirse en la primera ley del mundo que regule de manera integral los problemas relacionados con la IA. Hasta el momento, solo se ha aprobado el proyecto, no la ley en sí. Ahora será presentado a los parlamentos de 27 estados miembros de la UE para la adopción de la versión final. Es decir, la UE está tratando de convertirse en una especie de regulador de la IA, para establecer ciertos marcos y restricciones en el desarrollo e implementación de algoritmos de IA y aprendizaje automático.

La Unión Europea quiere regular la inteligencia artificial

La Unión Europea pretende acabar con el caos en el mercado del uso de algoritmos de IA y está asumiendo la regulación de nuevas variedades de inteligencia artificial. El Parlamento Europeo ha acelerado el trabajo sobre la propuesta de Ley de Inteligencia Artificial, que debería introducir reglas para la implementación de nuevos programas de IA, e incluso prohibir su uso en ciertas áreas de la vida.

Actualmente hay discusiones sobre la forma de dicha regulación en vista del desarrollo actual de la IA. En esencia, los eurodiputados quieren incluir en la ley la diferencia entre la inteligencia artificial de propósito general y los modelos fundamentales, y se espera que las leyes se apliquen de manera más estricta a estos últimos. Esta modificación de las disposiciones propuestas anteriormente se debe al rápido desarrollo de la IA en los últimos meses. Ambas formas de inteligencia artificial difieren entre sí en la escala de datos de entrenamiento, adaptabilidad y probabilidad de uso para fines no previstos.

Todos estos parámetros son más altos precisamente en los modelos fundamentales, especialmente en la IA generativa, que es la base de modelos como GPT-3 y GPT-4. Procesan una gran cantidad de datos, que se expanden constantemente en el proceso de trabajo. Por lo tanto, pueden aprender rápidamente nuevos datos que se pueden usar de una manera completamente diferente a la que pretendían los creadores.

Sobre la base de las nuevas directrices, se desarrollará una clasificación de grupos en tres etapas en función de las amenazas potenciales a las que puede conducir la IA. Los grados más altos de riesgo significarán limitar el uso de tecnologías de aprendizaje automático en sectores sensibles y, en algunos casos, incluso prohibirlos por completo.

Después de la introducción de la Ley de Inteligencia Artificial, el desarrollador de la tecnología deberá cumplir una serie de condiciones antes de lanzarla al mercado, como probarla en busca de amenazas a la democracia o la seguridad bajo la supervisión de expertos independientes, cumplir con los requisitos de transparencia, o revelar el poder de cómputo del modelo. Al mismo tiempo, los modelos fundamentales no pueden usarse para crear sistemas de puntuación social (como en China) o identificación biométrica.

¿Qué es la Ley de la UE sobre Inteligencia Artificial?

La Ley de IA de la UE es la ley de inteligencia artificial propuesta por la Unión Europea y es la primera ley de IA aprobada por un organismo regulador importante. La ley regula la aplicación de la IA según tres categorías de riesgos. En primer lugar, se prohibirán los programas y sistemas que crean riesgos sociales inaceptables, como la evaluación social del gobierno utilizada en China. En segundo lugar, existen programas de alto riesgo, como las herramientas de escaneo de currículums que clasifican a los solicitantes de empleo, que deben cumplir con ciertos requisitos legales. Por último, los programas que no están explícitamente prohibidos o catalogados como de alto riesgo y que en gran medida no están regulados.

La Unión Europea está trabajando en el AI Act, es decir, leyes y reglamentos para el uso de la inteligencia artificial, destinados a limitar el daño que puede causar a los humanos.

Es un enfoque basado en valores éticos comunes importantes para la Unión, que lo opone al enfoque chino -basado en el control estatal total y poca importancia a los derechos individuales- y al modelo estadounidense, que ignora los derechos. de los ciudadanos más vulnerables.

La Comisión Europea tiene como objetivo crear un entorno normativo europeo para los principios de la inteligencia artificial. El objetivo de la Ley de Inteligencia Artificial es regular el mercado tecnológico no por tipo de servicio o producto, sino por el nivel de riesgo que la IA puede causar.

¿Por qué necesitamos reglas sobre las IAs?

El reglamento de IA propuesto garantiza que los europeos puedan confiar en lo que la IA tiene para ofrecer. Si bien la mayoría de los sistemas de inteligencia artificial presentan poco o ningún riesgo y pueden contribuir a resolver muchos problemas sociales, ciertos sistemas de inteligencia artificial presentan amenazas que debemos considerar para evitar resultados no deseados.

Por ejemplo, a menudo es imposible averiguar por qué el sistema de inteligencia artificial tomó una determinada decisión, dio una predicción o tomó una acción adecuada. Por lo tanto, puede resultar difícil evaluar si una persona ha sido injustamente perjudicada, por ejemplo, en una decisión de contratación o una solicitud para un programa de asistencia social.

Si bien la legislación actual brinda cierta protección, es insuficiente para abordar los problemas específicos que pueden crear los sistemas de IA.

Se propusieron las siguientes reglas:

- Eliminar los riesgos creados específicamente por los programas de IA.

- Sugerir una lista de programas de alto riesgo.

- Establecer requisitos claros para los sistemas de IA para aplicaciones de alto riesgo

- Definir obligaciones específicas para los usuarios de IA y los proveedores de software de alto riesgo.

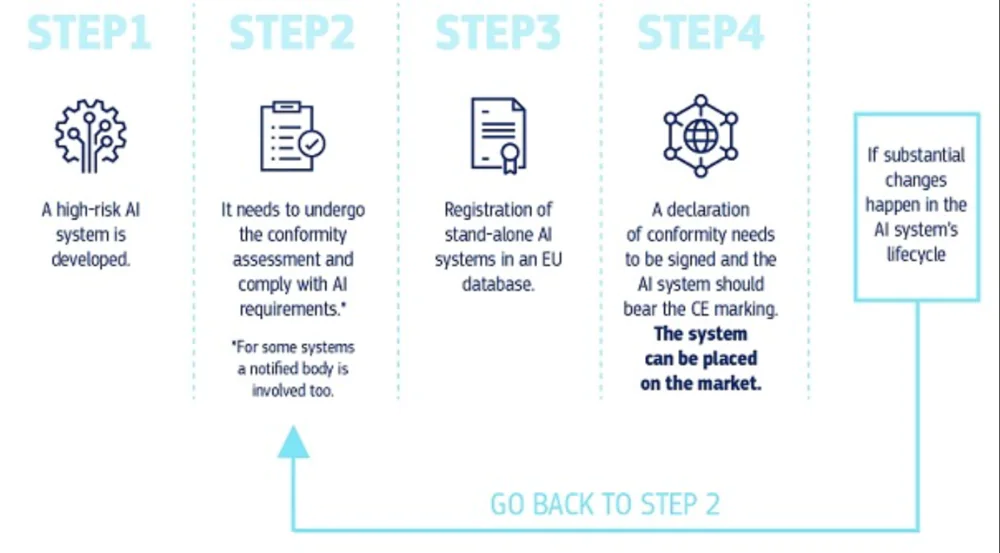

- Ofrecer una evaluación de la conformidad antes de que un sistema de IA se ponga en funcionamiento o se comercialice.

- Sugerir áreas de aplicación después de que dicho sistema de IA se comercialice.

- Proponer una estructura de gobernanza a nivel europeo y nacional.

Cuatro niveles de riesgo en IA

Los abogados de la Unión Europea definieron un marco legal que define 4 niveles de riesgo en IA:

- Riesgo inaceptable

- Alto riesgo

- Riesgo limitado

- Mínimo o ningún riesgo

Analicemos cada uno de ellos con más detalle.

Riesgo inaceptable

Como su nombre lo indica, este grado de riesgo es inaceptable cuando se desarrollan y utilizan algoritmos de IA. Es decir, se prohibirán todos los sistemas de inteligencia artificial que se consideren una clara amenaza para la seguridad, los medios de vida y los derechos de las personas, desde las evaluaciones sociales de los gobiernos hasta los juguetes asistidos por voz que fomentan comportamientos peligrosos.

Alto riesgo

Los sistemas de IA utilizados en las siguientes áreas se clasificaron como de alto riesgo:

- Infraestructura crítica (por ejemplo, transporte), que puede poner en peligro la vida y la salud de los ciudadanos.

- Formación educativa o profesional que puede determinar el acceso a la educación y la trayectoria profesional de una persona (por ejemplo, el cálculo de los resultados de los exámenes).

- Componentes de seguridad del producto o la aplicación de inteligencia artificial, por ejemplo, en cirugía.

- Empleo, gestión de la fuerza laboral y acceso al trabajo por cuenta propia (por ejemplo, software de selección de CV para procedimientos de contratación)

- Servicios públicos y privados básicos (por ejemplo, evaluación crediticia, que priva a los ciudadanos de la oportunidad de obtener un préstamo)

- Acciones de aplicación de la ley que pueden limitar los derechos fundamentales de las personas en el ámbito de la justicia (por ejemplo, evaluación de la credibilidad de la evidencia).

- Gestión de la migración, asilo y control de fronteras (por ejemplo, verificación de la autenticidad de los documentos de viaje).

- La administración de justicia y los procesos democráticos (por ejemplo, la aplicación de la ley a un conjunto particular de hechos).

Se ha determinado que los sistemas de IA de alto riesgo cumplirán requisitos estrictos antes de que puedan comercializarse:

- Sistemas adecuados de evaluación y mitigación de riesgos.

- Conjuntos de datos de alta calidad que alimentan el sistema para minimizar los riesgos y los resultados discriminatorios.

- Registro de actividad para garantizar el seguimiento de los resultados

- Documentación detallada que contenga toda la información necesaria sobre el sistema y su propósito, de modo que las autoridades puedan evaluar su cumplimiento con los requisitos.

- Información clara y adecuada para el usuario.

- Medidas apropiadas de supervisión humana para minimizar los riesgos.

- Alto nivel de fiabilidad, seguridad y precisión.

Ahora sobre uno de los aspectos más importantes que asustó a casi todos. Todos los sistemas de identificación biométrica remota se consideran de alto riesgo y están sujetos a requisitos estrictos. El uso de la identificación biométrica remota en lugares públicos con fines policiales está prohibido en principio.

Se prevén excepciones estrictamente definidas y reglamentadas, por ejemplo, cuando sea necesario buscar a un niño desaparecido, prevenir amenazas terroristas específicas e inmediatas, o detectar, localizar, identificar o enjuiciar a un delincuente o sospechoso de un delito grave.

Tal uso requiere la autorización de una autoridad judicial u otra autoridad independiente y tiene las limitaciones apropiadas en términos de tiempo, cobertura geográfica y bases de datos buscadas.

Riesgo limitado

El riesgo limitado se refiere a los sistemas de IA con ciertas obligaciones de transparencia. Cuando se utilizan sistemas de inteligencia artificial como los chatbots, los usuarios deben saber que están interactuando con una máquina para poder tomar una decisión informada sobre si continuar o retirarse.

Es decir, significa que nadie va a prohibir ChatGPT, pero los desarrolladores deben revelar los detalles de su trabajo y planes futuros. Los usuarios deben comprender los riesgos que les esperan si confían en la confiabilidad de la información recibida de los chatbots.

Mínimo o ningún riesgo

La Comisión Europea permite el uso gratuito de la IA con un riesgo mínimo. Esto incluye aplicaciones como videojuegos habilitados para inteligencia artificial o filtros de correo no deseado. La gran mayoría de los sistemas de IA actualmente en uso en la UE entran en esta categoría.

Cuando un sistema de IA ingresa al mercado, las autoridades son responsables de la vigilancia del mercado, los usuarios brindan supervisión y monitoreo humanos, y los proveedores tienen un sistema de monitoreo posterior a la comercialización. Los proveedores y usuarios también comunicarán incidencias graves y averías.

¿Por qué debería importarte?

Los programas de inteligencia artificial influyen en la información que ve en línea, predicen qué contenido le interesa, recopilan y analizan datos para hacer cumplir las leyes o personalizar anuncios, y se utilizan para diagnosticar y tratar cosas como el cáncer. En otras palabras, la IA afecta muchas áreas de tu vida.

Al igual que el Reglamento General de Protección de Datos (GDPR) de la UE de 2018, la Ley de IA de la UE podría convertirse en el estándar global que determine si la IA tendrá un impacto positivo en lugar de negativo en su vida, dondequiera que esté. La regulación de la inteligencia artificial en la UE ya está causando cierta resonancia internacional. A fines de septiembre de 2021, el Congreso brasileño también aprobó un proyecto de ley que crea un marco legal para el uso de inteligencia artificial. Todavía tiene que ser aprobado por el Senado del país.

Legislación orientada al futuro

Dado que la inteligencia artificial es una tecnología en rápido desarrollo, la propuesta adopta un enfoque prospectivo que permite que las normas se adapten a los cambios tecnológicos. Las aplicaciones de IA deben seguir siendo fiables incluso después de haber sido comercializadas. Esto requiere una gestión continua de la calidad y los riesgos por parte de los proveedores.

Tal ley debería obligar a los fabricantes y proveedores de algoritmos de IA a ser más responsables de sus desarrollos. Para ser más social, no solo pensando en el crecimiento de los ingresos y los experimentos descontrolados.

La EU AI Act es la primera regulación de la inteligencia artificial

La ley de la UE sobre inteligencia artificial se convertirá en la primera ley del mundo que regula de manera integral las cuestiones relacionadas con la inteligencia artificial.

Esta es una solución revolucionaria para regular la inteligencia artificial en función de su potencial para causar daño. Se prohibirá su uso, por ejemplo, en sistemas de puntuación social, identificación biométrica en tiempo real o manipulación subconsciente. También se identificó un grupo de programas de alto riesgo, por ejemplo, en diagnósticos médicos o en el sistema judicial. En el grupo de sistemas con riesgo limitado, sólo se deben establecer obligaciones de transparencia.

Hay varias lagunas y excepciones en el proyecto de ley propuesto. Estas deficiencias limitan la capacidad de la Ley para garantizar que la IA siga siendo una fuerza para el bien en su vida. Actualmente, por ejemplo, el reconocimiento facial por parte de la policía está prohibido a menos que la imagen se capture con retraso, o si la tecnología se utiliza para encontrar niños desaparecidos.

Además, la ley es inflexible. Si una aplicación de IA peligrosa se usa en un campo inesperado dentro de dos años, la ley no proporciona un mecanismo para etiquetarla como de «alto riesgo».

La IA actuar es ante todo transparencia, la capacidad de explicar los hechos y la capacidad de ser responsable de ellos, es decir, la capacidad de determinar quién o qué es responsable de tal o cual hecho. La Ley de AI también se convertirá en la base legal para la creación de una nueva Autoridad de AI para ayudar a los Estados miembros con asuntos técnicos.

Los gigantes tecnológicos pagarán un alto precio por violar la legislación de la UE sobre inteligencia artificial

La directiva propuesta solo se aplicaría a las reclamaciones por daños resultantes del uso de IA, o cuando el sistema de IA no pudo producir un resultado debido a la culpa de una persona, como un proveedor o usuario. Sin embargo, la Directiva no se aplica a las reclamaciones de responsabilidad civil si el daño fue causado por una evaluación humana y acciones u omisiones posteriores, mientras que el sistema de IA solo proporcionó información o asesoramiento que fue tenido en cuenta por el actor relevante. En el último caso, los daños resultantes de acciones o inacciones humanas pueden rastrearse porque la salida del sistema de IA no se interpone entre las acciones o inacciones humanas y el daño.

La violación de la prohibición dará lugar a sanciones financieras para los proveedores de ciertas tecnologías. Pueden alcanzar los 30 millones de euros o el 6 por ciento de los ingresos globales anuales de la empresa.

Por supuesto, la adopción de tales decisiones dependerá de las decisiones de los estados miembros de la Unión Europea, pero ya podemos decir que este es un paso verdaderamente histórico. La tecnología de inteligencia artificial tiene un enorme potencial que se puede utilizar positivamente para el desarrollo de la economía. Al mismo tiempo, hay muchos riesgos. Por tanto, la legislación trata de limitarlos, pero no de prohibirlos.

Además de adoptar una nueva legislación de IA, la UE también tiene la intención de trabajar con los EE. UU. en un código de conducta voluntario sobre la tecnología, que se espera que esté listo pronto y podría ofrecerse a otros países que siguen principios similares.

La Ley de Inteligencia Artificial también debería constituir la base para la creación de la Oficina de Inteligencia Artificial. Su objetivo es apoyar a los Estados miembros y sus autoridades en la implementación de la nueva regulación a través de la experiencia técnica, así como facilitar la coordinación de soluciones en caso de problemas que afectarán a más de un país.

Aquí te dejamos una lista de noticias que de seguro vas a querer leer: