La música generada por inteligencia artificial (IA) ya es una realidad. Las herramientas de IA ahora pueden crear música con nada más que un mensaje de texto y los resultados superan todas las expectativas.

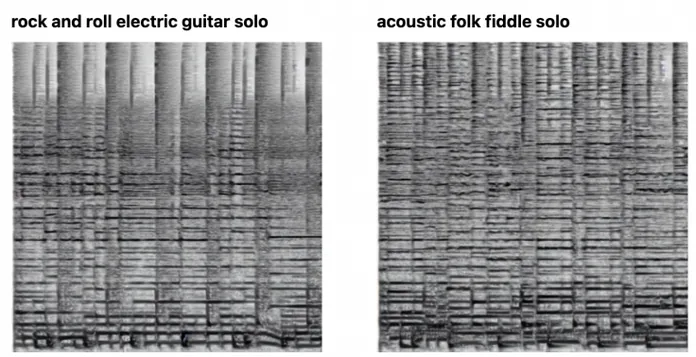

Sin embargo, esto no significa que las herramientas de IA puedan crear música directamente. En cambio, la música pasa por generadores de imágenes de IA que crean espectrogramas de la música. A continuación, puede convertir estos espectrogramas en clips de audio. ¿Significa esto que la música generada por IA reemplazará a la música creada por humanos en el futuro?

La IA basada en imágenes enseña algoritmos informáticos a reconocer imágenes de lugares y objetos. Después de eso, se utilizan algoritmos para reproducir imágenes similares pero únicas. DALL-E y Stable Diffusion son buenos ejemplos. Por ahora, puedes hacer que estos programas rendericen lo que quieras. ¡Todo a través del texto!

Entonces, la herramienta de IA que puede crear espectrogramas se llama Riffusion. Este es el último proyecto de IA y, en esencia, es un generador de imágenes a partir de texto basado en difusión estable (Stable Diffusion). Pero, ¿cómo llegó a ser capaz de generar música?

Detrás de Riffusion están el especialista en robótica Heik Martiros y el desarrollador de software Seth Forsgren. Querían probar si los programas modernos de IA podrían funcionar en el campo del audio. Así comenzó el viaje de creación musical de Riffusion. Forsgren habla sobre la tecnología de esta manera: “Hake y yo tocamos juntos en una pequeña banda, y comenzamos el proyecto solo porque amamos la música. Después de ver los sorprendentes resultados de Stable Diffusion para la generación de imágenes, nos preguntamos cómo sería usar un enfoque de difusión para crear música.

Para averiguarlo, un equipo de dos entrenó a Stable Diffusion de código abierto en imágenes de espectrograma. Se combinaron con el texto. Después de eso, el programa pudo crear espectrogramas de música basados en ciertas pistas.

Al principio, no sabían si la arquitectura del modelo Stable Diffusion podría crear una imagen de espectrograma con suficiente precisión para convertirla en audio, pero resultó que podía hacer eso y más. Martiros y Forsgren publicaron sus resultados en el sitio web oficial de Riffusion. Al principio era un proyecto de hobby. Pero ahora los visitantes pueden agregar sus propios consejos de texto. Esto obligará a Riffusion a generar un espectrograma. Más tarde, los visitantes pueden usarlo como un clip de audio y reproducirlo en el sitio.

Los resultados en esta etapa pueden no ser de muy alta calidad. Pero definitivamente no es tan malo como podrías pensar.

Riffusion también puede intentar reproducir canciones que incluyan rap al estilo de Eminem y K-Pop. Pero la función de generar letras no es tan buena. En lugar de texto, escuchará un melodioso galimatías humano. Pero lo más interesante es que este galimatías aún coincide con el tono de la canción.

Esta tecnología aún no está lista para reemplazar la música hecha por humanos. Pero el proyecto nos mostró que los algoritmos de procesamiento de imágenes de IA todavía tienen un gran potencial. Pronto podrá convertirse en asistente de autores musicales. Tal vez para obtener algo de inspiración para escribir una canción.

Aquí te dejamos una lista de noticias que de seguro vas a querer leer:

- Reseña de Gotham Knights: ¿Realmente necesitamos a Batman?.

- China regulará la creación de deepfakes a nivel legislativo.