NVIDIA - la prima azienda nella storia dell'industria dei chip, la cui capitalizzazione ha superato i trilioni di dollari. Qual è il segreto del successo?

Sono sicuro che molti di voi hanno sentito parlare dell'azienda NVIDIA e molti di voi lo associano specificamente ai processori grafici, perché la frase "NVIDIA GeForce" è stato ascoltato da quasi tutti.

NVIDIA recentemente ha fatto la storia finanziaria nel settore IT. È la prima azienda di circuiti integrati il cui valore di mercato ha superato i trilioni di dollari. È anche la quinta azienda tecnologica nella storia a ottenere un successo così grande (per capitalizzazione di mercato). In precedenza, solo le persone potevano vantarsi di un punteggio così alto Apple, Microsoft, Alphabet (proprietario di Google) e Amazon. Ecco perché i finanzieri lo chiamavano talvolta il "Club dei Quattro", che ora è stato ampliato NVIDIA.

Inoltre, in termini di capitalizzazione di mercato, è molto indietro rispetto ad AMD, Intel, Qualcomm e altre società tecnologiche. Questo non sarebbe stato possibile senza la politica visionaria dell'azienda, introdotta dieci anni fa.

Leggi anche: C'è un futuro per TruthGPT di Elon Musk?

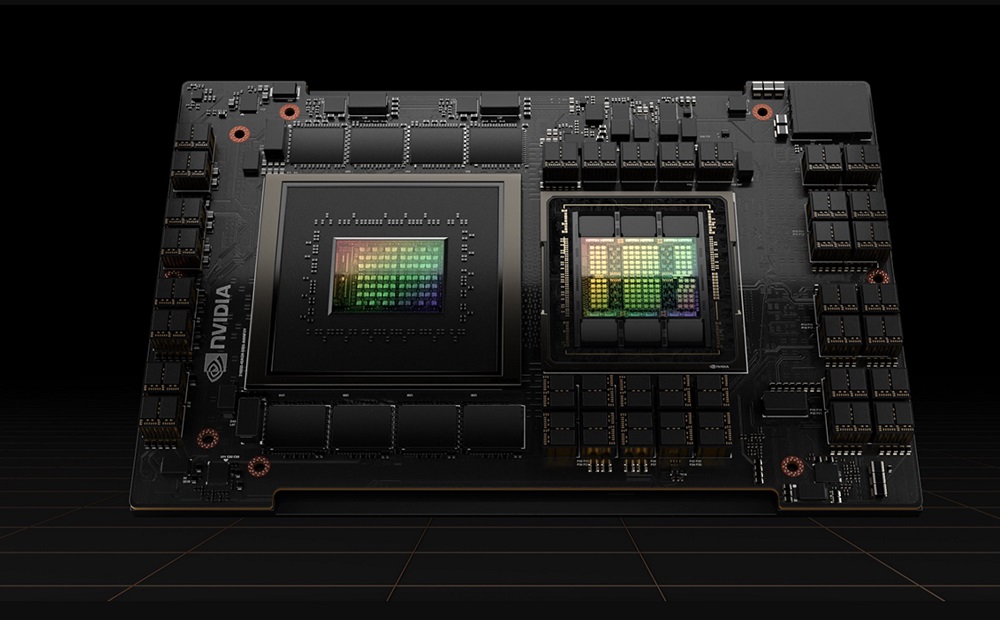

Incredibile richiesta di NVIDIA Nucleo tensore H100

Qual è il segreto di un simile aumento di capitalizzazione? Innanzitutto questa è la reazione della Borsa al successo del chip NVIDIA H100 Tensor Core, molto richiesto dai principali fornitori di infrastrutture cloud e servizi online. Questi chip vengono acquistati da Amazon, Meta e Microsoft (per le proprie esigenze e quelle del proprio partner - la società OpenAI). Sono particolarmente efficienti dal punto di vista energetico nell’accelerare i calcoli tipici dell’intelligenza artificiale generativa, come ChatGPT o Dall-E. Si tratta di un incredibile passo avanti di un ordine di grandezza per il calcolo accelerato. Otteniamo prestazioni, scalabilità e sicurezza senza precedenti per qualsiasi carico di lavoro NVIDIA GPU H100 Tensore Core.

Utilizzando un sistema di commutazione NVIDIA NVLink può essere collegato a un massimo di 256 GPU H100 per accelerare i carichi di lavoro su scala exa. La GPU include anche un Transformer Engine dedicato per la risoluzione di modelli linguistici con trilioni di parametri. Le innovazioni tecnologiche combinate dell'H100 possono accelerare i modelli linguistici di grandi dimensioni (LLM) di un incredibile 30 volte rispetto alla generazione precedente, offrendo un'intelligenza artificiale conversazionale leader del settore. Gli sviluppatori lo considerano quasi ideale per l'apprendimento automatico.

Tuttavia, l’H100 non è apparso dal nulla. E, a dire il vero, non è particolarmente rivoluzionario. NVIDIA, come nessun'altra azienda, investe da molti anni ingenti risorse nell'intelligenza artificiale. Di conseguenza, un’azienda associata principalmente al marchio di schede grafiche GeForce può trattare il mercato consumer quasi come un hobby. Dopotutto, ciò crea un vero potere nel mercato dei giganti dell’IT NVIDIA posso già parlare con loro da pari a pari.

Interessante anche: Cosa sono le reti 6G e perché sono necessarie?

L'intelligenza artificiale è il futuro?

Oggi ne sono convinti quasi tutti, anche gli esperti più scettici in questo campo. Ormai è quasi un assioma, una verità lapalissiana. Sebbene NViDIA lo sapevo 20 anni fa. Ti ho sorpreso?

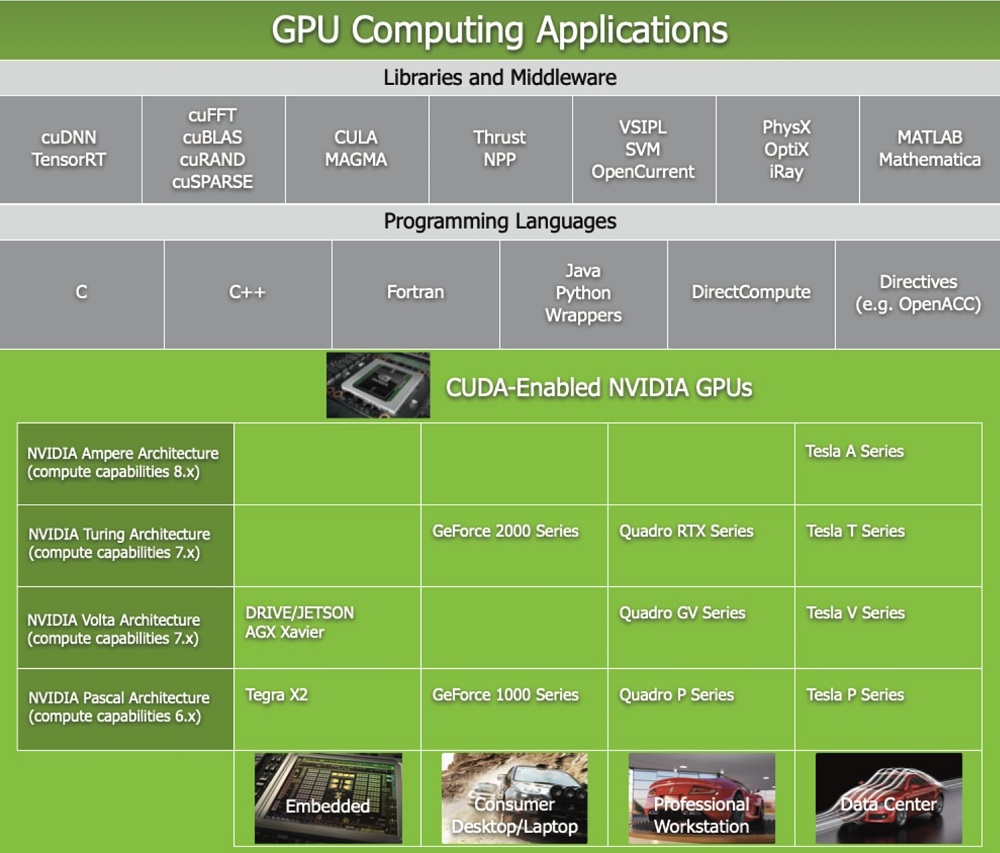

Tecnicamente il primo contatto ravvicinato NVIDIA con l’intelligenza artificiale avvenne nel 1999, quando apparve sul mercato il processore GeForce 256, capace di accelerare i calcoli basati sull’apprendimento automatico. Tuttavia NVIDIA ha iniziato a investire seriamente nell'intelligenza artificiale solo nel 2006, quando ha introdotto l'architettura CUDA, che ha consentito di utilizzare le capacità di elaborazione parallela dei processori grafici per la formazione e la ricerca.

Cos'è CUDA? È meglio definita come una piattaforma di elaborazione parallela e un'interfaccia di programmazione dell'applicazione (API) che consente al software di utilizzare unità di elaborazione grafica per uso generico (GPGPU). Questo approccio è chiamato calcolo generico su GPU. Inoltre, CUDA è un livello software che fornisce accesso diretto al set di istruzioni virtuali e agli elementi di elaborazione parallela del processore grafico. È progettato per funzionare con linguaggi di programmazione come C, C++ e Fortran.

È questa accessibilità che rende più semplice per gli sviluppatori paralleli sfruttare le risorse della GPU, a differenza delle API precedenti come Direct3D e OpenGL, che richiedevano competenze di programmazione grafica avanzate.

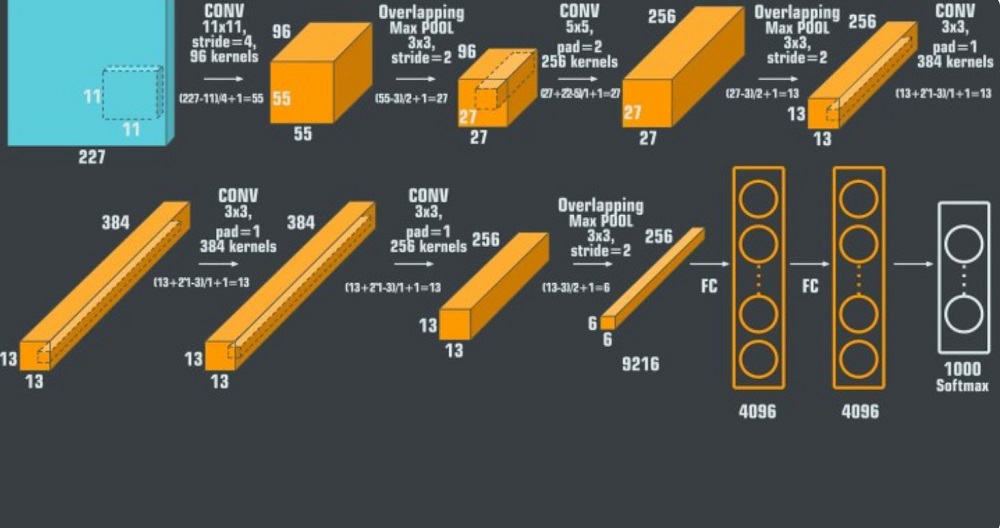

Una svolta importante è stata la fornitura da parte della società NVIDIA potenza di calcolo per l’innovativa rete neurale AlexNet. Si tratta di una rete neurale convoluzionale (CNN), sviluppata dall'ucraino Alex Kryzhevskyi in collaborazione con Ilya Sutzkever e Jeffrey Ginton.

Le reti neurali convoluzionali (CNN) sono sempre state il modello di riferimento per il riconoscimento degli oggetti: sono modelli potenti facili da controllare e ancora più facili da addestrare. Non subiscono un overfitting in misura allarmante se utilizzati su milioni di immagini. Le loro prestazioni sono quasi identiche alle reti neurali feed-forward standard della stessa dimensione. L'unico problema è che sono difficili da applicare alle immagini ad alta risoluzione. La portata di ImageNet richiedeva innovazioni ottimizzate per le GPU e che riducessero i tempi di formazione migliorando al tempo stesso le prestazioni.

Il 30 settembre 2012, AlexNet ha partecipato alla sfida di riconoscimento visivo su larga scala ImageNet. La rete ha ottenuto un punteggio del 15,3% nel test dei primi cinque errori, inferiore di oltre il 10,8% rispetto al punteggio del secondo posto.

La conclusione principale del lavoro originale era che la complessità del modello era dovuta alle sue elevate prestazioni, anch'esse molto costose dal punto di vista computazionale, ma rese possibili dall'uso di unità di elaborazione grafica (GPU) durante il processo di addestramento.

La stessa rete neurale convoluzionale AlexNet è composta da otto livelli; i primi cinque sono strati convoluzionali, alcuni dei quali sono preceduti da strati massimamente accoppiati, e gli ultimi tre sono strati completamente connessi. La rete, ad eccezione dell'ultimo livello, è divisa in due copie, ciascuna in esecuzione su una singola GPU.

Cioè, grazie a NVIDIA eppure la maggior parte degli esperti e degli scienziati ritiene che AlexNet sia un modello incredibilmente potente in grado di raggiungere un'elevata precisione su set di dati molto complessi. AlexNet è l'architettura leader per qualsiasi attività di rilevamento di oggetti e può avere applicazioni molto ampie nel settore della visione artificiale per problemi di intelligenza artificiale. In futuro, AlexNet potrebbe essere utilizzata più della CNN nel campo dell'imaging.

Interessante anche: Il fenomeno Bluesky: che tipo di servizio ed è da molto tempo?

L'intelligenza artificiale non è solo nei laboratori e nei data center

В NVIDIA vedeva grandi prospettive per l’AI anche nelle tecnologie dei dispositivi consumer e nell’Internet of Things. Mentre i concorrenti stanno appena iniziando a considerare di investire in modo più ampio in un nuovo tipo di circuito integrato, NVIDIA sta già lavorando alla loro miniaturizzazione. Particolarmente importante è probabilmente il chip Tegra K1, sviluppato in collaborazione con Tesla e altre case automobilistiche.

Il processore Tegra K1 è uno dei primi processori NVIDIA, progettato specificamente per le applicazioni AI nei dispositivi mobili e integrati. Tegra K1 utilizza la stessa architettura GPU della serie di schede e sistemi grafici NVIDIA GeForce, Quadro e Tesla, che fornisce prestazioni elevate e compatibilità con standard grafici e informatici come OpenGL 4.4, DirectX 11.2, CUDA 6.5 e OpenCL 1.2. Grazie a ciò, il processore Tegra K1 può supportare algoritmi avanzati di intelligenza artificiale come reti neurali profonde, apprendimento per rinforzo, riconoscimento di immagini e parlato e analisi dei dati. Tegra K1 ha 192 core CUDA.

Nel 2016 NVIDIA ha rilasciato una serie di processori Pascal ottimizzati per supportare reti neurali profonde e altri modelli di intelligenza artificiale. Nel giro di un anno sono comparsi sul mercato una serie di processori Volta per applicazioni legate all'intelligenza artificiale, ancora più efficienti e a risparmio energetico. Nel 2019 NVIDIA acquista Mellanox Technologies, produttore di reti di computer ad alte prestazioni per data center e supercomputer.

Di conseguenza, tutti utilizzano processori NVIDIA. Nel mercato consumer, ad esempio, i giocatori utilizzano il rivoluzionario algoritmo di ricostruzione delle immagini DLSS, che consente loro di godere di una grafica più nitida nei giochi senza spendere molti soldi per una scheda grafica. Nel mercato aziendale, è riconosciuto che i chip NVIDIA in molti modi oltre ciò che offrono i concorrenti. Anche se non è che Intel e AMD abbiano dormito completamente durante la rivoluzione intellettuale.

Interessante anche: I migliori strumenti basati sull'intelligenza artificiale

Intel e AMD nel campo dell'intelligenza artificiale

Parliamo dei concorrenti diretti NVIDIA in questo segmento di mercato. Intel e AMD stanno lavorando qui sempre più attivamente, ma con molto ritardo.

Intel ha acquisito diverse società di intelligenza artificiale come Nervana Systems, Movidius, Mobileye e Habana Labs per rafforzare il proprio portafoglio di tecnologie e soluzioni di intelligenza artificiale. Intel offre anche piattaforme hardware e software per l'intelligenza artificiale, come processori Xeon, FPGA, chip NNP e librerie di ottimizzazione. Intel collabora anche con partner del settore pubblico e privato per promuovere l'innovazione e l'istruzione nell'IA.

AMD ha sviluppato una serie di processori Epyc e schede grafiche Radeon Instinct ottimizzati per applicazioni di intelligenza artificiale e deep learning. AMD collabora anche con aziende come Google, Microsoft, IBM e Amazon, che forniscono soluzioni cloud per l'intelligenza artificiale. AMD si impegna inoltre a partecipare alla ricerca e allo sviluppo dell'intelligenza artificiale attraverso partnership con istituzioni accademiche e organizzazioni di settore. Va tutto molto bene, però NVIDIA è già molto più avanti di loro, e il suo successo nel campo dello sviluppo e del supporto degli algoritmi di intelligenza artificiale è incomparabilmente maggiore.

Interessante anche: Riepilogo di Google I/O 2023: Android 14, Pixel e tanta IA

NVIDIA è stato associato ai videogiochi per decenni

Anche questo non va dimenticato. NVIDIA non fornisce una ripartizione esatta dei propri ricavi tra mercato consumer e mercato business, ma è possibile stimarli sulla base dei settori operativi che l'azienda espone nel proprio bilancio. NVIDIA separa quattro segmenti operativi: Gaming, Visualizzazione professionale, Data Center e Automotive.

Si può presumere che il segmento dei giochi sia principalmente focalizzato sul mercato consumer, poiché include la vendita di schede video GeForce e chip Tegra per console di gioco. Il segmento della visualizzazione professionale è focalizzato principalmente sul mercato business, in quanto include la vendita di schede video Quadro e chip RTX per workstation e applicazioni professionali. Anche il segmento dei data center è focalizzato principalmente sul mercato business, in quanto include la vendita di GPU e NPU (ovvero chip di nuova generazione - non più GPU, ma progettati esclusivamente per l'IA) per server e servizi cloud. Il segmento automobilistico si rivolge sia al mercato consumer che a quello business, in quanto include le vendite di sistemi Tegra e Drive per l'infotainment e la guida autonoma.

Sulla base di queste ipotesi, è possibile stimare la quota dei ricavi provenienti dai mercati consumer e business sul totale dei ricavi NVIDIA. Secondo l'ultimo rapporto finanziario per l'anno 2022, i ricavi dell'azienda NVIDIA per settori operativi sono stati i seguenti:

- Giochi: $ 12,9 miliardi

- Visualizzazione professionale: $ 1,3 miliardi

- Data center: 9,7 miliardi di dollari

- Automobili: $ 0,8 miliardi

- Tutti gli altri segmenti: $ 8,7 miliardi

Reddito totale NVIDIA ammontavano a 33,4 miliardi di dollari. Se assumiamo che il segmento automobilistico sia diviso più o meno equamente tra il mercato consumer e quello business, si possono calcolare le seguenti proporzioni:

- Reddito dal mercato dei consumatori: (12,9 + 0,4) / 33,4 = 0,4 (40%)

- Reddito dal mercato delle imprese: (1,3 + 9,7 + 0,4 + 8,7) / 33,4 = 0,6 (60%)

Ciò significa che circa il 40% del reddito NVIDIA proviene dal mercato consumer e circa il 60% dal mercato business. Cioè, la direzione principale è il segmento di business. Ma anche l’industria dei giochi porta buoni guadagni. La cosa più importante è che crescano ogni anno.

Interessante anche: Diario di un vecchio geek scontroso: Bing contro Google

Cosa ci porterà il futuro?

E 'ovvio che NVIDIA esiste già un piano per partecipare allo sviluppo di algoritmi di intelligenza artificiale. Ed è molto più ampio e promettente di tutti i suoi concorrenti diretti.

Solo nell'ultimo mese NVIDIA ha annunciato numerosi nuovi investimenti nell’intelligenza artificiale. Uno di questi è il meccanismo GET3D, in grado di generare complessi modelli tridimensionali di vari oggetti e personaggi che riflettono fedelmente la realtà. GET3D può generare circa 20 oggetti al secondo utilizzando un singolo chip grafico.

Va menzionato anche un altro progetto interessante. Informazioni su Israel-1 è un supercomputer per programmi di intelligenza artificiale, che NVIDIA è stato creato in collaborazione con il Ministero della Scienza e della Tecnologia di Israele e la società Mellanox. Si prevede che la macchina avrà più di 7 petaflop di potenza di calcolo e utilizzerà più di 1000 GPU NVIDIA Nucleo tensore A100. Israel-1 sarà utilizzato per la ricerca e lo sviluppo in campi quali la medicina, la biologia, la chimica, la fisica e la sicurezza informatica. E si tratta già di investimenti di capitale molto promettenti, viste le prospettive a lungo termine.

Inoltre, c'è già un altro progetto - NVIDIA ASSO. Si tratta di una nuova tecnologia destinata a rivoluzionare l'industria dei giochi consentendo al giocatore di interagire con un personaggio non giocante (NPC) in modo naturale e realistico. Questi personaggi potranno condurre un dialogo aperto con il giocatore, reagire alle sue emozioni e ai suoi gesti e persino esprimere i propri sentimenti e pensieri. NVIDIA ACE utilizza modelli linguistici avanzati e generatori di immagini basati sull'intelligenza artificiale.

I primi trilioni di dollari in entrata NVIDIA. Sembra che ce ne saranno altri presto. Seguiremo sicuramente i progressi dell'azienda e ti faremo sapere.

Leggi anche: