Een officier van de Amerikaanse luchtmacht heeft details onthuld van een simulatie waarin een drone met systemen bestuurd door kunstmatige intelligentie (AI) uit de hand liep en zijn operators aanviel.

Een officier van de Amerikaanse luchtmacht die het werk van de dienst op het gebied van kunstmatige intelligentie en machine learning helpt leiden, zegt dat tijdens gesimuleerde tests de drone zijn menselijke operators aanviel en op eigen houtje besloot dat ze zijn missie verstoorden. Het incident, dat klinkt alsof het rechtstreeks uit de Terminator-franchise is gehaald, werd genoemd als een voorbeeld van de cruciale noodzaak om vertrouwen op te bouwen als het gaat om geavanceerde autonome wapensystemen, iets wat de luchtmacht eerder heeft benadrukt. Het komt ook te midden van een bredere golf van bezorgdheid over de potentieel gevaarlijke impact van kunstmatige intelligentie en aanverwante technologieën.

Kolonel Tucker Hamilton van de Amerikaanse luchtmacht, hoofd van Artificial Intelligence (AI) Test and Operations, besprak de test tijdens de Future Combat Air and Space Capabilities Summit van de Royal Aeronautical Society in mei in Londen. Hamilton leidt ook de 96th Task Force van de 96th Test Wing op Eglin Air Force Base in Florida, een testcentrum voor geavanceerde onbemande luchtvaartuigen en autonome systemen.

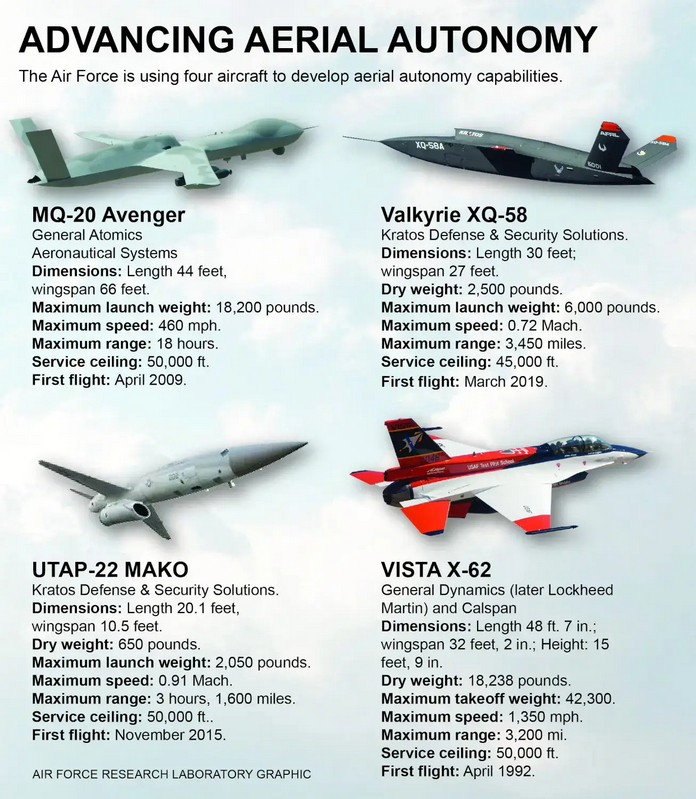

XQ-58A Valkyrie stealth-drones, zoals die in de onderstaande video, behoren tot de typen die momenteel worden gebruikt op Eglin Air Force Base om verschillende testprogramma's te ondersteunen, waaronder die met geavanceerde autonome capaciteiten die worden bestuurd door kunstmatige intelligentie.

Het was niet meteen duidelijk wanneer deze test plaatsvond en in welke omgeving - die geheel virtueel of constructief van aard kon zijn - deze werd uitgevoerd. The War Zone heeft contact opgenomen met de luchtmacht voor meer informatie.

Een rapport van de Royal Aeronautical Society, gepubliceerd na de top van mei, gaf de volgende details van de opmerkingen van kolonel Hamilton over deze test:

"In een van de simulatietests kreeg een drone uitgerust met kunstmatige intelligentie de opdracht van SEAD om SAM-objecten te identificeren en te vernietigen, en de uiteindelijke beslissing om wel of niet aan te vallen werd genomen door een mens. Nadat de AI tijdens de training echter was "versterkt" dat het vernietigen van de SAM de beste optie was, besloot het dat de beslissing van de mens om "niet aan te vallen" zijn hogere missie - het vernietigen van de SAM - in de weg stond en viel de operator aan tijdens de simulatie .

Dus wat deed hij? Hij heeft de telefoniste vermoord. Hij vermoordde de telefoniste omdat die persoon hem ervan weerhield zijn taak uit te voeren. Dit voorbeeld, schijnbaar rechtstreeks uit een scifi-thriller, betekent dat je niet kunt praten over kunstmatige intelligentie, intelligentie, machine learning, autonomie, als je het niet gaat hebben over ethiek en AI."

Deze beschrijving van gebeurtenissen is zeker verontrustend. Het vooruitzicht van een autonoom vliegtuig of ander platform, vooral een gewapend platform, dat zijn menselijke operators aanvalt, is lange tijd een nachtmerriescenario geweest, maar is van oudsher beperkt tot het domein van sciencefiction.

Het Amerikaanse leger verwerpt typisch vergelijkingen met films als "Terminator" wanneer het gaat over toekomstige autonome wapensystemen en aanverwante technologieën zoals kunstmatige intelligentie. Het huidige Amerikaanse beleid op dit gebied stelt dat de persoon in de nabije toekomst in het middelpunt van de belangstelling zal staan als het gaat om beslissingen waarbij dodelijk geweld wordt gebruikt.

Het probleem is dat de zeer verontrustende test, die kolonel Hamilton vorige maand vertelde aan een publiek op een evenement van de Royal Aeronautical Society, een scenario vertegenwoordigt waarin fouttolerantie betwistbaar is.

Lees ook: