NVIDIA - det første selskapet i brikkeindustriens historie, hvis kapitalisering oversteg en billion dollar. Hva er hemmeligheten bak suksess?

Jeg er sikker på at mange av dere har hørt om selskapet NVIDIA og de fleste av dere forbinder det spesifikt med grafikkprosessorer, fordi uttrykket "NVIDIA GeForce" har blitt hørt av nesten alle.

NVIDIA nylig laget finansiell historie i IT-bransjen. Det er det første integrerte kretsselskapet hvis markedsverdi har oversteget en billion dollar. Det er også det femte teknologirelaterte selskapet i historien som oppnår en så stor suksess (etter markedsverdi). Tidligere var det bare folk som kunne skryte av en så høy vurdering Apple, Microsoft, Alphabet (eier av Google) og Amazon. Det er derfor finansfolk noen ganger kalte det "Club of Four", som nå er utvidet NVIDIA.

I tillegg, når det gjelder markedsverdi, er det langt bak AMD, Intel, Qualcomm og andre teknologiselskaper. Dette hadde ikke vært mulig uten den visjonære politikken til selskapet, introdusert for et tiår siden.

Les også: Er det en fremtid for Elon Musks TruthGPT?

Utrolig etterspørsel etter NVIDIA H100 Tensor Core

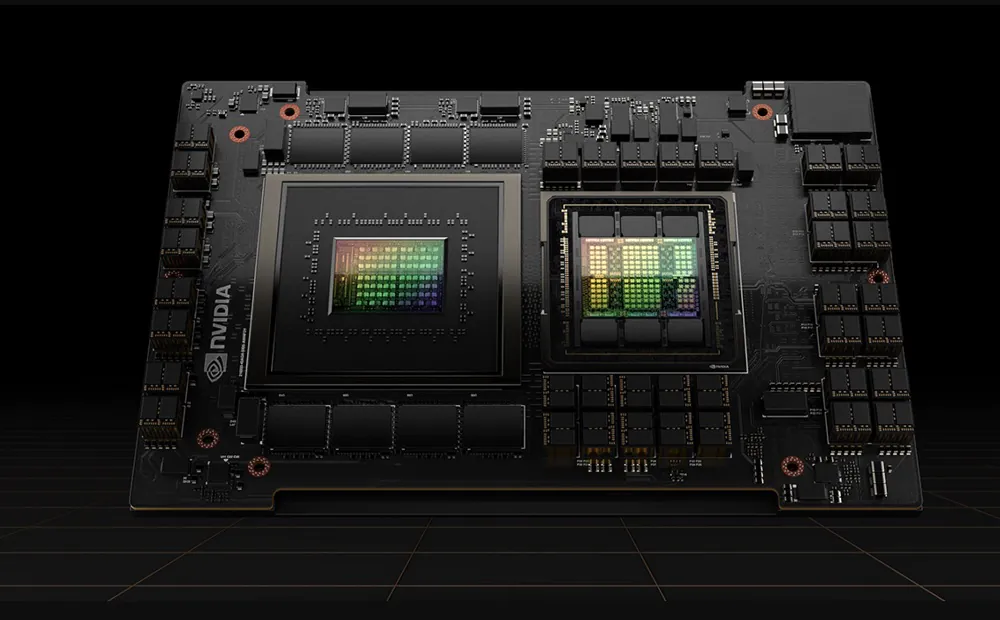

Hva er hemmeligheten bak en slik økning i kapitalisering? Først av alt er dette børsens reaksjon på suksessen til brikken NVIDIA H100 Tensor Core, som er etterspurt blant ledende leverandører av skyinfrastruktur og nettjenester. Disse sjetongene kjøpes av Amazon, Meta og Microsoft (for sine egne behov og behovene til sin partner - selskapet OpenAI). De er spesielt energieffektive i akselererende beregninger som er typiske for generativ kunstig intelligens, som ChatGPT eller Dall-E. Dette er et utrolig sprang av en størrelsesorden for akselerert databehandling. Vi får enestående ytelse, skalerbarhet og sikkerhet for enhver arbeidsbelastning med NVIDIA H100 Tensor Core GPU.

Bruke et byttesystem NVIDIA NVLink kan kobles til opptil 256 H100 GPUer for å akselerere arbeidsbelastninger i exa-skala. GPUen inkluderer også en dedikert Transformer Engine for å løse språkmodeller med billioner av parametere. H100s kombinerte teknologiinnovasjoner kan akselerere store språkmodeller (LLM) med utrolige 30 ganger sammenlignet med forrige generasjon, og levere bransjeledende konversasjons-AI. Utviklerne anser det som nesten ideelt for maskinlæring.

H100 dukket imidlertid ikke opp fra ingensteds. Og, for å si sant, det er ikke spesielt revolusjonerende. NVIDIA, som ingen andre selskaper, har investert enorme ressurser i kunstig intelligens i mange år. Som et resultat kan et selskap som primært er knyttet til GeForce-grafikkkortmerket behandle forbrukermarkedet nesten som en hobby. Dette bygger tross alt reell kraft i markedet til IT-giganter NVIDIA kan allerede snakke med dem som likeverdige.

Også interessant: Hva er 6G-nettverk og hvorfor trengs de?

Er kunstig intelligens fremtiden?

I dag er nesten alle overbevist om dette, selv skeptiske eksperter på dette feltet. Nå er det nesten et aksiom, en truisme. Selv om NViDIA visste om det for 20 år siden. Overrasket jeg deg?

Teknisk sett den første nærkontakten NVIDIA med kunstig intelligens skjedde i 1999, da GeForce 256-prosessoren dukket opp på markedet, i stand til å akselerere maskinlæringsberegninger. derimot NVIDIA begynte seriøst å investere i kunstig intelligens først i 2006, da den introduserte CUDA-arkitekturen, som tillot å bruke parallellbehandlingsmulighetene til grafikkprosessorer for opplæring og forskning.

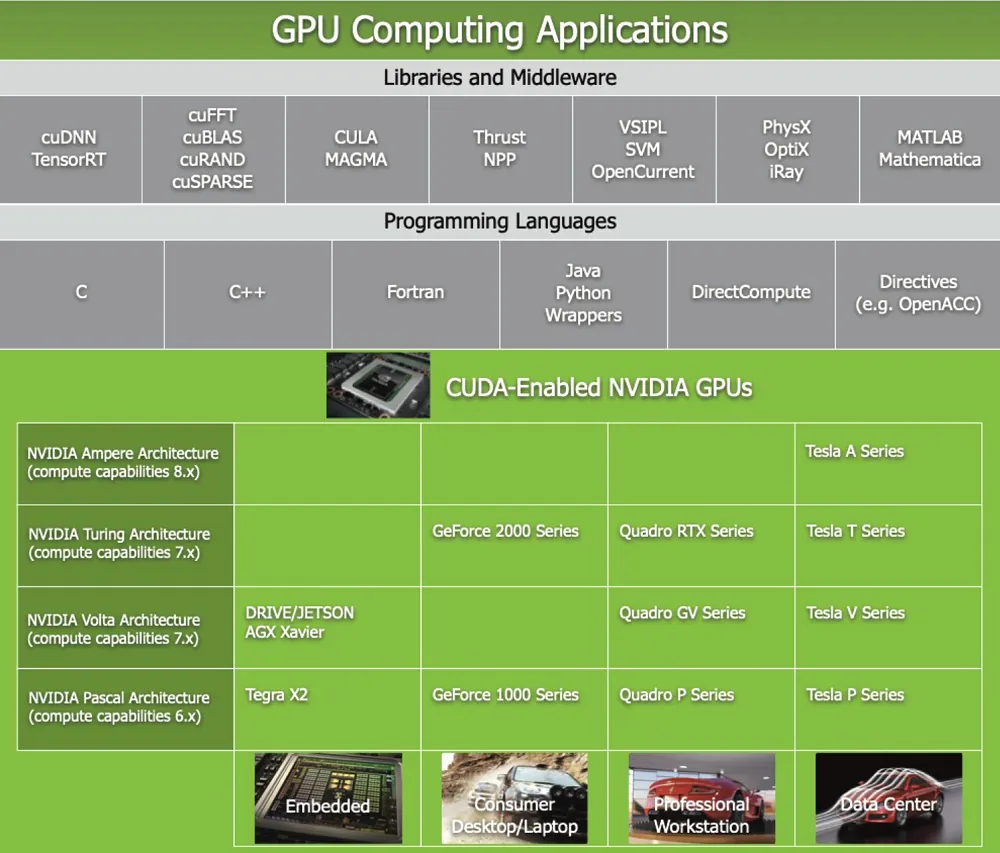

Hva er CUDA? Det er best definert som en parallell databehandlingsplattform og applikasjonsprogrammeringsgrensesnitt (API) som lar programvare bruke grafiske prosesseringsenheter for generelle formål (GPGPU). Denne tilnærmingen kalles generell databehandling på GPUer. I tillegg er CUDA et programvarelag som gir direkte tilgang til det virtuelle instruksjonssettet og parallelle databehandlingselementer til grafikkprosessoren. Den er designet for å fungere med programmeringsspråk som C, C++ og Fortran.

Det er denne tilgjengeligheten som gjør det enklere for parallellutviklere å dra nytte av GPU-ressurser, i motsetning til tidligere APIer som Direct3D og OpenGL, som krevde avanserte ferdigheter i grafikkprogrammering.

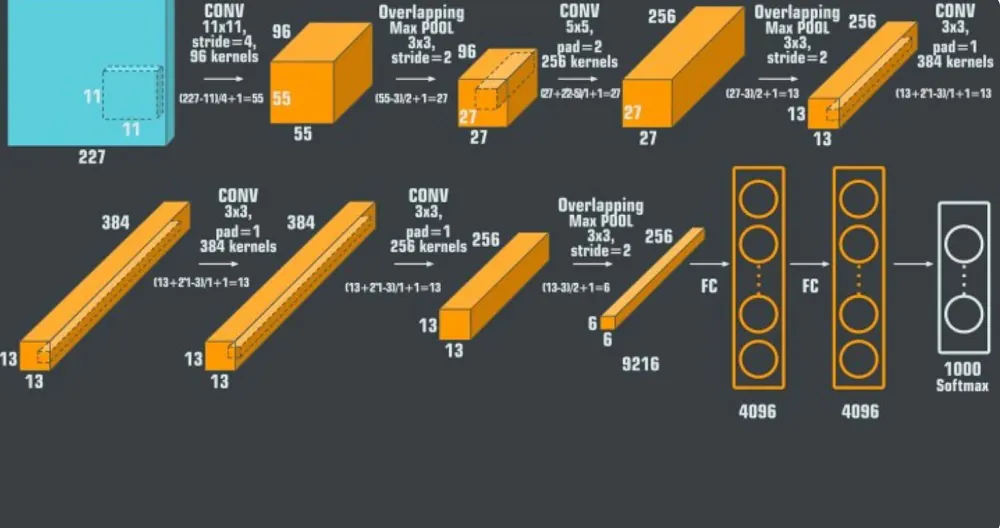

Et viktig gjennombrudd var tilbudet fra selskapet NVIDIA datakraft for det banebrytende nevrale nettverket AlexNet. Det er et konvolusjonelt nevralt nettverk (CNN), utviklet av ukrainske Alex Kryzhevskyi i samarbeid med Ilya Sutzkever og Jeffrey Ginton.

Convolutional Neural Networks (CNN) har alltid vært den beste modellen for gjenkjenning av objekter – de er kraftige modeller som er enkle å kontrollere og enda enklere å trene. De opplever ikke overtilpasning i noen alarmerende grad når de brukes på millioner av bilder. Ytelsen deres er nesten identisk med standard feed-forward nevrale nettverk av samme størrelse. Det eneste problemet er at de er vanskelige å bruke på høyoppløselige bilder. Skalaen til ImageNet krevde innovasjoner som ville være optimalisert for GPUer og redusere treningstiden samtidig som ytelsen ble forbedret.

30. september 2012 deltok AlexNet i ImageNet Large Scale Visual Recognition Challenge. Nettverket oppnådde en poengsum på 15,3 % i de fem beste feiltestene, over 10,8 % lavere enn andreplassen.

Hovedkonklusjonen fra det originale arbeidet var at kompleksiteten til modellen skyldtes dens høye ytelse, som også var svært beregningsmessig kostbar, men muliggjort ved bruk av grafikkbehandlingsenheter (GPUer) under opplæringsprosessen.

Det AlexNet konvolusjonelle nevrale nettverket i seg selv består av åtte lag; de første fem er konvolusjonslag, hvorav noen er innledet av maksimalt koblede lag, og de tre siste er fullstendig sammenkoblede lag. Nettverket, bortsett fra det siste laget, er delt i to kopier, som hver kjører på en enkelt GPU.

Det vil si takket være det NVIDIA og fortsatt tror de fleste eksperter og forskere at AlexNet er en utrolig kraftig modell som er i stand til å oppnå høy nøyaktighet på svært komplekse datasett. AlexNet er den ledende arkitekturen for enhver objektdeteksjonsoppgave og kan ha svært brede applikasjoner i datasynssektoren for kunstig intelligensproblemer. I fremtiden kan AlexNet bli brukt mer enn CNN innen bildebehandling.

Også interessant: Bluesky-fenomenet: hva slags tjeneste og er det lenge?

Kunstig intelligens finnes ikke bare i laboratorier og datasentre

В NVIDIA så store muligheter for AI også i teknologiene til forbrukerenheter og tingenes internett. Mens konkurrenter akkurat begynner å vurdere å investere bredere i en ny type integrert krets, NVIDIA jobber allerede med miniatyriseringen deres. Tegra K1-brikken, utviklet i samarbeid med Tesla og andre bilselskaper, er nok spesielt viktig.

Tegra K1-prosessoren er en av de første prosessorene NVIDIA, designet spesielt for AI-applikasjoner i mobile og innebygde enheter. Tegra K1 bruker samme GPU-arkitektur som serien med grafikkort og systemer NVIDIA GeForce, Quadro og Tesla, som gir høy ytelse og kompatibilitet med grafikk- og datastandarder som OpenGL 4.4, DirectX 11.2, CUDA 6.5 og OpenCL 1.2. Takket være dette kan Tegra K1-prosessoren støtte avanserte kunstig intelligensalgoritmer som dype nevrale nettverk, forsterkende læring, bilde- og talegjenkjenning og dataanalyse. Tegra K1 har 192 CUDA-kjerner.

I 2016 NVIDIA lanserte en serie Pascal-prosessorer optimalisert for å støtte dype nevrale nettverk og andre kunstig intelligens-modeller. I løpet av et år dukket det opp en serie Volta-prosessorer for applikasjoner knyttet til kunstig intelligens på markedet, som er enda mer effektive og energibesparende. I 2019 NVIDIA kjøper Mellanox Technologies, en produsent av høyytelses datanettverk for datasentre og superdatamaskiner.

Som et resultat bruker de alle prosessorer NVIDIA. På forbrukermarkedet, for eksempel, bruker spillere den revolusjonerende DLSS-bilderekonstruksjonsalgoritmen, som lar dem nyte skarpere grafikk i spill uten å bruke mye penger på et grafikkort. I bedriftsmarkedet er det anerkjent at chips NVIDIA på mange måter utover det konkurrentene tilbyr. Selv om det ikke er slik at Intel og AMD sov fullstendig gjennom den intellektuelle revolusjonen.

Også interessant: De beste verktøyene basert på kunstig intelligens

Intel og AMD innen kunstig intelligens

La oss snakke om direkte konkurrenter NVIDIA i dette markedssegmentet. Intel og AMD jobber her mer og mer aktivt, men med lang forsinkelse.

Intel har kjøpt opp flere AI-selskaper som Nervana Systems, Movidius, Mobileye og Habana Labs for å styrke sin portefølje av AI-teknologier og -løsninger. Intel tilbyr også maskinvare- og programvareplattformer for kunstig intelligens, som Xeon-prosessorer, FPGA-er, NNP-brikker og optimaliseringsbiblioteker. Intel samarbeider også med partnere i offentlig og privat sektor for å fremme AI-innovasjon og utdanning.

AMD har utviklet en serie Epyc-prosessorer og Radeon Instinct-grafikkort som er optimalisert for AI- og dyplæringsapplikasjoner. AMD jobber også med selskaper som Google, Microsoft, IBM og Amazon, som leverer skyløsninger for AI. AMD streber også etter å delta i AI-forskning og utvikling gjennom partnerskap med akademiske institusjoner og bransjeorganisasjoner. Men alt er veldig bra NVIDIA allerede langt foran dem, og suksessen innen utvikling og støtte for AI-algoritmer er uforlignelig større.

Også interessant: Sammendrag av Google I/O 2023: Android 14, Pixel og masse AI

NVIDIA har vært assosiert med videospill i flere tiår

Dette skal heller ikke glemmes. NVIDIA gir ikke en nøyaktig fordeling av inntektene mellom forbruker- og bedriftsmarkedet, men de kan estimeres basert på driftssegmentene som selskapet oppgir i regnskapet. NVIDIA skiller fire driftssegmenter: spill, profesjonell visualisering, datasentre og bil.

Det kan antas at spillsegmentet hovedsakelig er fokusert på forbrukermarkedet, siden det inkluderer salg av GeForce-skjermkort og Tegra-brikker for spillkonsoller. Segmentet for profesjonell visualisering er hovedsakelig fokusert på bedriftsmarkedet, da det inkluderer salg av Quadro-skjermkort og RTX-brikker for arbeidsstasjoner og profesjonelle applikasjoner. Datasentersegmentet er også hovedsakelig fokusert på bedriftsmarkedet, da det inkluderer salg av GPUer og NPUer (det vil si neste generasjons brikker - ikke lenger GPUer, men designet eksklusivt for AI) for servere og skytjenester. Bilsegmentet retter seg mot både forbruker- og bedriftsmarkedet, da det inkluderer salg av Tegra- og Drive-systemer for infotainment og autonom kjøring.

Basert på disse forutsetningene er det mulig å estimere andelen av inntektene fra forbruker- og bedriftsmarkedene i totale inntekter NVIDIA. I følge den siste økonomiske rapporten for år 2022 er selskapets inntekter NVIDIA etter driftssegmenter var som følger:

- Spill: 12,9 milliarder dollar

- Profesjonell visualisering: 1,3 milliarder dollar

- Datasentre: 9,7 milliarder dollar

- Biler: 0,8 milliarder dollar

- Alle andre segmenter: 8,7 milliarder dollar

Totale inntekter NVIDIA utgjorde 33,4 milliarder dollar. Hvis vi antar at bilsegmentet er delt omtrent likt mellom forbruker- og bedriftsmarkedet, kan følgende proporsjoner beregnes:

- Inntekt fra forbrukermarkedet: (12,9 + 0,4) / 33,4 = 0,4 (40 %)

- Inntekt fra bedriftsmarkedet: (1,3 + 9,7 + 0,4 + 8,7) / 33,4 = 0,6 (60 %)

Dette betyr at ca 40% av inntekten NVIDIA kommer fra forbrukermarkedet, og ca 60 % fra bedriftsmarkedet. Det vil si at hovedretningen er forretningssegmentet. Men spillindustrien gir også ganske gode inntekter. Det viktigste er at de vokser hvert år.

Også interessant: Diary of a Grumpy Old Geek: Bing vs Google

Hva vil fremtiden bringe oss?

Det er åpenbart at NVIDIA det er allerede en plan om å delta i utviklingen av kunstig intelligens-algoritmer. Og den er mye bredere og mer lovende enn noen av sine direkte konkurrenter.

Bare den siste måneden NVIDIA annonsert en rekke nye investeringer i kunstig intelligens. En av dem er GET3D-mekanismen, som er i stand til å generere komplekse tredimensjonale modeller av ulike objekter og karakterer som trofast reflekterer virkeligheten. GET3D kan generere rundt 20 objekter per sekund ved hjelp av en enkelt grafikkbrikke.

Et annet interessant prosjekt bør også nevnes. Om Israel-1 er en superdatamaskin for kunstig intelligens-programmer, som NVIDIA er opprettet i samarbeid med departementet for vitenskap og teknologi i Israel og selskapet Mellanox. Maskinen forventes å ha mer enn 7 petaflops med datakraft og bruke mer enn 1000 GPUer NVIDIA A100 Tensor Core. Israel-1 skal brukes til forskning og utvikling innen felt som medisin, biologi, kjemi, fysikk og cybersikkerhet. Og dette er allerede svært lovende kapitalinvesteringer, gitt de langsiktige utsiktene.

Dessuten er det allerede et annet prosjekt - NVIDIA ESS. Det er en ny teknologi som skal revolusjonere spillindustrien ved å la spilleren samhandle med en ikke-spillerkarakter (NPC) på en naturlig og realistisk måte. Disse karakterene vil være i stand til å føre en åpen dialog med spilleren, reagere på hans følelser og gester, og til og med uttrykke sine egne følelser og tanker. NVIDIA ACE bruker avanserte språkmodeller og AI-baserte bildegeneratorer.

Den første billionen dollar inn NVIDIA. Det ser ut til at det kommer flere snart. Vi vil være sikker på å følge selskapets fremgang og gi deg beskjed.

Les også: