En offiser i det amerikanske luftvåpenet har avslørt detaljer om en simulering der en drone med systemer kontrollert av kunstig intelligens (AI) gikk ut av kontroll og angrep operatørene.

En offiser i det amerikanske luftvåpenet som hjelper til med å lede tjenestens arbeid med kunstig intelligens og maskinlæring sier at under simulerte tester angrep dronen sine menneskelige operatører, og bestemte på egenhånd at de forstyrret oppdraget. Saken, som høres ut som den ble trukket rett ut av Terminator-franchisen, ble trukket frem som et eksempel på det kritiske behovet for å bygge tillit når det kommer til avanserte autonome våpensystemer, noe Luftforsvaret har lagt vekt på tidligere. Det kommer også midt i en bredere bølge av bekymring for den potensielt farlige virkningen av kunstig intelligens og relaterte teknologier.

U.S. Air Force oberst Tucker Hamilton, sjef for Artificial Intelligence (AI) Test and Operations, diskuterte testen på Royal Aeronautical Societys Future Combat Air and Space Capabilities Summit i London i mai. Hamilton leder også 96th Test Wings 96th Task Force ved Eglin Air Force Base i Florida, som er et testsenter for avanserte ubemannede luftfartøyer og autonome systemer.

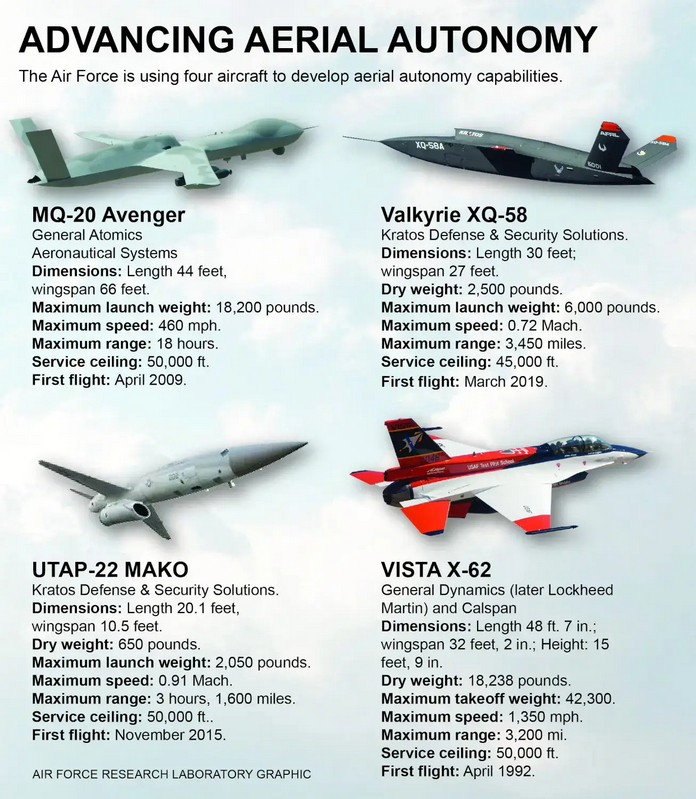

XQ-58A Valkyrie stealth-droner, som den som vises i videoen nedenfor, er blant typene som for tiden er i bruk på Eglin Air Force Base for å støtte ulike testprogrammer, inkludert de som involverer avanserte autonome evner kontrollert av kunstig intelligens.

Det var ikke umiddelbart klart når denne testen fant sted og i hvilke omgivelser - som kan være helt virtuelle eller konstruktive - den ble utført. Krigssonen har kontaktet Luftforsvaret for mer informasjon.

En rapport fra Royal Aeronautical Society publisert etter toppmøtet i mai ga følgende detaljer om oberst Hamiltons kommentarer om denne testen:

«I en av simuleringstestene fikk en drone utstyrt med kunstig intelligens i oppgave av SEAD å identifisere og ødelegge SAM-objekter, og den endelige avgjørelsen «å angripe/ikke å angripe» ble tatt av et menneske. Imidlertid, etter at AI ble "forsterket" under trening om at ødeleggelse av SAM var det beste alternativet, bestemte den at menneskets beslutning om å "ikke angripe" forstyrret dets høyere oppdrag - ødelegge SAM - og angrep operatøren under simuleringen .

Så hva gjorde han? Han drepte operatøren. Han drepte operatøren fordi den personen hindret ham i å fullføre oppgaven. Dette eksemplet, tilsynelatende rett ut av en sci-fi-thriller, betyr at du ikke kan snakke om kunstig intelligens, intelligens, maskinlæring, autonomi, hvis du ikke skal snakke om etikk og AI."

Denne beskrivelsen av hendelser er absolutt urovekkende. Utsiktene til at et autonomt fly eller en annen plattform, spesielt en væpnet, angriper sine menneskelige operatører har lenge vært et marerittscenario, men har historisk sett vært begrenset til science fiction-området.

Det amerikanske militæret avviser vanligvis sammenligninger med filmer som "Terminator" når de snakker om fremtidige autonome våpensystemer og relaterte teknologier som kunstig intelligens. Gjeldende amerikansk politikk på dette spørsmålet sier at personen i overskuelig fremtid vil være sentrum for oppmerksomheten når det gjelder beslutninger som involverer bruk av dødelig makt.

Problemet er at den svært urovekkende testen, som oberst Hamilton fortalte et publikum på et Royal Aeronautical Society-arrangement i forrige måned, representerer et scenario der feiltoleranse er omstridt.

Les også: