2014 год был весёлым. Особенно в плане видеокарт. Например, зрители ИТ-сообщества, закидываясь попкорном и заливая его Mountain Dew, жадно глазели на противостояние Radeon R9 295X2 и NVIDIA GTX Titan Z. На тот момент это были наиболее мощные, жрущие и производительные геймерские видеокарты. Сегодня, благодаря магазину Kiev-IT, я заимел себе Titan Z в исполнении EVGA. И сейчас о ней расскажу.

Также выражаю благодарность магазину MotoStuff за предоставленный для съёмки стабилизатор Zhiyun Smooth 4.

НЕ ХОЧЕШЬ ЧИТАТЬ – СМОТРИ ВИДЕО!

Тогдашний рынок видеокарт, мне кажется, пришёлся на пик борьбы SLI и Crossfire. Обе стороны, и красная, и зеленая, решили давить количеством помимо качества, стараясь при этом не смотреть на счетчик электроэнергии… И на температурные показатели, да.

Radeon R9 295X2У NVIDIA 7 ноября 2013 года вышел очередной флагман – GTX 780 Ti. Но потом Эш бросил Пикачу в чан с вирусом ВРЭ, из-за чего видеочип из 780 Ti, именуемый GK110, чуть потерял пару сотен мегагерц частоты ядра и целый 1 ГГц частоты памяти.

Количество видеопамяти, впрочем, возросло в два раза, до шести гигабайт, а производительность по 64-битной плавающей запятой возросло в… семь, с 210 GFLOPS до 1500. Получившуюся видеокарту назвали GTX Titan, и она вышла в том же 2013 году, 17 ноября, и стоила всего на 200 баксов дороже, $1000 против $800.

Этого Эшу показалось мало, он достал свой бумстик и приказал Пикачу лезть в чан снова. От этого GTX Titan почернел и превратился в Titan Black. Тот же видеочип, столько же видеопамяти, но частоты даже выше, чем у 780 Ti, а гигафлопс ещё 200 сверху. Цена скакнула соответствующе, ещё на $200, но вышел видеоадаптер уже в 2014 году, 1 марта.

Но для Эш и этого было недостаточно. Она приказала своему дворецкому Бобу держать Пикачу под ВРЭ до тех пор, пока у последнего в глазах двоиться не начнет. Двоиться начала, но голова, и спустя три месяца… мы получили GTX Titan Z.

В ТРИ раза дороже ($3000) GTX Titan 2013 года, но настолько ли мощнее?

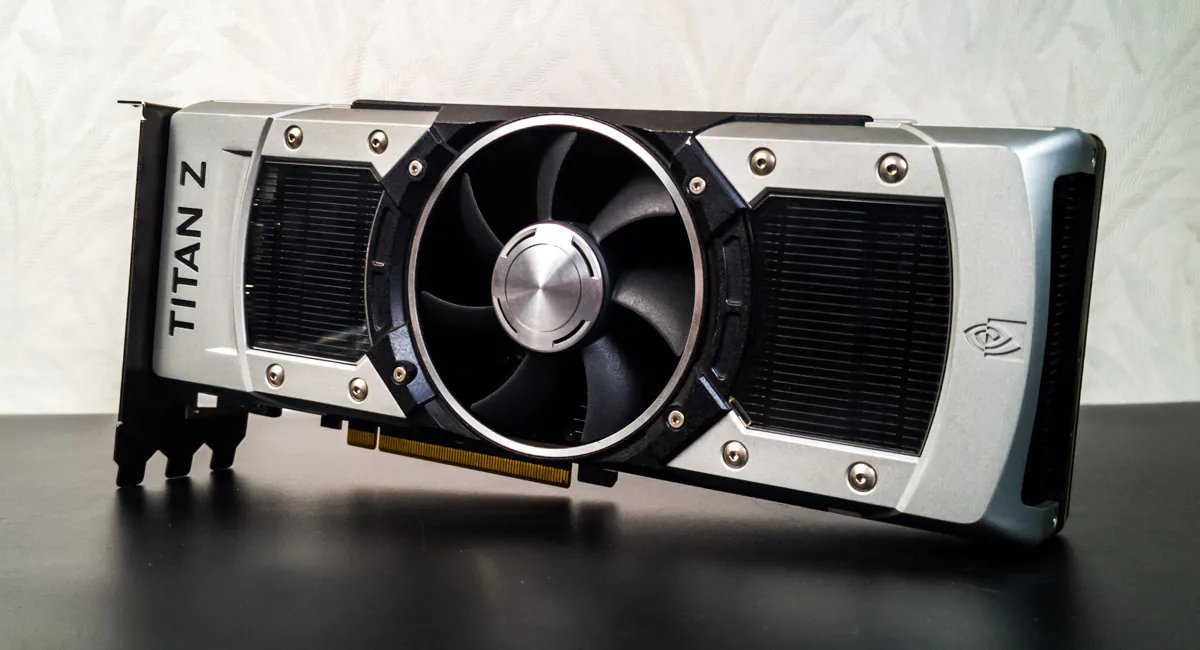

Внешне карта немного похожа на предшественников, правда вместо турбины с испарителем от Titan Black имеем вертушку, которая переместилась от правой стороны к центру и увеличилась в диаметре, занимая почти весь поперечник карты. Через полупрозрачные окошка видны радиаторы, а задняя пластина тяжелая и мощная, с продольными каналами.

Занимает монстр все четыре слота расширения PCIe, имея при этом из видеовыходов пару DVI-D Dual Channel (в чем их особенность, читай здесь), один HDMI и один DisplayPort. И разумеется, он требует все два 8-pin коннектора питания. Разумеется, не просто так.

Вы уже догадались, что EVGA GTX Titan Z – двухчиповая видеокарта. Она, фактически, представляет собой пару из GTX Titan Black на одном текстолите. Вокруг – 24 чипа по 2 Гбит памяти GDDR5, а внизу, ближе к контакту PCIe, располагается чип, отвечающий за SLI.

Да, эта вся конструкция представляет собой два видеоадаптера в SLI. Со всеми вытекающими. И меня это нервирует. На официальном сайте, в магазинах, даже в Kiev-IT, было написано о 12 ГБ видеопамяти. Технически это правда, но по факту – нет, Windows увидит всего 6.

Поясняю, в чем моя проблема. Когда видеокарты ставятся в SLI, у них не плюсуется видеопамять, но параллелизируется. Поставили две GTX 1070 8GB – получили не 16 ГБ видеопамяти, а 8. В случае с GTX Titan Z это два GTX Titan Black, которые работают в дуэте, но память у них всего 6 ГБ. Казалось бы, в чем проблема – в случае SLI с отдельными видеокартами мы теряем половину видеопамяти, а в случае с Тинтином Зэд чипов всего на 6 ГБ, ресурс не теряется впустую.

Дополнительная беда заключается в цене. Две GTX Titan Black обходились в 1200 баксов каждая. Но Titan Z стоит $3000, на 600 денег дороже, чем два компонента, взятых вместе. То есть, экономии за счёт отсутствия лишней памяти нет, есть только переплата.

Что же касается остальных компонентов… вот что мы имеем:

| Ядер CUDA | 5760 (2х2880) |

| Базовая тактовая частота | 705 МГц |

| Тактовая частота с ускорением | 876 МГц |

| Скорость заполнения текстур | 338 GigaTexels/сек |

| Видеочип | 2х GK110 |

| Техпроцесс | 28 нм TSMC |

| Поколение | Kepler |

| Быстродействие памяти | 7 Gbps |

| Объем памяти | 12 GB |

| Интерфейс памяти | 768-bit GDDR5 |

| Максимальная полоса пропускания памяти | 672 GB/sec |

| Поддержка FXAA и TXAA | Да |

| Поддержка технологии NVIDIA SLI | Да |

| 3D Vision | Да |

| PhysX | Да |

| Программное окружение | CUDA |

| Текстурных блоков | 240 |

| Блоков растеризации | 48 |

| DirectX | 12 |

| OpenGL | 4.4 |

| Шина | PCI-E 3.0 |

| Максимальное цифровое разрешение | 4096×2160 |

| Максимальное VGA разрешение | 2048×1536 |

| Медиа соединение | Dual Link DVI-D HDMI DisplayPort Dual Link DVI-I |

| Поддержка нескольких дисплеев | Да |

| HDCP | Да |

| HDMI | Да |

| Аудио вход для HDMI | Internal |

| Высота | 11,16 cm / 4,376 дюймов |

| Длина | 26,67 cm / 10,5 дюймов |

| Максимальная температура | 95 C |

| Потребление энергии | 375 W |

| Минимальные системные требования по питанию | 700 W (c минимальным напряжением 12В и номинальным током 42A в одной цепи питания) |

| Разъемы питания | 8-pin x2 |

Частоты ядра меньше, чем у GTX Titan 2013-го года, зато ядер CUDA целых 5760! Точнее, дважды по 2880, и множитель будет работать лишь в играх и программах, которые способны реализовать SLI. НО! В лучшем из случаев мы получаем в полтора раза больше ядер, чем у GTX 1080 Ti.

Надо учитывать, разумеется, что ядра CUDA версии 3,5, поколения Kepler, сильно уступают по мощности и эффективности ядрам CUDA 6.1 у Pascal. За счёт этого по итоговой производительности Titan Z при активно используемой SLI буквально чуть-чуть отстает от 1080 Ti, имея при этом цену на Б/У рынке до 50% меньше. Или 33%, если судить по ценам в Kiev-IT.

Также интересно, что на официальном сайте NVIDIA сказано о поддержке двухглавом DirectX 12, однако почти все остальные источники говорят максимум о DX11. DXDiag утверждает о том, что права NVIDIA. Видимо, видеокарту обновили. Ну и поддержка SLI тоже имеется. Потому что если взял одну видеокарту за $3000, то кто мешает установить ещё одну рядышком? Слава Белиару, что у вместо SLI теперь NVLink…

Тестовый стенд выглядит следующим образом:

Процессор AMD Ryzen 7 1800X предоставлен магазином Kiev-IT. 16-поточный монстр преспокойно утирает нос конкурентам в рабочих задачах, но и в играх тоже неплохо себя показывает за счёт турбо-частоты до 4 ГГц. Плюс – разблокированный множитель и TDP всего 95W.

Двухканальный набор Silicon Power DDR4 2x16GB 2400MHz, взявший частоту 3000 МГц, пускай и с солидными таймингами, ещё не скоро станет ботлнеком в играх. Особенно когда упор идёт в видеокарту за счёт высоких настроек графики.

Видео с тестами здесь, условия тестирования тоже:

Тестов меньше, чем мне хотелось бы, просто из-за нелюбви SLI к средствам записи и FPS Monitor в частности. Deus Ex: Mankind Divided, например, вылетала со ссылкой на нехватку видеопамяти. В Batman: Arkham Knight я поэкспериментировал, назначая один видеочип на саму игру, а второй – на обработку эффектов PhysX. Результат – 25% прироста по минимальному, среднему и максимальному FPS.

Беда в том, что при максимальных нагрузках карту, простите за мой албанский, косо*бит, из-за чего происходят резкие проседания по FPS. Поэтому в играх динамичных, начиная с Alien: Isolation и заканчивая Ghost Recon: Wildlands, лучше не выеживаться и играть на средних. С чем связана беда? С оптимизацией SLI, вестимо. А может и нет, черт его знает.

В приложениях ускорение порой очень серьёзное, но нередко не утилизируют оба видеоядра. Вот цифры – обратите внимание на утилизацию второго GPU в Blender. Это тест BMW на видеокарте.

В Premiere Pro пятьтыщ ядер CUDA позволили в реальном времени предпросматривать 4К-видео с намазанным Lumetri в соотношении 1:1. Тут претензий не имею, мощь ощущается. Но из-за 6 ГБ видеопамяти во время финальной сборки процесс у меня порой вылетал нафик. И это неприятно.

Вообще из-за того, что NVIDIA фактически убила SLI и не рекомендует использовать мульти-GPU в играх, польза от двух видеоядер сильно преувеличена. В инди-проектах свежего пошиба, вроде Mutant Football League или Totally Accurate Battlegrounds, второй чип простаивает, а первый является, по сути, замедленной GTX 780 Ti, и не особо мощнее чем GTX 1066.

Но чего вы ожидали? Последние годы SLI от NVIDIA превращается в нечто заторможенное и не приоритетное. И по оф. списку игр, поддерживающих SLI, это виднее всего. Повторы, ошибки… Наслаждайтесь:

Видеокарту нельзя назвать бесшумной. Даже учитывая, что перед приобретением её в Kiev-IT мне поменяли термопасту на Thermal Grizzly Kryonaut и заменили всевозможные термопрокладки, дуэт из флагманских 28-нанометровых видеоядер заставляют один-единственный вентилятор выть белугой под нагрузками и даже при наборе текста с двумя мониторами обращать на себя внимание. Я, признаться, уже и забыл, что такое слышать что-то, кроме жестких дисков…

(а потом я получил Manli GTX 1070 Gallardo и понял, что Titan не очень-то и громкий был).

И несмотря на то, что вентилятор GTX Titan Z умеет разгоняться до 4000 RPM, даже на скорости 50% его становится отчетливо слышно, и это ничем и никак не помогает температурам, которые в Furmark при фоновой температуре 22 градуса Цезия доходили до 84 градусов Цезаря на первое ядро и 83 на второе.

И энергопотребление… В простое одна эта видеокарта потребляет больше, чем весь мой компьютер с MSI GTX 1060 Gaming X 6GB (120 Вт), а под нагрузками может употреблять все 350 Вт в одну двухглавую морду с общим потреблением системы более 500 Вт. К счастью для меня, be quiet Power Zone 1000W справилась с нагрузкой достойно.

Но знаете что? Возвращаясь к противостоянию красных и зелёных, видеокарта Radeon R9 395X2 жрёт в больше, чем ДВА GTX Titan Z в SLI! То есть больше, чем четыре GTX Titan Black! Так что не надо мне тут… Это самое. Ну вы поняли.

Если найдете её за $400, если у вас имеется мощный блок питания, если вы получите преимущество от SLI и особенно – если вы нуждаетесь в SLI, но ваша материнская плата протокол не поддерживает (как моя X470 Gaming Plus, например)… Если вам хватит 6 ГБ видеопамяти и вы не против шумного компьютера – берите NVIDIA GeForce GTX Titan Z.

Эта модель – самая мощная двухчиповая видеокарта от NVIDIA. И самая последняя на текущий момент. И не просто так. Совместимость с современными тайтлами, желание сохранить SLI на фоне NVLink, экономность, компактность… Всего этого у Titan Z нет и уже не будет. Но она не будет забыта… поскольку шумит, как совдеповский пылесос времён Ильича, и жрёт из розетки столько же. Такое попробуй забудь.

Leave a Reply