В революцию ИИ трудно поверить. И дело не в политике — дело в математике. Проблема заключается в галлюцинациях ИИ.

Представьте себе мир, в котором калькулятор иногда говорит 2+2=5. Или где бухгалтерское программное обеспечение придумывает транзакции, которых никогда не было. Звучит абсурдно, верно? Тем не менее именно в такой мир мы шагнули с сегодняшней революцией ИИ.

С самого начала цифровой эры можно было с уверенностью сказать одно: компьютеры могли ломаться, принтеры могли вести себя неправильно, а пользователей могли сводить с ума синие экраны смерти. Но при всем этом им доверяли безупречно выполнять одну вещь: производить вычисления. Этот фундамент доверия, создававшийся десятилетиями, теперь неуклонно подрывается тем, что эксперты называют галлюцинациями ИИ.

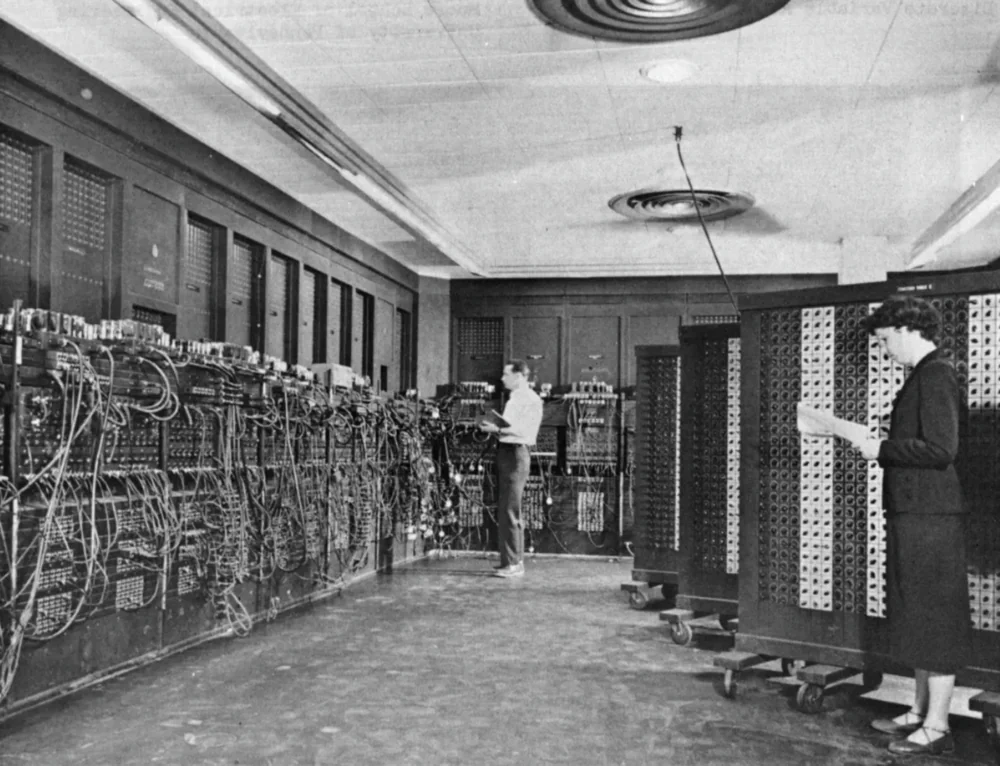

История компьютеров началась не с социальных сетей или видеоигр, а с необходимости выполнять сложные вычисления. Первый электронный компьютер общего назначения, ENIAC, занимал комнату размером 7 на 13 метров и вмещал почти 18 000 вакуумных трубок вместе с тысячами реле. Эта массивная машина была разработана для расчета таблиц артиллерийской стрельбы и помощи в работе над водородной бомбой. Она могла выполнять 5 000 сложений, 350 умножений или 40 делений в секунду — быстрее, чем все, что можно было представить в то время.

С тех пор прошло более 75 лет, и компьютеры претерпели кардинальную трансформацию. Из гигантов размером с комнату они превратились в устройства, достаточно маленькие, чтобы помещаться в наших карманах. Однако, несмотря на все технологические революции, их основное предназначение осталось прежним — компьютеры, прежде всего, машины, созданные для вычислений.

Читай также: Технофеодализм — новая форма мирового порядка

Excel — математика, которой можно доверять

Хорошим примером такой преемственности является Microsoft Excel — программа, которая по своей сути все еще является продвинутым визуальным калькулятором. За десятилетия Excel стал основой мировой экономики, им пользуются все — от малого бизнеса до транснациональных корпораций, от составления домашнего бюджета до сложных финансовых моделей Уолл-стрит. Хотя у него есть свои критики и ограничения, одно остается неизменным: его расчеты надежны.

Конечно, ошибки могут возникать и в Excel. Распространенный пример — сообщение #VALUE!, которое появляется, когда мы пытаемся выполнить математические операции не с числами, а с текстом. Но — и в этом ключевое отличие — у таких ошибок всегда есть четкие, идентифицируемые причины и простые способы устранения. Что еще более важно, Excel никогда не гадает и не придумывает результаты. Формула =SUM(A1:A10) всегда вернет один и тот же результат при одних и тех же исходных данных, независимо от того, запускаешь ты ее в первый раз или в тысячный.

Эта детерминированная природа традиционного программного обеспечения укрепляла наше доверие к компьютерам на протяжении десятилетий. Мы могли жаловаться на пользовательские интерфейсы, производительность или совместимость, но никогда не ставили под сомнение математическую точность результатов.

Читай также: Все о квантовом процессоре Microsoft Majorana 1: Прорыв или эволюция?

Галлюцинации ИИ — когда математика начинает фантазировать

И это подводит нас к основной проблеме сегодняшней революции в искусственном интеллекте. Современные модели ИИ — в частности, большие языковые модели (БЯМ) — принципиально отличаются от традиционного программного обеспечения. Вместо того чтобы выполнять конкретные, детерминированные операции, они предназначены для распознавания паттернов в огромных массивах данных и генерации правдоподобных ответов на основе этих паттернов.

Этот фундаментальный сдвиг в архитектуре приводит к тому, что эксперты называют галлюцинациями ИИ — случаям, когда модели ИИ генерируют информацию, которая кажется реальной, но совершенно неверна или оторвана от действительности. Важно отметить, что эти галлюцинации — не случайные ошибки; они являются результатом самой природы этих систем — сложного взаимодействия между обучающими данными, построением модели и тем, как модель интерпретирует запросы.

Самый тревожный аспект заключается в том, что галлюцинации ИИ часто появляются с той же степенью уверенности, что и фактическая информация. Модель может уверенно заявить, что Киев — столица Украины (что правда) и что в нем проходили летние Олимпийские игры 1995 года (что полностью выдумано). Пользователю же, особенно неспециалисту, бывает крайне сложно отличить факт от галлюцинации.

Читай также: Хороший зум в смартфоне — не фича, а необходимость! Почему я не могу без него жить

Масштабы проблемы галлюцинаций

Хотя трудно установить точную статистику частоты галлюцинаций ИИ, эксперты сходятся во мнении, что это широко распространенная проблема, затрагивающая все большие языковые модели. Наиболее подвержены галлюцинациям те системы, в которых отсутствуют эффективные механизмы проверки информации, которые опираются на устаревшие данные и не умеют правильно интерпретировать контекст запросов.

Причины возникновения галлюцинаций сложны и многоуровневы. Среди основных факторов эксперты выделяют:

-

Несовершенство обучающих данных: Если данные, используемые для обучения модели, содержат ошибки, неточности или противоречивую информацию, модель может воспроизвести эти проблемы или сгенерировать новый, ложный контент.

- Переподгонка модели: Это происходит, когда алгоритм слишком близко адаптируется к обучающему набору данных, теряя способность к обобщению и правильному выявлению новых закономерностей.

- Ошибочные предположения при проектировании модели: Если разработчики ИИ основывают свой дизайн на неверных предположениях, модель может последовательно генерировать галлюцинации.

Конкретные примеры систем ИИ, особенно склонных к галлюцинациям, включают такие китайские решения, как Qwen и DeepSeek. Несмотря на технологический прогресс, эти модели все равно сталкиваются с этой проблемой. Они часто генерируют информацию, которая кажется правдоподобной, но на самом деле является ложной или не соответствует реальности, особенно в контексте, когда данные могут быть неполными или противоречивыми.

Читай также: Qualcomm Snapdragon X Elite для ноутбуков: Все, что нужно знать

Проблема доверия — 98% все еще недостаточно

И здесь мы подходим к фундаментальной проблеме доверия. В традиционном программном обеспечении ошибки были исключением, а не правилом. В случае с искусственным интеллектом галлюцинации являются неотъемлемой частью работы системы. Даже если модель генерирует точную информацию 98% времени, оставшиеся 2% — это серьезная проблема.

Представь, что ты пользуешься калькулятором, который в 98% случаев выдает правильный результат, но в 2% случаев выдает неверный ответ. Доверили бы мы такому устройству такие задачи, как расчет налогов, разработка лекарств или проектирование моста? Ответ очевиден.

Проблема галлюцинаций ИИ особенно остро стоит в областях, требующих полной точности и фактологической корректности, таких как медицина, юриспруденция, финансы и инженерия. В этих областях даже малейшая вероятность ошибки может привести к катастрофическим последствиям.

Читай также: Что такое пространственное аудио, как оно работает и как им пользоваться

Excel против искусственного интеллекта: расчеты против конфабуляции

В Excel, когда появляется ошибка вроде #VALUE!, программа четко указывает, что что-то пошло не так. Она не пытается угадать результат или скрыть проблему. Более того, существуют конкретные рекомендации по устранению таких ошибок — например, убедиться, что все значения в математической формуле — это числа, а не текст.

С другой стороны, в случае с системами искусственного интеллекта, когда модель не знает ответа, она часто генерирует убедительный, но ложный ответ, вместо того чтобы признать отсутствие знаний. Хуже всего то, что пользователь может даже не понять, что предоставленная информация — это галлюцинация.

Согласно отчету Salesforce о состоянии данных и аналитики, 9 из 10 (почти 87%) аналитиков и ИТ-лидеров согласны с тем, что прогресс в области искусственного интеллекта придал управлению данными более высокий приоритет. Однако в том же отчете подчеркивается неуверенность респондентов в точности данных и опасения по поводу безопасности данных в контексте ИИ.

Читай также: Что такое патч безопасности и почему он так важен?

Стоимость верификации — скрытый недостаток ИИ

Сторонники искусственного интеллекта утверждают, что проблему галлюцинаций можно решить с помощью верификации информации. Действительно, проверка фактов и подтверждение результатов работы систем ИИ становятся неотъемлемой практикой в каждой организации, использующей эти технологии. Проблема, однако, заключается в том, что необходимость верификации значительно снижает ценность этих систем.

Представьте себе такую ситуацию — мы просим ИИ-ассистента написать отчет о рынке электромобилей. Система генерирует 20-страничный документ, наполненный статистикой, тенденциями и прогнозами. Документ выглядит профессионально и содержит убедительные аргументы. Проблема в том, что мы не знаем, какие части информации точны, а какие стали результатом галлюцинаций ИИ. Чтобы определить это, нам нужно будет проверить каждую статистику, каждое утверждение, каждый факт. Это означает, что, по сути, мы делаем ту работу, которую система ИИ должна была сделать за нас.

В этом и заключается фундаментальный парадокс нынешней революции ИИ — системы, которые должны были сэкономить нам время, зачастую требуют дополнительной работы по проверке своих результатов. В случае с использованием традиционного программного обеспечения, например Excel, мы можем просто довериться результатам вычислений и сосредоточиться на интерпретации данных.

Читай также: Всё о стандартах и спецификациях USB

Математически несовершенный мир искусственного интеллекта

Недоверие к системам ИИ — это не вопрос технофобии или сопротивления переменам. Это рациональная реакция на фундаментальный сдвиг в отношениях между людьми и компьютерами. На протяжении десятилетий мы строили отношения, основываясь на детерминированной надежности вычислительных машин. Теперь же мы вступаем в эру вероятностных моделей, которые по своей природе не могут гарантировать такой же уровень надежности.

Возможно, наиболее точно описать это можно через аналогию с человеческим общением. Традиционное программное обеспечение похоже на энциклопедию — она может быть неполной или содержать устаревшую информацию, но то, что в нее включено, можно считать доказанным. ИИ же напоминает разговор с человеком, который обладает впечатляющими, но несовершенными знаниями — иногда он ошибается, периодически путается, а иногда искажает факты.

Эта аналогия в контексте компьютеров означает фундаментальный регресс в плане надежности. Мы всегда ожидали от машин большей точности, чем от людей. Теперь же, как это ни парадоксально, мы обнаруживаем, что нам нужно проверять результаты, полученные ИИ, с той же осторожностью, которую мы бы применили к информации, полученной от неизвестного человека.

Читай также: ТОП-8 военных технологий будущего, на которые следует обратить внимание уже сегодня

В поисках математической достоверности

Значит ли это, что мы должны полностью отказаться от искусственного интеллекта? Абсолютно нет. Системы ИИ обладают огромным потенциалом в самых разных областях — от создания креативного контента до анализа огромных массивов данных. Проблема заключается в том, что мы должны научиться новому подходу к работе с этими системами, такому, который признает их фундаментальные ограничения.

В настоящее время ведутся интенсивные исследования, направленные на уменьшение галлюцинаций ИИ. Среди предлагаемых решений — повышение качества обучающих данных (чем лучше данные, тем ниже вероятность галлюцинаций), разработка более прозрачных методов обучения (понятные и объяснимые модели с меньшей вероятностью будут генерировать ложную информацию) и развитие механизмов фактчекинга (систем, автоматически сверяющих сгенерированный контент с авторитетными источниками).

Читай также: Как будут выглядеть пассажирские поезда будущего

Новая этика цифровой реальности

Нынешняя революция в искусственном интеллекте требует не только новых инструментов и методологий, но и новых рамок цифровой этики. Нам нужно переосмыслить, что значит доверие между людьми и машинами, каковы границы ответственности за ошибки, вызванные ИИ, и как защитить себя от дезинформации в мире, где грань между фактом и вымыслом становится все более размытой.

Согласно отчету Salesforce, исследующему доверие к данным в эпоху ИИ, риски безопасности и отсутствие гармонизации данных препятствуют их надежности. Поэтому компании, которые используют данные на основе ИИ для принятия важных решений, считают угрозы безопасности данных своей самой большой проблемой.

Это особенно важно в контексте так называемого генеративного искусственного интеллекта, который несет в себе дополнительный риск утечки данных компании в публичные большие языковые модели.

Читай также: 10 ошибок, которые упрощают работу хакеров

Вместо тысячи слов…

Я не доверяю нынешней революции ИИ не потому, что не вижу ее потенциала, а потому, что понимаю ее фундаментальные ограничения. На протяжении десятилетий мы строили нашу цифровую цивилизацию на фундаменте надежных вычислений — начиная с самых первых механических калькуляторов, через монументальный ENIAC и заканчивая вездесущими электронными таблицами. Эта математическая уверенность стала краеугольным камнем прогресса в бесчисленных областях жизни.

Нынешняя волна искусственного интеллекта вводит нас в вероятностный мир, где 98% уверенности — это новая норма. Хотя для многих приложений этого может быть достаточно, в таких критически важных областях, как здравоохранение, финансы и безопасность, требуются гораздо более высокие стандарты.

Таким образом, настоящая проблема заключается в том, чтобы использовать потенциал искусственного интеллекта, не теряя при этом математической уверенности, которая была основой нашего доверия к технологиям на протяжении десятилетий. Хотя компьютеры теперь могут разговаривать, создавать изображения и писать стихи, их самой важной функцией остаются безупречные вычисления — те же самые, которые они выполняли, когда заполняли целые комнаты и управлялись командами ученых в лабораторных халатах. Потому что в мире, где отличить факт от вымысла становится все сложнее, математическая уверенность ценна как никогда.

Читай также: