© ROOT-NATION.com - Використання контенту дозволено за умови розміщення зворотного посилання

У революцію штучного інтелекту важко повірити. І справа зовсім не в політиці, а просто в математиці. Винні галюцинації AI.

Уявіть собі світ, де калькулятор іноді каже 2+2=5. Або такий, в якому бухгалтерська програма спонтанно вигадує операції, яких ніколи не було. Звучить абсурдно? І все ж, це світ, у який ми входимо з нинішньою AI-революцією.

З самого початку цифрової ери існувала одна незаперечна основа – комп’ютери могли виходити з ладу, мати проблеми з принтерами або дратувати користувачів синіми екранами смерті. Але при цьому вони могли виконувати обчислення бездоганно. Цей фундамент довіри, вибудуваний десятиліттями, зараз систематично підривається тим, що експерти називають галюцинаціями штучного інтелекту.

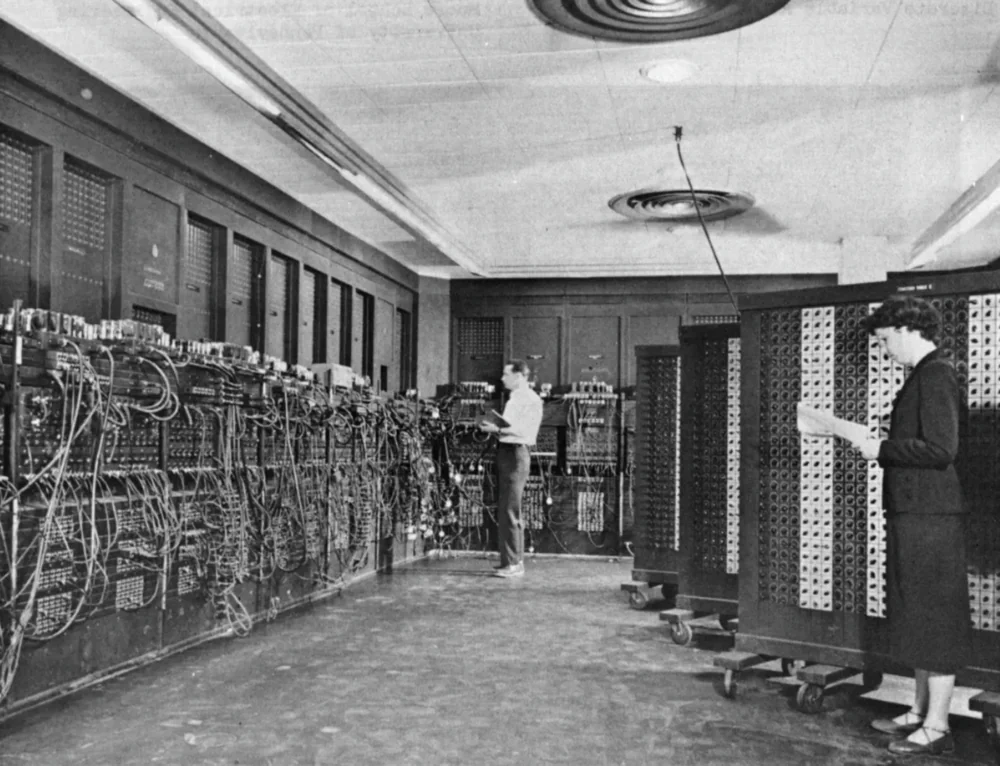

Історія комп’ютерів починається не з соціальних мереж чи відеоігор, а з необхідності виконувати складні обчислення. Перший електронний комп’ютер загального призначення, ENIAC, займав кімнату розміром 7 на 13 м і містив майже 18000 ламп і тисячі реле. Цей вражаючий прилад був розроблений для розрахунку таблиць дальності польоту ракет для артилерії та підтримки роботи над водневою бомбою. Він міг виконувати 5000 додавань, 350 множень або 40 ділень на секунду – це швидше, ніж на той час можна було собі уявити.

Відтоді пройшло більше 75 років, і комп’ютери зазнали кардинальної трансформації. З колосів, що заповнюють собою цілі кімнати, вони перетворилися на пристрої, які ми носимо в кишенях. Однак, незважаючи на всі технологічні революції, їх основна функція залишилася незмінною – комп’ютери, як і раніше, залишаються, в першу чергу, обчислювальними машинами.

Також цікаво: Технофеодалізм – нова форма світового порядку

Excel – математика, якій можна довіряти

Прекрасним прикладом такої спадкоємності є Microsoft Excel – програма, яка за своєю суттю залишається просунутим, наочним калькулятором. За останні десятиліття Excel став основою світової економіки – від малого бізнесу до найбільших корпорацій, від планування бюджету домогосподарств до складних фінансових моделей Уолл-стріт. І хоча Excel іноді критикують за недосконалість, одне залишається незмінним – його розрахунки достовірні.

Звичайно, помилки можуть з’являтися і в Excel. Поширеним прикладом є повідомлення #VALUE!, яке з’являється, коли ми намагаємося виконати математичні операції над текстом замість чисел. Але – і в цьому полягає ключова відмінність – такі помилки завжди мають чітко визначені причини і способи вирішення. Більше того, Excel ніколи не угадує і не придумує результатів обчислень. Функція =SUM(A1:A10) завжди даватиме однаковий результат для одного і того ж вхідного сигналу, незалежно від того, чи робимо ми це вперше, чи тисячного разу.

Цей детермінований характер традиційного програмного забезпечення зміцнював нашу довіру до комп’ютерів протягом десятиліть. Ми могли поскаржитися на інтерфейс, швидкість або сумісність, але ми ніколи не ставили під сумнів математичну правильність результатів.

Також цікаво: Всесвіт: Найнезвичайніші космічні об’єкти

Галюцинації AI – коли математика починає фантазувати

І ось ми підійшли до суті проблеми нинішньої революції штучного інтелекту. Сучасні моделі штучного інтелекту, особливо, так звані, великі мовні моделі (LLM), принципово відрізняються від традиційного програмного забезпечення. Вони запрограмовані не на виконання конкретних, детермінованих операцій, а на розпізнавання закономірностей у величезних наборах даних і генерування правдоподібних відповідей на їх основі.

Ця фундаментальна зміна в архітектурі призводить до того, що експерти називають галюцинаціями штучного інтелекту – випадки, коли AI-моделі генерують інформацію, яка здається реальною, але є абсолютно неправильною або не пов’язаною з реальністю. Важливо, що ці галюцинації не є випадковими помилками, а є результатом самої природи цих систем – складної взаємодії тренувальних даних, побудови моделі та способу, яким модель інтерпретує запити.

Найбільше занепокоєння викликає те, що галюцинації штучного інтелекту часто видаються з таким же рівнем впевненості, як і фактична інформація. Модель може з однаковою впевненістю сказати, що Київ є столицею України (що є правдою) і що він приймав літні Олімпійські ігри 1995 року (що є повною вигадкою). Користувачеві, особливо не фахівцеві, може бути вкрай складно відрізнити факт від галюцинації.

Також цікаво: Все про квантовий процесор Microsoft Majorana 1: Прорив чи еволюція?

Масштаби проблеми галюцинацій

Хоча точну статистику частоти галюцинацій штучного інтелекту встановити важко, експерти сходяться на думці, що це поширена проблема, яка стосується всіх великих мовних моделей. Найбільш схильні до галюцинацій системи, які не мають ефективних механізмів перевірки інформації, покладаються на застарілі дані і не можуть правильно інтерпретувати контекст запитів.

Причини галюцинацій складні і багаторівневі. Серед основних факторів фахівці вказують:

- Недосконалість тренувальних даних – якщо дані, на яких тренується модель, містять помилки, неточності або суперечливу інформацію, модель може продублювати їх або генерувати новий, неправдивий контент.

- Перетренованість моделі – ситуація, коли алгоритм занадто точно адаптується до набору тренувальних даних, втрачаючи здатність до узагальнення і правильного розпізнавання нових закономірностей.

- Помилкові припущення в дизайні моделі – якщо розробники AI засновували своє рішення на помилкових припущеннях, модель може систематично генерувати галюцинації.

Конкретними прикладами систем штучного інтелекту, особливо схильних до галюцинацій, є китайські рішення, такі як Qwen і DeepSeek, які, незважаючи на свій технологічний прогрес, все ще борються з цією проблемою.

Читайте також: Тектонічні зрушення в сфері AI: Microsoft робить ставку на DeepSeek?

Проблема довіри – 98 % все ще недостатньо

І ось ми підійшли до фундаментальної проблеми довіри. У традиційному програмному забезпеченні помилки були винятком, а не правилом. У випадку зі штучним інтелектом галюцинації є невід’ємною частиною функціонування системи. Навіть якщо модель генерує правильну інформацію в 98% випадків, решта 2% є серйозною проблемою.

Уявімо, що ми користуємося калькулятором, який у 98% випадків дає правильний результат, а в 2% випадків видає неправильну відповідь. Чи довірилися б ми такому пристрою при розрахунку податків, розробці ліків або проектуванні мосту? Відповідь очевидна.

Проблема галюцинацій штучного інтелекту особливо важлива у сферах, де потрібна повна точність і змістовна правильність – в медицині, юриспруденції, фінансах або інженерії. У цих сферах навіть найменша ймовірність помилки може призвести до плачевних наслідків.

Також цікаво:

Excel проти штучного інтелекту: розрахунок проти конфабуляції

Коли в Excel з’являється помилка #VALUE!, програма чітко повідомляє нам, що щось пішло не так. Вона не намагається вгадати результат або приховати проблему. Крім того, існують чіткі рекомендації, як вирішити таку помилку – наприклад, переконатись, що в математичній формулі всі значення є числами, а не текстом.

З іншого боку, у випадку з системою штучного інтелекту, коли модель не знає відповіді, вона часто генерує переконливу, але неправдиву відповідь замість того, щоб визнати свою необізнаність. Найгірше те, що користувач може навіть не здогадуватися, що отримана інформація є галюцинацією.

Згідно зі звітом Salesforce про стан даних та аналітики, 9 із 10 (майже 87%) аналітиків та IT-керівників погоджуються з тим, що прогрес у галузі штучного інтелекту надав управлінню даними більш високий пріоритет. Однак той самий звіт вказує на невпевненість респондентів у точності даних та занепокоєння щодо безпеки даних у контексті штучного інтелекту.

Також цікаво: Як Тайвань, Китай і США борються за технологічне домінування: велика війна чипів

Вартість верифікації – прихований недолік AI

Прихильники штучного інтелекту стверджують, що проблему галюцинацій можна вирішити шляхом перевірки інформації. Дійсно, фактчекінг та перевірка ефектів від роботи зі штучним інтелектом стають незамінними практиками в кожній організації, яка використовує ці технології. Проблема в тому, що потреба у верифікації різко знижує цінність цих систем.

Уявімо таку ситуацію – ми доручаємо AI-асистенту написати звіт про ринок електромобілів в Україні. Система генерує 20-сторінковий документ, наповнений статистикою, тенденціями та прогнозами. Документ виглядає професійно і містить переконливі аргументи. Проблема в тому, що ми не знаємо, які з цих фрагментів інформації правдиві, а які були наслідком галюцинацій AI. Щоб визначити це, нам потрібно перевірити кожну статистику, кожне твердження, кожен факт. А це означає, що ми де-факто маємо виконувати ту роботу, яку за нас мала зробити система штучного інтелекту.

Це фундаментальний парадокс нинішньої революції АІ – системи, які мали б заощадити наш час, часто вимагають додаткової роботи, пов’язаної з перевіркою їхніх результатів. У випадку використання традиційного програмного забезпечення, такого як Excel, ми можемо просто довіряти результатам обчислень і зосередитися на інтерпретації даних.

Також цікаво: Панамський канал: Історія будівництва та причини претензій США

Математично недосконалий світ АІ

Відсутність довіри до систем штучного інтелекту – це не питання технофобії чи опору змінам. Це раціональна відповідь на фундаментальну зміну парадигми у відносинах між людиною і комп’ютером. Протягом десятиліть ми будували відносини, засновані на детермінованій надійності обчислювальних машин. Зараз ми вступаємо в епоху імовірнісних моделей, які за своєю природою не можуть гарантувати таку ж надійність.

Мабуть, найточніше це передає аналогія з людським спілкуванням. Традиційне програмне забезпечення схоже на енциклопедію – вона може бути неповною або містити застарілу інформацію, але те, що в ній є, можна вважати доведеним. Штучний інтелект же нагадує розмову з людиною, яка володіє вражаючими, але недосконалими знаннями – іноді вона помиляється, іноді плутає, а іноді спотворює факти.

Така аналогія в контексті комп’ютерів означає фундаментальний регрес з точки зору надійності. Ми завжди очікували від машин більшої точності, ніж від людей. Тепер, як це не парадоксально, нам доводиться перевіряти результати роботи АІ з тією ж осторогою, з якою ми б підходили до інформації від випадкової людини.

Також цікаво: Тераформування Марса: чи може Червона планета перетворитися на нову Землю?

У пошуках математичної достовірності

Чи означає це, що ми повинні повністю відмовитися від штучного інтелекту? Категорично ні. Системи штучного інтелекту мають величезний потенціал у багатьох сферах – від генерації креативного контенту до аналізу величезних масивів даних. Проблема полягає в тому, що ми повинні навчитися новому підходу до роботи з цими системами, який враховує їх фундаментальні обмеження.

У даний час ведуться інтенсивні дослідження методів зменшення галюцинацій АІ. Серед запропонованих рішень – покращення якості навчальних даних (чим якісніші дані, тим нижча ймовірність галюцинацій), розробка більш прозорих методик навчання (моделі, які можна зрозуміти та пояснити, менш схильні генерувати неправдиву інформацію) та розвиток механізмів фактчекінгу (систем, які автоматично перевіряють згенерований контент на відповідність авторитетним джерелам).

Також цікаво: Транзистори майбутнього: На нас чекає нова ера чипів

Нова етика цифрової реальності

Нинішня революція штучного інтелекту вимагає від нас не лише нових інструментів та методологій, а й нової цифрової етики. Нам потрібно переосмислити, що таке довіра між людиною та машиною, які межі відповідальності за помилки, спричинені штучним інтелектом, і як захистити себе від дезінформації у світі, де межа між фактом і вигадкою стає все більш розмитою.

Згідно зі звітом Salesforce, який досліджує довіру до даних в епоху штучного інтелекту, ризики безпеки та відсутність гармонізації даних перешкоджають його надійності. Тому компанії, які використовують дані на основі штучного інтелекту для важливих рішень, найбільшою проблемою вважають саме загрози безпеці даних.

Це особливо важливо в контексті так званого генеративного штучного інтелекту, який несе додатковий ризик витоку власних даних компаній у публічні великі мовні моделі.

Теж цікаво: Що таке DeepSeek і чому всі про нього говорять

Замість тисячі слів…

Я не довіряю нинішній революції у сфері штучного інтелекту не тому, що не бачу її потенціалу, а тому, що розумію її фундаментальні обмеження. Протягом десятиліть ми будуємо нашу цифрову цивілізацію на фундаменті надійних розрахунків – від перших механічних калькуляторів, через монументальний ENIAC, до всюдисущих електронних таблиць. Ця математична впевненість була запорукою прогресу в незліченних сферах життя.

Нинішня хвиля штучного інтелекту вводить нас у імовірнісний світ, де 98-відсоткова впевненість є новою нормою. І хоча цього може бути достатньо для багатьох застосувань, нам потрібні набагато вищі стандарти в ключових сферах – таких як медицина, фінанси та безпека.

Отже, справжнє завдання полягає в тому, щоб використовувати потенціал штучного інтелекту, не втрачаючи при цьому математичну впевненість, яка була основою нашої довіри до технологій протягом десятиліть. І хоча комп’ютери тепер можуть розмовляти, створювати зображення та писати вірші, їхньою найважливішою функцією все ще є бездоганний підрахунок — та сама функція, яку вони виконували, ще коли заповнювали собою цілі кімнати та керувалися командами вчених у білих халатах. Тому що у світі, де все важче відрізнити факт від вигадки, математична впевненість стає ціннішою, ніж будь-коли раніше.

Також цікаво:

AI на солях