© ROOT-NATION.com - Використання контенту дозволено за умови розміщення зворотного посилання

NVIDIA – перша компанія в історії індустрії чипів, капіталізація якої перевищила трильйон доларів. У чому секрет успіху?

Впевнений, що багато з вас чули про компанію NVIDIA і у більшості з вас вона асоціюється саме з графічними процесорами, адже словосполучення “NVIDIA GeForce” чули майже всі.

NVIDIA нещодавно увійшла у фінансову історію в ІТ-індустрії. Це перша компанія з виробництва інтегральних схем, ринкова вартість якої перевищила трильйон доларів. Це також п’ята компанія, пов’язана з технологіями, в історії, яка досягла такого великого (за показником ринкової капіталізації) успіху. Раніше такою високою оцінкою могли похвалитися тільки Apple, Microsoft, Alphabet (власник Google) і Amazon. Тому інколи фінансисти називали це “Клубом чотирьох”, який тепер поповнився ще й NVIDIA.

До того ж за ринковою капіталізацією вона залишає далеко позаду AMD, Intel, Qualcomm та інші технологічні компанії. Це було б неможливим без далекоглядної політики компанії, запровадженої десятиліття тому.

Читайте також: Чи є майбутнє у TruthGPT від Ілона Маска?

Неймовірний попит на NVIDIA H100 Tensor Core

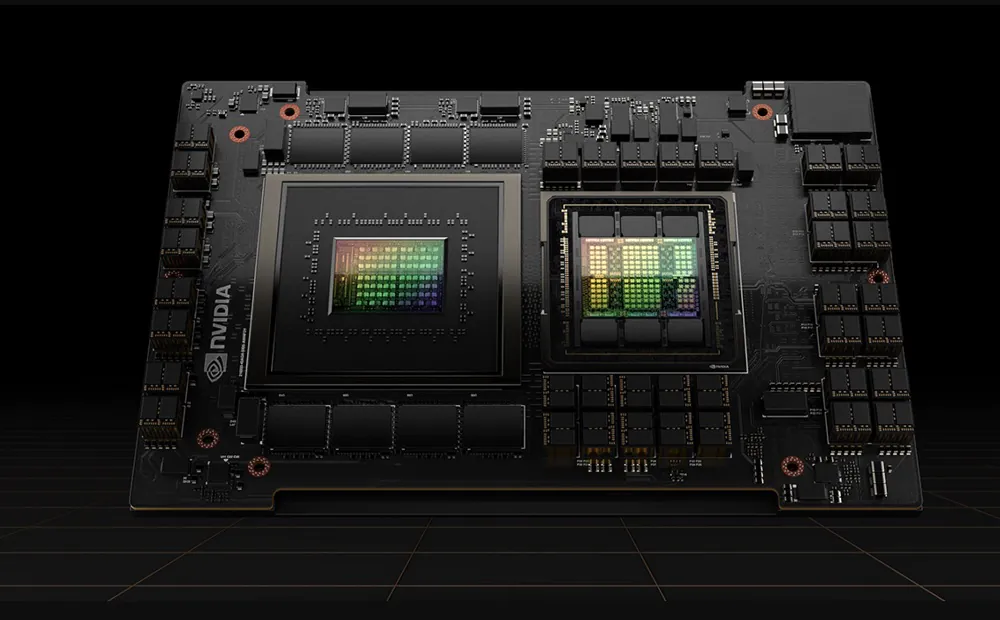

В чому секрет такого підвищення капіталізації? Насамперед, це реакція біржі на успіх чипа NVIDIA H100 Tensor Core, який користується підвищеним попитом у провідних постачальників хмарної інфраструктури та онлайн-сервісів. Ці чипи купують Amazon, Meta і Microsoft (для власних потреб і потреб свого партнера – компанії OpenAI). Вони особливо енергоефективні в прискоренні розрахунків, характерних для генеративного штучного інтелекту, таких як ChatGPT або Dall-E. Це неймовірний стрибок у порядку величин для прискорених обчислень. Ми отримуємо безпрецедентну продуктивність, масштабованість і безпеку для будь-якого робочого навантаження з NVIDIA H100 Tensor Core GPU.

За допомогою системи перемикання NVIDIA NVLink можна підключити до 256 графічних процесорів H100 для прискорення робочих навантажень у масштабі екза. Графічний процесор також містить спеціальний Transformer Engine для вирішення мовних моделей із трильйонами параметрів. Комбіновані технологічні інновації H100 можуть пришвидшити великі мовні моделі (LLM) у неймовірні 30 разів порівняно з попереднім поколінням, що забезпечує провідний у галузі розмовний ШІ. Розробники вважають його майже ідеальним для машинного навчання.

Однак H100 з’явився не на порожньому місці. І, правду кажучи, він не особливо революційний. NVIDIA, як жодна інша компанія, вже багато років вкладає величезні ресурси у штучний інтелект. В результаті компанія, пов’язана в основному з брендом відеокарт GeForce, може ставитися до споживчого ринку мало не як до хобі. Це вибудовує реальну владу на ринку ІТ-гігантів, адже NVIDIA вже може розмовляти з ними на рівних.

Цікаво також: Що таке мережі 6G і для чого вони потрібні?

Штучний інтелект – це майбутнє?

Сьогодні у цьому впевнені майже всі, навіть скептично налаштовані експерти у цій сфері. Зараз це вже майже аксіома, трюїзм. Хоча NViDIA знала про це ще 20 років тому. Я вас здивував?

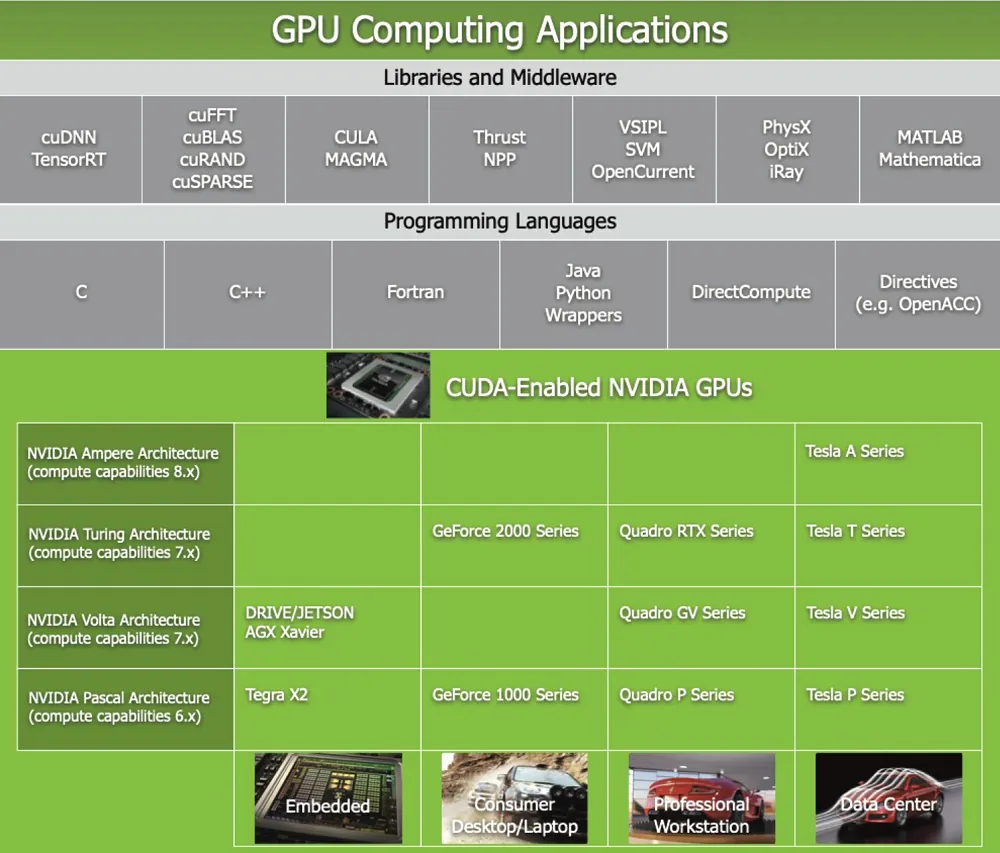

Технічно, перший тісний контакт NVIDIA зі штучним інтелектом стався в 1999 році, коли на ринку з’явився процесор GeForce 256, здатний прискорювати обчислення машинного навчання. Однак NVIDIA почала серйозно інвестувати у штучний інтелект лише в 2006 році, коли представила архітектуру CUDA, яка дозволила використовувати можливості паралельної обробки графічних процесорів для навчання і досліджень.

Що таке CUDA? Найкраще його визначити як паралельну обчислювальну платформу та програмний інтерфейс (API), які дозволяють програмному забезпеченню використовувати графічні процесори для обробки загального призначення (GPGPU). Цей підхід називається обчисленням загального призначення на GPU. До того ж CUDA – це програмний рівень, який дає прямий доступ до віртуального набору інструкцій і паралельних обчислювальних елементів графічного процесора. Він призначений для роботи з такими мовами програмування, як C, C++ і Fortran.

Саме ця доступність полегшує паралельним розробникам використання ресурсів GPU, на відміну від попередніх API, таких як Direct3D і OpenGL, які вимагали передових навичок графічного програмування.

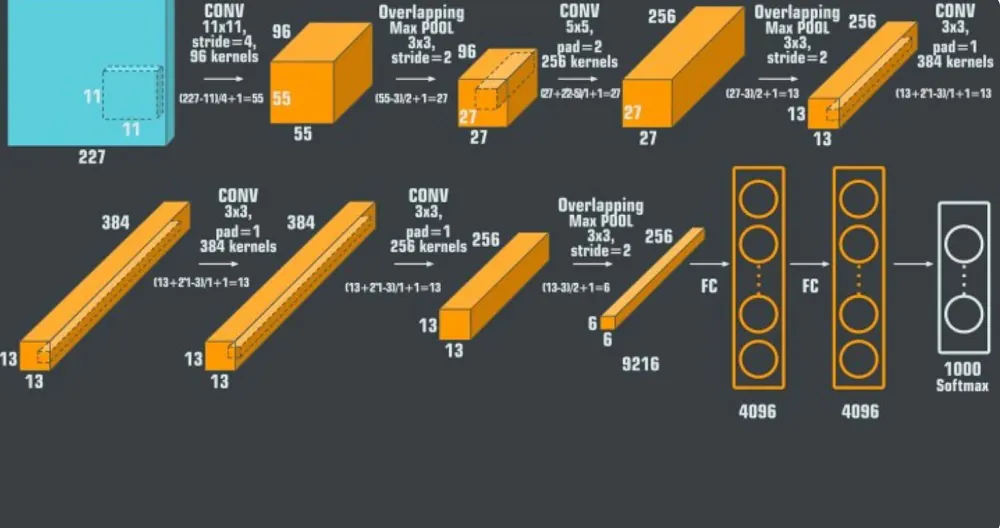

Важливим проривом стало надання компанією NVIDIA обчислювальної потужності для новаторської нейронної мережі AlexNet. Це згорткова нейронна мережа (CNN), розроблена українцем Алексом Крижевським у співпраці з Іллею Суцкевером та Джеффрі Гінтоном.

Згорткові нейронні мережі (CNN) завжди були основною моделлю для розпізнавання об’єктів — це потужні моделі, якими легко керувати та ще легше навчати. Вони не відчувають переобладнання в будь-якому тривожному масштабі під час використання на мільйонах зображень. Їх продуктивність майже ідентична стандартним нейронним мережам прямого зв’язку такого ж розміру. Єдина проблема: їх важко застосувати до зображень високої роздільної здатності. Масштаб ImageNet потребував інновацій, які були б оптимізовані для графічних процесорів і скоротили б час навчання, одночасно покращуючи продуктивність.

30 вересня 2012 року AlexNet брав участь у конкурсі ImageNet Large Scale Visual Recognition Challenge. Мережа досягла результату 15,3% у тесті п’ятірки найбільших помилок, що на понад 10,8% нижче, ніж результат другого місця.

Основний висновок з оригінальної роботи полягав у тому, що складність моделі була обумовлена її високою продуктивності, яка також була дуже дорогою з точки зору обчислень, але стала можливою завдяки використанню графічних процесорів (GPU) під час процесу навчання.

Сама згорткова нейронна мережа AlexNet складається з восьми рівнів; перші п’ять є згортковими шарами, деяким з них передують шари з максимальним об’єднанням, а останні три є повністю зв’язаними шарами. Мережа, за винятком останнього рівня, розділена на дві копії, кожна з яких працює на одному GPU.

Тобто, саме завдяки NVIDIA й досі більшість експертів та вчених вважають, що AlexNet – це неймовірно потужна модель, здатна досягти високої точності на дуже складних наборах даних. AlexNet є провідною архітектурою для будь-якого завдання виявлення об’єктів і може мати дуже широке застосування в секторі комп’ютерного зору для проблем штучного інтелекту. У майбутньому AlexNet може використовуватися більше, ніж CNN, у сфері зображення.

Цікаво також: Феномен Bluesky: що за сервіс і чи надовго?

Штучний інтелект не тільки в лабораторіях і дата-центрах

В NVIDIA побачили великі перспективи ШІ також в технологіях споживчих пристроїв та Інтернету речей. У той час як конкуренти тільки починають розглядати більш широке інвестування у новий тип інтегральних схем, NVIDIA вже працює над їх мініатюризацією. Особливо важливий, мабуть, чип Tegra K1, розроблений у співпраці з Tesla та іншими автомобільними компаніями.

Процесор Tegra K1 є одним із перших процесорів NVIDIA, розроблених спеціально для програм AI у мобільних і вбудованих пристроях. Tegra K1 використовує ту саму архітектуру графічного процесора, що й серії графічних карт і систем NVIDIA GeForce, Quadro і Tesla, яка забезпечує високу продуктивність і сумісність з графічними та обчислювальними стандартами, такими як OpenGL 4.4, DirectX 11.2, CUDA 6.5 і OpenCL 1.2. Завдяки цьому процесор Tegra K1 може підтримувати передові алгоритми штучного інтелекту, такі як глибокі нейронні мережі, навчання з підкріпленням, розпізнавання зображень і мови, а також аналіз даних. Tegra K1 має 192 ядра CUDA.

У 2016 році NVIDIA випустила серію процесорів Pascal, оптимізованих для підтримки глибоких нейронних мереж та інших моделей штучного інтелекту. За рік на ринку з’явилася серія процесорів Volta для програм, пов’язаних зі штучним інтелектом, які є ще більш ефективними та енергозберігаючими. У 2019 році NVIDIA купує Mellanox Technologies, виробника високопродуктивних комп’ютерних мереж для центрів обробки даних і суперкомп’ютерів.

В результаті всі вони використовують процесори NVIDIA. На споживчому ринку, наприклад, геймери використовують революційний алгоритм реконструкції зображення DLSS, завдяки якому вони можуть насолоджуватися чіткішою графікою в іграх, не витрачаючи значних коштів на відеокарту. На бізнес-ринку визнано, що чипи NVIDIA багато в чому виходять за рамки того, що пропонують конкуренти. Хоча не те, щоб Intel і AMD повністю проспали інтелектуальну революцію.

Теж цікаво: Найкращі інструменти на основі штучного інтелекту

Intel і AMD у сфері штучного інтелекту

Давайте поговоримо про прямих конкурентів NVIDIA у цьому сегменті ринку. Intel і AMD працюють тут все активніше, але з великою затримкою.

Intel придбала кілька компаній зі штучного інтелекту, таких як Nervana Systems, Movidius, Mobileye і Habana Labs, щоб посилити свій портфель технологій і рішень у сфері штучного інтелекту. Компанія Intel також пропонує апаратні та програмні платформи для штучного інтелекту, такі як процесори Xeon, FPGA, чипи NNP та бібліотеки оптимізації. Intel також співпрацює з партнерами з державного та приватного секторів, щоб просувати інновації та освіту в галузі штучного інтелекту.

AMD розробила серію процесорів Epyc і відеокарт Radeon Instinct, які оптимізовані для програм ШІ та глибокого навчання. AMD також співпрацює з такими компаніями, як Google, Microsoft, IBM і Amazon, надаючи хмарні рішення для ШІ. AMD також намагається брати участь у дослідженнях і розробках ШІ через партнерство з академічними установами та галузевими організаціями. Все це дуже добре, хоча NVIDIA вже значно випередила їх, і її успіх у галузі розробок та підтримки алгоритмів ШІ незрівнянно більший.

Цікаво також: Підсумки Google I/O 2023: Android 14, Pixel та багато ШІ

NVIDIA пов’язана з відеоіграми вже протягом десятиліть

Саме про це теж не слід забувати. NVIDIA не надає точного розподілу своїх доходів між споживчим і бізнес-ринками, але їх можна оцінити на основі операційних сегментів, які компанія розкриває у своїх фінансових звітах. NVIDIA виділяє чотири операційні сегменти: ігри, професійна візуалізація, центри обробки даних і автомобілі.

Можна припустити, що ігровий сегмент в основному орієнтований на споживчий ринок, оскільки включає продаж відеокарт GeForce і чипів Tegra для ігрових консолей. Сегмент професійної візуалізації в основному орієнтований на бізнес-ринок, оскільки включає продаж відеокарт Quadro і чипів RTX для робочих станцій і професійних програм. Сегмент центрів обробки даних також в основному орієнтований на бізнес-ринок, оскільки включає продаж GPU та NPU (тобто чипів наступного покоління – більше не GPU, а розроблених виключно для AI) для серверів і хмарних сервісів. Автомобільний сегмент націлений як на споживчий, так і на бізнес-ринки, оскільки він включає продаж систем Tegra та Drive для інформаційно-розважальних систем і автономного водіння.

Виходячи з цих припущень, можна оцінити частку доходів від споживчого та бізнес-ринків у загальних доходах NVIDIA. Згідно з останнім фінансовим звітом за 2022 рік, доходи компанії NVIDIA за операційними сегментами були такими:

- Ігри: $12,9 млрд

- Професійна візуалізація: $1,3 млрд

- Центри обробки даних: $9,7 млрд

- Автомобілі: $0,8 млрд

- Усі інші сегменти: $8,7 млрд

Загальний дохід NVIDIA склав $33,4 млрд. Якщо припустити, що автомобільний сегмент розподіляється приблизно порівну між споживчим та бізнес-ринком, можна розрахувати наступні пропорції:

- Дохід від споживчого ринку: (12,9 + 0,4) / 33,4 = 0,4 (40%)

- Дохід від бізнес-ринку: (1,3 + 9,7 + 0,4 + 8,7) / 33,4 = 0,6 (60%)

Це означає, що близько 40% з доходів NVIDIA надходить від споживчого ринку, і близько 60% від з бізнес-ринку. Тобто, основний напрямок – саме бізнес-сегмент. Але й ігрова індустрія приносить досить непогані доходи. Найголовніше, що вони ростуть з кожним роком.

Цікаво також: Щоденник сварливого старого ґіка: Bing vs Google

Що нам принесе майбутнє?

Очевидно, що у NVIDIA вже є план участі в розробках алгоритмів штучного інтелекту. І він набагато ширший і перспективніший, ніж у будь-якого з прямих конкурентів.

Лише за останній місяць NVIDIA оголосила про численні нові інвестиції у штучний інтелект. Одним з них є механізм GET3D, який здатний генерувати складні тривимірні моделі різних об’єктів і персонажів, що достовірно відображають реальність. GET3D може генерувати близько 20 об’єктів за секунду за допомогою одного графічного чипа.

Слід також згадати ще про один цікавий проект. Мова про Israel-1 — це суперкомп’ютер для програм штучного інтелекту, який NVIDIA створює у співпраці з Міністерством науки і технологій Ізраїлю та компанією Mellanox. Очікується, що машина матиме обчислювальну потужність понад 7 петафлопс і використовуватиме понад 1000 графічних процесорів NVIDIA A100 Tensor Core. Israel-1 буде використовуватися для досліджень і розробок у таких сферах як медицина, біологія, хімія, фізика та кібербезпека. А це вже дуже перспективні капіталовкладення, з огляду на довгострокові перспективи.

Також вже зараз є ще один проект – NVIDIA ACE. Це нова технологія, яка має революціонізувати ігрову індустрію, дозволяючи гравцю взаємодіяти з неігровим персонажем (NPC) природним і реалістичним способом. Ці персонажі зможуть вести відкритий діалог з гравцем, реагувати на його емоції та жести, і навіть висловлювати власні почуття та думки. NVIDIA ACE використовує передові мовні моделі та генератори зображень на основі штучного інтелекту.

Перший трильйон доларів у NVIDIA. Схоже, скоро їх буде більше. Ми обов’язково будемо слідкувати за успіхами компанії та розповідати вам.

Читайте також:

- 7 найкрутіших варіантів використання ChatGPT

- ChatGPT: Проста інструкція з використання

- Я перевірив, як працює чат-бот Bing, і взяв у нього інтерв’ю