Компанія Apple скасовує запуск своєї спірної функції сканування фото на предмет пошуку заборонених фото дітей, системи, яка повинна була сканувати завантажені в iCloud фотографії та чати iMessage на наявність ознак незаконного сексуального змісту. Оголошена в минулому місяці, система повинна була використовувати сторонню базу даних матеріалів про сексуальне насильство над дітьми (CSAM) для пошуку ознак незаконних фотографій, завантажених в хмару, але відразу ж зустріла опір з боку захисників конфіденційності.

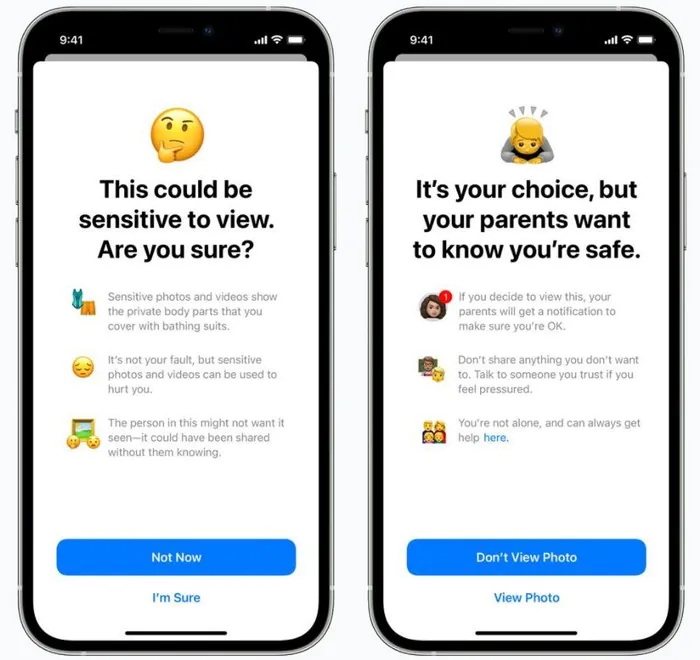

Плутанину посилило те, що Apple фактично анонсувала дві системи одночасно, хоча їх функціональність в багатьох місцях була змішана. З одного боку, iMessage використовуватиме розпізнавання зображень, щоб відзначати потенційно відверті фотографії, якими діляться в розмовах з молодими користувачами. Якщо така картинка потрапляє в загальний доступ, вона автоматично піддається цензурі, і, як варіант, батьки повідомляються про її зміст.

Водночас інша система перевіряла б наявність CSAM. Контролювалися б тільки зображення, завантажені в сервіс iCloud Photos компанії Apple, з використанням картинок відбитків пальців, створених експертними агентствами на основі бази даних подібного незаконного контенту. Якщо було б виявлено кілька таких зображень, Apple повідомила б про такого користувача владі.

Беручи до уваги проблеми конфіденційності та безпеки, Apple передбачила ряд застережень. Сканування буде відбуватися на пристрої, а не віддалено, відзначили в компанії, а відбитки пальців, за якими будуть порівнюватися зображення, не міститимуть власне незаконного контенту. Навіть якщо завантажені зображення будуть відзначені, перед тим, як буде складено звіт, їх перевірить людина.

Проте, противники цих нововведень були налаштовані рішуче. Система Apple – це слизька доріжка, попереджали вони, і компанія з Купертіно – попри свої заяви про зворотне – безсумнівно, зіткнеться з тиском з боку правоохоронних органів і урядів. Було відзначено, що молоді люди також можуть піддатися ризику, а їх право на приватне життя буде поставлене під загрозу, якщо Apple випадково видасть їх батькам як представників ЛГБТ через систему сканування iMessage.

За неофіційною інформацією, отриманою від співробітників компанії, керівники Apple були приголомшені масштабами негативної реакції і тим, як довго вона тривала. Тепер Apple підтвердила, що більше не запускатиме нові системи разом з iOS 15, iPadOS 15, watchOS 8 і macOS Monterey цьогоріч.

«Минулого місяця ми оголосили про плани з впровадження функцій, покликаних допомогти захистити дітей від хижаків, які використовують комунікаційні інструменти для вербування і експлуатації, а також обмежити поширення матеріалів про сексуальне насильство над дітьми», – йдеться у заяві Apple. «Ґрунтуючись на відгуках клієнтів, груп захисту, дослідників та інших людей, ми вирішили взяти додатковий час в найближчі місяці для збору інформації та внесення поліпшень, перш ніж випустити ці критично важливі функції безпеки дітей».

Для ясності, мова не йде про повне скасування нових систем CSAM взагалі, а лише про затримку. Проте, це, швидше за все, буде розглядатися як перемога захисників конфіденційності, які, визнаючи необхідність захисту дітей від хижацької поведінки, сумнівалися в тому, що широкомасштабне сканування є кращим способом зробити це.

Читайте також:

- Apple дозволить використовувати інші платіжні системи в App Store

- Apple першою в США подорожчала до $2,5 трлн