Коли ми чуємо штучний інтелект і машинне навчання, ми уявляємо комп’ютер, який може самостійно думати і самонавчатися. Тобто, практично як людська істота.

Ми сприймаємо світ за допомогою комбінації кількох органів чуття, таких як зір, слух та розпізнавання мови. А ось машини інтерпретують світ за допомогою даних, що обробляються алгоритмами. Тобто, коли машина бачить фотографію, вона її переводить у набір метаданих, які використовує для виконання поставленого завдання. І якщо ускладнити завдання, тобто де крім зображення буде ще й звук, тут ШІ починає губитися.

«Головна проблема тут у тому, як машина може узгодити ці різні модальності? Нам людям це легко. Ми бачимо машину, а потім чуємо звук проїжджаючої повз автівки, і ми знаємо, що це одне й те саме. Але для машинного навчання все не так просто», — сказав Олександр Лю, аспірант Лабораторії комп’ютерних наук та штучного інтелекту (CSAIL) та перший автор статті, присвяченої цій проблемі.

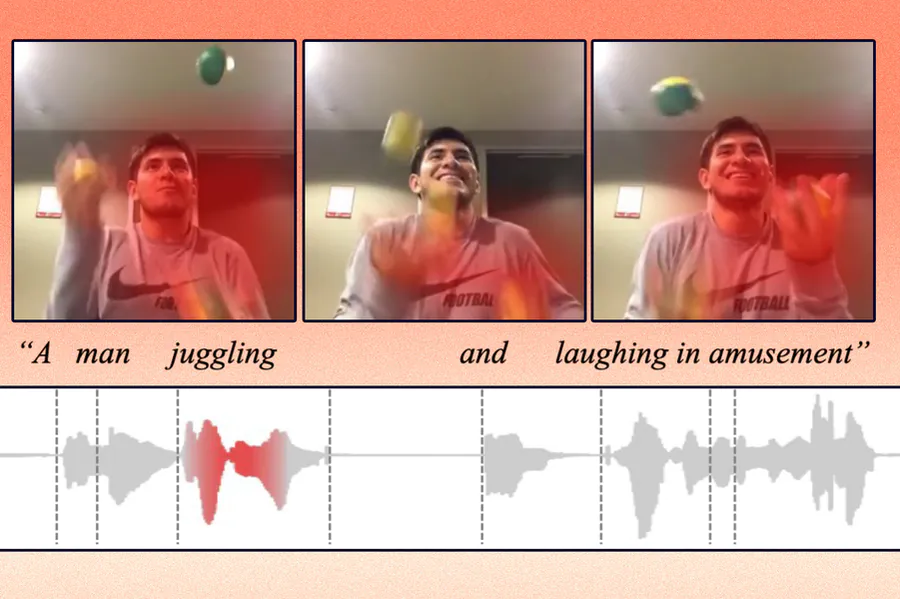

Лю та його співробітники розробили метод штучного інтелекту, який вчиться представляти дані таким чином, щоб уловлювати поняття, які є спільними для візуальних та звукових модальностей. Наприклад, їх метод може дізнатися, що дія плачу дитини у відео пов’язана зі словом «плач» в аудіокліпі. Використовуючи ці знання, їхня модель машинного навчання може визначити, де у відео відбувається певна дія, і помітити його.

Цей метод, можливо, колись буде використовуватися, щоб допомогти роботам дізнаватися про поняття у світі через сприйняття, більше схоже на те, як це роблять люди. Модель все ще має деякі обмеження, які вчені сподіваються усунути в майбутній роботі. Поки що їх дослідження зосереджені на даних двох модальностей одночасно, але в реальному світі люди одночасно стикаються з багатьма потоками даних, які обробляють не замислюючись. Машинам ще доведеться пізнати це.

Ви можете допомогти Україні боротися з російськими окупантами. Найкращий спосіб зробити це – пожертвувати кошти Збройним Силам України через Savelife або через офіційну сторінку НБУ.

Читайте також:

- Штучний інтелект допоможе передбачати ДТП до їх виникнення

- OpenAI навчила штучний інтелект перетворювати команди на програмний код