5 月 8 日至 日,專門從事人工智能 (AI) 技術創建和開發的教授、開發人員和工程師會議在加利福尼亞舉行。 在四天的積極討論過程中,編制了一份現在已經使用和未來應該應用的人工智能原則清單。 其實已經對過去幾十年人類在機器學習領域取得的成就進行了一定的總結。

一般來說,“人工智能”與人腦和智力本身沒有直接關係。 這個術語的作者美國計算機科學家約翰·麥卡錫是這樣解釋這個概念的:“問題是我們還不能籠統地定義我們想要稱之為智能的計算過程。我們只了解一些智能機制。因此,在這門科學範圍內的智能下,只有實現世界目標的能力的計算部分才能被理解。 這是 1956 年在達特茅斯大學的一次會議上宣布的。

時間證實了麥卡錫的話。 今天,我們使用信息工具來實現我們的目標,我們關於簡化世界或思考未來的想法越來越與軟件代碼密切相關。 是的,我們改變了同樣作品的想法,但我們絕對不排除它們無處不在。

因此,所有 23 個編撰的“未來法則”被分為三組:科學研究問題、倫理和價值觀、技術觀點。

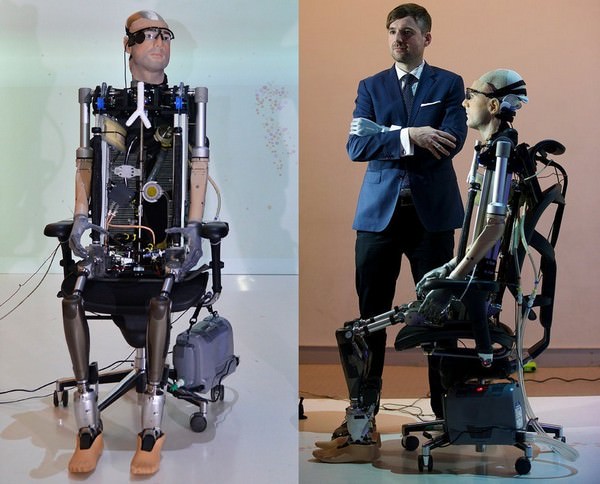

人工智能構成

研究部分

- 人工智能研究的目標不僅是創造一種狹隘的設備,而且是造福於整個社會。

2. 人工智能的投資應進入確保技術有用性的研究領域,以便對信息學、經濟學、法律、倫理學、社會科學等問題給出更準確和通用的答案:

- 如何保證AI的高可靠性,成功抵禦黑客攻擊,輕鬆防故障?

- 如何借助自動化,花費最少的資源,達到預期的目標?

- 考慮到人工智能的出現,如何根據現代經典有效地更新法律體系,確保正義?

- 人工智能將獲得什麼樣的法律和種族地位?

3. 確保研究人員和政治家之間建設性和平等的互動。

4. 文化成果充分公開透明,進一步利用人工智能。

5. 人工智能研究人員之間的互動與合作,以避免激烈的競爭。

道德價值觀

6. 人工智能係統必須在整個運行期間安全可靠。

7. 盡快找出問題的原因並隨後排除。

8.自治系統對法院判決的任何干預都必須得到授權,並在委員會主管成員(人)核實的情況下進行報告。

9. 由設計或軟件錯誤引起的損壞、故意製造危險情況的責任由開發人員和工程師承擔。

10. 所有自主人工智能係統都應努力獲取普世人類價值觀的知識。

11. 人工智能的設計和運行方式必須符合人類尊嚴、權利、自由和文化多樣性的理想。

12. 一個人在使用人工智能的過程中產生的信息必須在未來對同一個人可用(管理結果和收集的數據的可能性)。

13. 人工智能在處理個人數據時不應無理限制人們真實或想像的自由。

14. 人工智能技術應該讓盡可能多的人受益和使用。

15. 人工智能的經濟和社會成就是全球性的,應該以造福人類為目標。

16. 人總是有選擇:獨立做決定或委託給人工智能。

17. 人工智能的目的是在不帶來破壞和災難的情況下改善和豐富社會。

18. 軍備競賽中使用人工智能技術的可能性應該降為零,事實上,武裝對抗也應該停止。

長期問題

19.我們必須絕對清醒地評估人工智能能力的極限,避免資源的不合理消耗。

20. 人工智能的發展將是集約化的,因此技術必須得到控制,以免引起不可逆的反應。

21. 風險,尤其是大規模風險,應以確保將可能損失降至最低的方式進行規劃。

22. 人工智能係統具有自我發展和自我複制的能力,會導致人工智能活動質量下降,因此應定期對關鍵指標進行控制。

23. 超級智能是一種服務於並將服務於全人類利益的技術,不服從任何特定的私人組織或國家。

另請閱讀: Hyperloop:真空火車比賽怎麼樣?

讓我們簡要回顧一下報告的主要論點。 專家們擔心在人工智能密集發展的當下,自身的落後,因此他們力求確保對技術的絕對控制。 人工智能的全球公共價值及其與人類文化的融合也被反復強調。 但是,我們很快就會知道該計劃是否會實施。 人工智能就像一隻小狗,現在它會跑,會玩,但它最終會成為什麼樣的狗,主要取決於主人。

目前,這項“法案”正處於地球公民的批准階段,所以如果你想要一個安全、幸福和科技的未來,那就放心吧”投票” 採納這些絕對合理和必要的原則。

圖靈測試與人工智能

偉大的數學家艾倫圖靈也涉足人工智能技術,所以他想出了一個非常有趣的測試。 圖靈測試最早出現在 1950 年哲學出版物 Mind 的文章“Computing machines and the mind”中。 測試的想法是確定機器思維的能力,一般來說,它的存在本身。

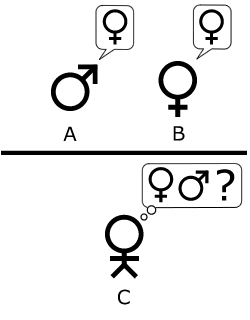

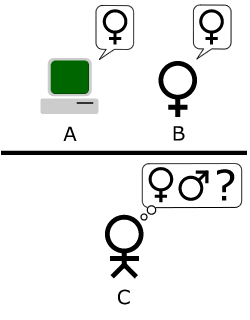

標準解釋如下:“一個人與一台計算機和一個人交互。根據問題的答案,他必須確定他正在與誰交談:..與人或計算機程序。 計算機程序的任務是誤導一個人,迫使他做出錯誤的選擇。” 所有參與者都無法看到對方,交流以測試形式進行,因為測試的目的不是測試語音識別設備的技術能力,而是模仿人類思維的能力。

通信也是在受控的時間間隔內進行的,因此“法官”無法根據響應速度得出結論。 有趣的是,發明這個規則是因為在創建這個測試時,計算機的反應比人慢,現在也是必要的,因為現在人落後了。

此外,基於此測試,還創建了一個類似的測試來確定對話者的性別。 在裁判的角色中,選手C必須與選手A和B進行交流,實際上是一男一女。

一篇關於 AI 的研究論文發表了以下評論:“現在我們問,‘如果機器在這個遊戲中扮演玩家 A 會發生什麼’,如果測試涉及人和女士? 這些問題將取代我們原來的問題:“機器能思考嗎”。

也就是說,我們將回答更簡單的問題,而不是一個絕對牽強的問題,並堅持不懈地做,從而越來越接近人們期待已久的人工智能心智能力這一主要問題的答案。

這裡的人們忙於真正重要的工作。 明確了人工智能的權利和義務。 地球是一個對比鮮明的星球。 一方面,我們生活在一個技術飛速發展的時代,另一方面,我們生活在飢餓、人道主義災難和軍事侵略的時代。 其特點是進步出於某種原因來自西方,而蒙昧主義來自東方。 生活在烏克蘭,你會特別敏銳地註意到這一點……而不是聯合起來,讓時間更接近“宇宙飛船犁過宇宙”的時間。

+1 描述的非常準確