Маючи мільйони і мільярди числових параметрів, моделі глибокого навчання можуть робити багато: виявляти об’єкти на фотографіях, розпізнавати мову, генерувати текст і приховувати шкідливі програми. Дослідники з Каліфорнійського університету в Сан-Дієго та Університету Іллінойсу виявили, що нейромережі можуть вбудовувати шкідливі корисні навантаження, не запускаючи антивірусне програмне забезпечення.

Їх метод приховування шкідливих програм, EvilModel, проливає світло на проблеми безпеки глибокого навчання, які стали гарячою темою для обговорення на конференціях з машинного навчання та кібербезпеки. Оскільки глибоке навчання міцно укорінилося в програмах, які ми використовуємо щодня, спільноті фахівців з безпеки необхідно подумати про нові способи захисту користувачів від цих загроз.

Кожна модель глибокого навчання складається з кількох шарів штучних нейронів. Залежно від типу шару кожен нейрон має зв’язок з усіма або деякими нейронами у своєму попередньому та наступному шарі. Сила цих зв’язків визначається числовими параметрами, які використовуються під час навчання, оскільки модель DL вивчає завдання, на яке вона була розроблена. Великі нейронні мережі можуть містити сотні мільйонів чи навіть мільярди параметрів.

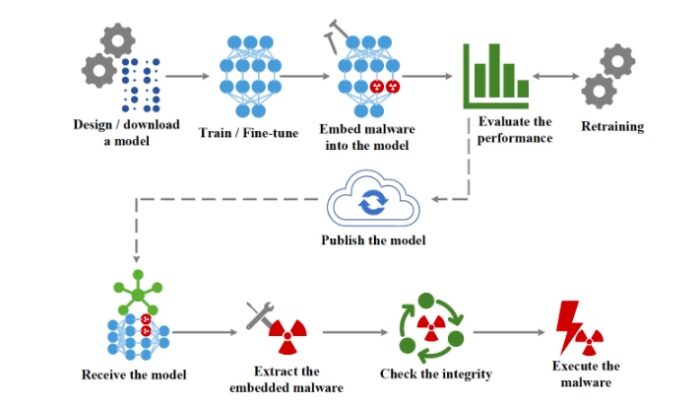

Основна ідея EvilModel – вбудувати шкідливе ПЗ у параметри нейронної мережі таким чином, щоб воно було невидимим для сканерів шкідливих програм. Це форма стеганографії, практика приховування одного фрагмента інформації в іншому. Водночас, заражена модель глибокого навчання повинна виконувати своє основне завдання (наприклад, класифікацію зображень) так само або майже так само добре, як чиста модель, щоб не викликати підозр або не робити її марною для своїх жертв. Нарешті, у зловмисника має бути механізм доставки зараженої моделі на цільові пристрої та вилучення шкідливого програмного забезпечення з параметрів нейронної мережі.

У більшості моделей глибокого навчання для зберігання значень параметрів використовуються 32-бітові (4 байти) числа з плаваючою комою. Згідно з експериментами дослідників, зловмисник може зберігати до 3 байтів шкідливого ПЗ у кожному параметрі, не впливаючи на його значення. При зараженні моделі глибокого навчання зловмисник розбиває шкідливу програму на 3-байтові частини та вбудовує дані у її параметри. Щоб доставити шкідливе програмне забезпечення до цілі, зловмисник може опублікувати заражену нейронну мережу в одному з декількох онлайн-сховищ, в яких розміщені моделі глибокого навчання, такі як GitHub або TorchHub. Як альтернативу зловмисник може організувати складнішу форму атаки на ланцюжок поставок, коли заражена модель доставляється через автоматичні оновлення програмного забезпечення, встановленого на цільовому пристрої.

Щойно заражена модель доставляється жертві, частина програмного забезпечення отримує корисне навантаження і виконує її.

Щоб перевірити реалізованість EvilModel, дослідники протестували її на кількох згорткових нейронних мережах (CNN). Моделі були заражені вісьма зразками бази даних InQuest, які онлайн-сканер VirusTotal розпізнав як шкідливі. Після того, як зразки були вбудовані в нейронні мережі, вся модель була завантажена в VirusTotal, але була позначена як безпечна, що доводить, що шкідлива програма була добре прихована. Дослідники протестували різні техніки на кількох архітектурах CNN і отримали аналогічні результати, які показують, що використання шкідливих програм є універсальною загрозою для великих нейронних мереж.

Оскільки сканери шкідливих програм не можуть виявляти шкідливі корисні навантаження, вбудовані в моделі глибокого навчання, єдиним контрзаходом проти EvilModel є знищення шкідливого програмного забезпечення. Поки дослідники не знайдуть надійніші методи виявлення та блокування шкідливих програм у глибоких нейронних мережах, ми повинні встановити ланцюжок довіри у конвеєрах машинного навчання. Знаючи, що сканери шкідливих програм та інструменти статичного аналізу не можуть виявити заражені моделі, розробники повинні переконатися, що їх моделі надходять із надійних джерел, а походження навчальних даних та вивчених параметрів не порушується. Продовжуючи вивчати безпеку глибокого навчання, ми маємо побоюватися того, що ховається за мільйонами чисел, які обробляються для аналізу наших фотографій та розпізнавання наших голосів.

Читайте також:

- ООН: 37% населення планети ніколи не користувалися Інтернетом

- Clearview AI запатентувала свою неоднозначну технологію розпізнавання облич