Trudno uwierzyć w rewolucję SI. I nie chodzi o politykę – chodzi o matematykę. Problemem są złudzenia SI.

Wyobraź sobie świat, w którym kalkulator czasami mówi, że 2+2=5. Albo gdzie oprogramowanie księgowe wymyśla transakcje, które nigdy nie miały miejsca. Brzmi absurdalnie, prawda? A jednak właśnie w taki świat wkraczamy wraz z dzisiejszą rewolucją AI.

Link afiliacyjny: Pobierz aplikację Raiffeisen Digital Bank, by mieć kontrolę nad budżetem

Od samego początku ery cyfrowej jedna rzecz była pewna – komputery mogły się zawiesić, drukarki mogły się źle zachowywać, a użytkownicy mogli zostać doprowadzeni do szaleństwa przez niebieskie ekrany śmierci. Ale przez to wszystko ufano, że zrobią jedną rzecz bezbłędnie: wykonają obliczenia. Ten fundament zaufania, budowany przez dziesięciolecia, jest obecnie stale niszczony przez to, co eksperci nazywają halucynacjami sztucznej inteligencji.

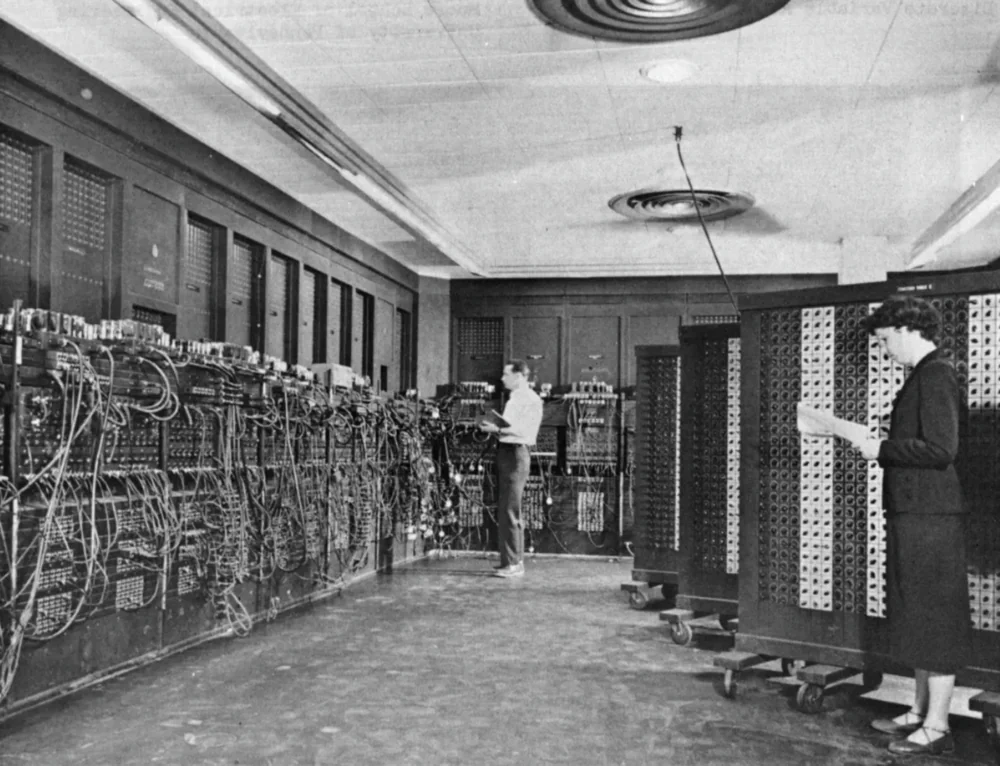

Historia komputerów nie zaczęła się od mediów społecznościowych czy gier wideo, ale od potrzeby wykonywania złożonych obliczeń. Pierwszy komputer elektroniczny ogólnego przeznaczenia, ENIAC, zajmował pomieszczenie o wymiarach 7 na 13 metrów i mieścił prawie 18 000 lamp próżniowych wraz z tysiącami przekaźników. Ta ogromna maszyna została opracowana w celu obliczania tabel ostrzału artyleryjskiego i pomocy w pracach nad bombą wodorową. Mogła wykonywać 5000 dodawań, 350 mnożeń lub 40 podziałów na sekundę – szybciej niż cokolwiek, co można było sobie wyobrazić w tamtym czasie.

Od tego czasu minęło ponad 75 lat, a komputery przeszły dramatyczną transformację. Z gigantów wielkości pokoju ewoluowały w urządzenia na tyle małe, że mieszczą się w naszych kieszeniach. Jednak pomimo wszystkich rewolucji technologicznych, ich główny cel pozostał taki sam – komputery to przede wszystkim maszyny zbudowane do obliczeń.

Przeczytaj również: Technofeudalizm – nowa forma porządku światowego

Excel – matematyka, której możesz zaufać

Dobrym przykładem tej ciągłości jest Microsoft Excel – program, który w swej istocie nadal jest zaawansowanym kalkulatorem wizualnym. Przez dziesięciolecia Excel stał się kręgosłupem globalnej gospodarki, używanym przez wszystkich, od małych firm po międzynarodowe korporacje, od budżetowania domowego po złożone modele finansowe Wall Street. Choć ma on swoich krytyków i ograniczenia, jedna rzecz pozostaje niezmienna: jego obliczenia są niezawodne.

Oczywiście w Excelu również mogą wystąpić błędy. Powszechnym przykładem jest komunikat #VALUE!, który pojawia się, gdy próbujemy wykonać operacje matematyczne na tekście zamiast na liczbach. Ale – i to jest kluczowa różnica – takie błędy zawsze mają jasne, możliwe do zidentyfikowania przyczyny i proste poprawki. Co ważniejsze, Excel nigdy nie zgaduje ani nie wymyśla wyników. Formuła =SUM(A1:A10) zawsze zwróci ten sam wynik dla tych samych danych wejściowych, niezależnie od tego, czy uruchamiasz ją po raz pierwszy, czy tysięczny.

Ta deterministyczna natura tradycyjnego oprogramowania od dziesięcioleci wzmacnia nasze zaufanie do komputerów. Mogliśmy narzekać na interfejsy użytkownika, wydajność lub kompatybilność, ale nigdy nie kwestionowaliśmy matematycznej dokładności wyników.

Przeczytaj również: Chipset Qualcomm Snapdragon X Elite do laptopów: wszystko, co musisz wiedzieć

I to prowadzi nas do sedna dzisiejszej rewolucji sztucznej inteligencji. Nowoczesne modele sztucznej inteligencji – w szczególności duże modele językowe (LLM) – zasadniczo różnią się od tradycyjnego oprogramowania. Zamiast wykonywać określone, deterministyczne operacje, są one zaprojektowane do rozpoznawania wzorców w ogromnych zbiorach danych i generowania wiarygodnych odpowiedzi w oparciu o te wzorce.

Ta fundamentalna zmiana w architekturze prowadzi do tego, co eksperci nazywają halucynacjami AI – przypadkami, w których modele AI generują informacje, które wydają się prawdziwe, ale są całkowicie niepoprawne lub oderwane od rzeczywistości. Co ważne, halucynacje te nie są przypadkowymi błędami; są one wynikiem samej natury tych systemów – złożonej interakcji między danymi szkoleniowymi, konstrukcją modelu i sposobem, w jaki model interpretuje zapytania.

Najbardziej niepokojącym aspektem jest to, że halucynacje AI często pojawiają się z takim samym poziomem pewności, jak faktyczne informacje. Model może śmiało stwierdzić, że Kijów jest stolicą Ukrainy (co jest prawdą) i że był gospodarzem Letnich Igrzysk Olimpijskich w 1995 roku (co jest całkowicie sfabrykowane). Dla użytkownika, zwłaszcza niebędącego ekspertem, odróżnienie faktów od halucynacji może być niezwykle trudne.

Przeczytaj także: 10 zawodów przyszłości, które powinieneś wybrać już dziś

Skala problemu halucynacji

Chociaż trudno jest ustalić dokładne statystyki dotyczące częstotliwości występowania halucynacji u sztucznej inteligencji, eksperci zgadzają się, że jest to powszechny problem dotykający wszystkie duże modele językowe. Systemy najbardziej podatne na halucynacje to te, które nie posiadają skutecznych mechanizmów weryfikacji informacji, opierają się na nieaktualnych danych i nie interpretują prawidłowo kontekstu zapytań.

Przyczyny halucynacji są złożone i wielowarstwowe. Wśród głównych czynników eksperci wskazują na

-

Niedoskonałości danych treningowych: Jeśli dane wykorzystywane do trenowania modelu zawierają błędy, nieścisłości lub sprzeczne informacje, model może powielać te kwestie lub generować nowe, fałszywe treści.

- Nadmierne dopasowanie modelu: Dzieje się tak, gdy algorytm zbyt ściśle dostosowuje się do zestawu danych szkoleniowych, tracąc zdolność do generalizacji i prawidłowej identyfikacji nowych wzorców.

- Wadliwe założenia w projekcie modelu: Jeśli twórcy sztucznej inteligencji opierają swój projekt na błędnych założeniach, model może konsekwentnie generować halucynacje.

Konkretne przykłady systemów sztucznej inteligencji, szczególnie podatnych na halucynacje, obejmują chińskie rozwiązania, takie jak Qwen i DeepSeek. Pomimo zaawansowania technologicznego, modele te nadal borykają się z tym problemem. Często generują informacje, które wydają się wiarygodne, ale w rzeczywistości są fałszywe lub niezgodne z rzeczywistością, zwłaszcza w kontekstach, w których dane mogą być niekompletne lub sprzeczne.

Przeczytaj również: Czy słuchawki z redukcją szumów są szkodliwe? Spostrzeżenia audiologów

Problem zaufania – 98% to wciąż za mało

I tu dochodzimy do fundamentalnej kwestii zaufania. W tradycyjnym oprogramowaniu błędy były wyjątkami, a nie regułą. W przypadku sztucznej inteligencji halucynacje są nieodłączną częścią działania systemu. Nawet jeśli model generuje dokładne informacje w 98% przypadków, pozostałe 2% stanowi poważny problem.

Wyobraź sobie, że korzystasz z kalkulatora, który daje prawidłowy wynik w 98% przypadków, ale w 2% przypadków podaje błędną odpowiedź. Czy zaufalibyśmy takiemu urządzeniu przy zadaniach takich jak obliczanie podatków, opracowywanie leków czy projektowanie mostów? Odpowiedź jest jasna.

Kwestia halucynacji AI jest szczególnie istotna w dziedzinach, które wymagają pełnej dokładności i poprawności faktów, takich jak medycyna, prawo, finanse i inżynieria. W tych obszarach nawet najmniejszy błąd może prowadzić do katastrofalnych konsekwencji.

Przeczytaj również: Wszystko o procesorze kwantowym Microsoft Majorana 1: Przełom czy ewolucja?

Excel kontra sztuczna inteligencja: obliczenia kontra konfabulacje

W programie Excel, gdy pojawia się błąd taki jak #WARTOŚĆ!, program wyraźnie wskazuje, że coś poszło nie tak. Nie próbuje odgadnąć wyniku ani ukryć problemu. Co więcej, istnieją konkretne zalecenia dotyczące rozwiązywania takich błędów – na przykład upewnienie się, że wszystkie wartości w formule matematycznej są liczbami, a nie tekstem.

Z drugiej strony, w przypadku systemów sztucznej inteligencji, gdy model nie zna odpowiedzi, często generuje przekonującą, ale fałszywą odpowiedź, zamiast przyznać się do braku wiedzy. Najgorsze jest to, że użytkownik może nawet nie zdawać sobie sprawy, że dostarczone informacje są halucynacją.

Według raportu Salesforce na temat stanu danych i analityki, 9 na 10 (prawie 87%) analityków i liderów IT zgadza się, że postęp w sztucznej inteligencji nadał zarządzaniu danymi wyższy priorytet. Jednak ten sam raport podkreśla niepewność respondentów co do dokładności danych i obawy dotyczące bezpieczeństwa danych w kontekście sztucznej inteligencji.

Przeczytaj również: Wirtualna pamięć RAM w smartfonie: co to jest i jak to działa

Koszt weryfikacji jest ukrytą wadą sztucznej inteligencji

Zwolennicy sztucznej inteligencji twierdzą, że kwestię halucynacji można rozwiązać poprzez weryfikację informacji. Rzeczywiście, sprawdzanie faktów i walidacja wyników systemów sztucznej inteligencji stają się podstawowymi praktykami w każdej organizacji, która wykorzystuje te technologie. Problem polega jednak na tym, że potrzeba weryfikacji znacznie zmniejsza wartość tych systemów.

Wyobraź sobie taką sytuację – prosimy asystenta AI o napisanie raportu na temat rynku pojazdów elektrycznych. System generuje 20-stronicowy dokument wypełniony statystykami, trendami i prognozami. Dokument wygląda profesjonalnie i zawiera przekonujące argumenty. Problem polega na tym, że nie wiemy, które części informacji są dokładne, a które są wynikiem halucynacji AI. Aby to ustalić, musielibyśmy zweryfikować każdą statystykę, każde stwierdzenie, każdy fakt. Oznacza to, że w efekcie wykonujemy pracę, którą system AI miał wykonać za nas.

Jest to podstawowy paradoks obecnej rewolucji AI – systemy, które miały zaoszczędzić nam czas, często wymagają dodatkowej pracy, aby zweryfikować ich wyniki. W przypadku korzystania z tradycyjnego oprogramowania, takiego jak Excel, możemy po prostu zaufać wynikom obliczeń i skupić się na interpretacji danych.

Przeczytaj również: Kodeki audio Bluetooth: co to i jak przełączać się między nimi w Android

Matematycznie niedoskonały świat AI

Brak zaufania do systemów sztucznej inteligencji nie jest kwestią technofobii czy oporu przed zmianami. Jest to racjonalna reakcja na fundamentalną zmianę w relacjach między ludźmi a komputerami. Przez dziesięciolecia budowaliśmy relacje oparte na deterministycznej niezawodności maszyn obliczeniowych. Teraz wkraczamy w erę modeli probabilistycznych, które z natury nie mogą zagwarantować tego samego poziomu niezawodności.

Być może najtrafniejszym sposobem opisania tego jest analogia do komunikacji międzyludzkiej. Tradycyjne oprogramowanie jest jak encyklopedia – może być niekompletne lub zawierać nieaktualne informacje, ale to, co jest w nim zawarte, można uznać za sprawdzone. Sztuczna inteligencja natomiast przypomina rozmowę z osobą, która posiada imponującą, ale niedoskonałą wiedzę – czasami popełnia błędy, czasami się myli, a czasami zniekształca fakty.

Ta analogia, w kontekście komputerów, oznacza fundamentalny regres pod względem niezawodności. Zawsze oczekiwaliśmy większej dokładności od maszyn niż od ludzi. Teraz, paradoksalnie, musimy weryfikować wyniki generowane przez sztuczną inteligencję z taką samą ostrożnością, jaką zastosowalibyśmy do informacji od nieznanej osoby.

Przeczytaj również: Elektronika: innowacyjne podejście do podsłuchów i sprzętu szpiegowskiego

W poszukiwaniu matematycznej wiarygodności

Czy oznacza to, że powinniśmy całkowicie porzucić sztuczną inteligencję? Absolutnie nie. Systemy AI mają ogromny potencjał w różnych dziedzinach – od generowania kreatywnych treści po analizę ogromnych zbiorów danych. Problem polega na tym, że musimy nauczyć się nowego podejścia do pracy z tymi systemami, takiego, które uznaje ich fundamentalne ograniczenia.

Obecnie trwają intensywne badania nad ograniczeniem halucynacji AI. Proponowane rozwiązania obejmują poprawę jakości danych treningowych (im lepsze dane, tym mniejsze prawdopodobieństwo halucynacji), opracowanie bardziej przejrzystych metod treningowych (modele, które są zrozumiałe i wytłumaczalne, rzadziej generują fałszywe informacje) oraz rozwój mechanizmów sprawdzania faktów (systemy, które automatycznie weryfikują generowane treści w oparciu o wiarygodne źródła).

Nowa etyka cyfrowej rzeczywistości

Obecna rewolucja w dziedzinie sztucznej inteligencji wymaga nie tylko nowych narzędzi i metodologii, ale także nowych ram etyki cyfrowej. Musimy ponownie przemyśleć, co oznacza zaufanie między ludźmi a maszynami, granice odpowiedzialności za błędy spowodowane przez sztuczną inteligencję i jak chronić się przed dezinformacją w świecie, w którym granica między faktem a fikcją staje się coraz bardziej rozmyta.

Według raportu Salesforce badającego zaufanie do danych w erze sztucznej inteligencji, zagrożenia bezpieczeństwa i brak harmonizacji danych utrudniają ich wiarygodność. Dlatego firmy, które wykorzystują dane oparte na sztucznej inteligencji do podejmowania krytycznych decyzji, uważają zagrożenia bezpieczeństwa danych za swoje największe obawy.

Jest to szczególnie ważne w kontekście tzw. sztucznej inteligencji generatywnej, która niesie ze sobą dodatkowe ryzyko wycieku danych firmowych do publicznie dostępnych dużych modeli językowych.

Przeczytaj również: Recenzja Anker Soundcore Liberty 4 Pro: flagowy zestaw słuchawkowy TWS z unikalnymi funkcjami

Zamiast tysiąca słów…

Nie ufam obecnej rewolucji AI nie dlatego, że nie widzę jej potencjału, ale dlatego, że rozumiem jej fundamentalne ograniczenia. Przez dziesięciolecia budowaliśmy naszą cyfrową cywilizację na fundamencie niezawodnych obliczeń – począwszy od najwcześniejszych kalkulatorów mechanicznych, poprzez monumentalny ENIAC, aż po wszechobecne arkusze kalkulacyjne. Ta matematyczna pewność była kamieniem węgielnym postępu w niezliczonych dziedzinach życia.

Obecna fala sztucznej inteligencji wprowadza nas w probabilistyczny świat, w którym 98% pewności jest nową normą. Chociaż może to być wystarczające dla wielu zastosowań, znacznie wyższe standardy są wymagane w krytycznych obszarach, takich jak opieka zdrowotna, finanse i bezpieczeństwo.

Prawdziwym wyzwaniem jest więc wykorzystanie potencjału sztucznej inteligencji bez utraty matematycznej pewności, która przez dziesięciolecia była podstawą naszego zaufania do technologii. Podczas gdy komputery mogą teraz rozmawiać, tworzyć obrazy i pisać wiersze, ich najważniejszą funkcją pozostają bezbłędne obliczenia – ta sama funkcja, którą pełniły, gdy kiedyś wypełniały całe pokoje i były obsługiwane przez zespoły naukowców w fartuchach laboratoryjnych. Ponieważ w świecie, w którym odróżnienie faktów od fikcji staje się coraz trudniejsze, matematyczna pewność jest cenniejsza niż kiedykolwiek.

Przeczytaj również: