Точний опис зображення, а не просто як у нетямущого робота, довгий час був метою штучного інтелекту (ШІ). У 2016 році Google заявила, що її штучний інтелект може підписувати зображення майже так само, як люди, з точністю 94%. Тепер Microsoft заявляє, що пішла ще далі: її дослідники створили систему штучного інтелекту, яка навіть точніша, ніж люди – настільки, що тепер вона знаходиться на вершині таблиці лідерів в тесті Nocaps Image Captioning. Microsoft стверджує, що вона у два рази краще, ніж попередня модель підписів до зображень.

І хоча це само по собі чудова віха, Microsoft не просто залишає цю технологію собі. Тепер вона пропонує нову модель субтитрів як частину когнітивних служб Azure, тому будь-який розробник може використовувати її в своїх застосунках. Вона також доступна вже сьогодні в Seeing AI, застосунку Microsoft для сліпих і слабозорих користувачів, який може розповідати про навколишній світ. А пізніше в цьому році модель субтитрів також поліпшить ваші презентації в PowerPoint для Інтернету, Windows і Mac. Вона також з’явиться в Word і Outlook на настільних платформах.

«Одна з найскладніших проблем в штучному інтелекті, – сказав Ерік Бойд, CVP Azure AI, в інтерв’ю Engadget. – Це не тільки розуміння об’єктів в сцені, а й те, як вони взаємодіють, і як їх описати». Вдосконалені методи створення субтитрів можуть допомогти кожному користувачеві: це спрощує пошук зображень, які вам потрібні в пошукових системах. А для користувачів з ослабленим зором це може значно поліпшити навігацію мережею і програмним забезпеченням.

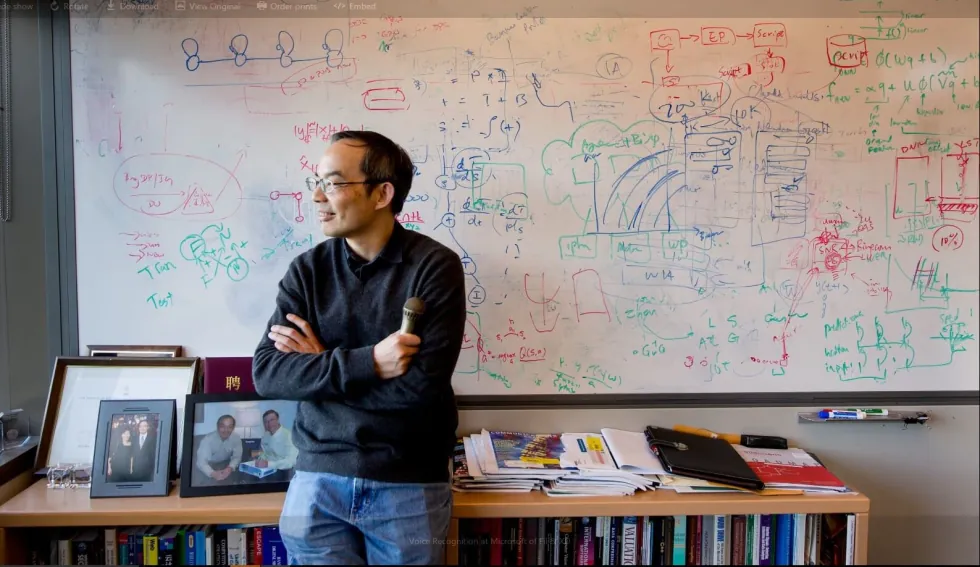

Немає нічого незвичайного в тому, що компанії рекламують свої дослідницькі інновації в галузі ШІ, але набагато рідше ці відкриття можуть бути швидко використані у продуктах. Сюєдун Хуанг, технічний директор когнітивних служб Azure AI, наполягав на швидкій інтеграції цієї служби в Azure через потенційні переваги для користувачів. Його команда навчила модель зображень, позначеним певними ключовими словами, що допомогло надати їй візуальну мову, якої немає у більшості фреймворків ШІ. Як правило, моделі такого типу навчаються з використанням зображень і повних підписів, що ускладнює моделювання взаємодії між конкретними об’єктами.

Але попри те, що перевершити еталонний тест важливо, справжнім випробуванням для нової моделі Microsoft буде те, як вона працює в реальному світі. За словами Бойда, розробника Seeing AI Сакиба Шайка, який є сліпою людиною та також наполягає на більшій її доступності, описує це як різке поліпшення в порівнянні з попередньою пропозицією. І тепер, коли Microsoft встановила нову віху, буде цікаво подивитися, як будуть конкурувати моделі від Google і інших дослідників.

Читайте також:

- У Пенсільванському університеті розробили технологію друку сенсорів прямо на шкірі

- Зроблено революційне відкриття у сфері невралгії